For folk som ikke er kjent med koding, kan det være vanskelig å lage en nettskraper. Heldigvis er programvare for nettskraping tilgjengelig for både programmerere og ikke-programmerere. Nettskrapingsprogramvare er spesielt utviklet programvare for å hente relevante data fra nettsider. Disse verktøyene er fordelaktige for alle som ønsker å skaffe data fra Internett på en eller annen måte. Denne informasjonen er registrert i en lokal fil på datamaskinen eller i en database. Det er teknikken for autonom innsamling av data for nettet. Vi bringer til en liste over de 31 beste gratis verktøyene for nettskraping.

Innholdsfortegnelse

31 beste verktøy for nettskraping

En utvalgt liste over de beste verktøyene for nettskraping finner du her. Denne listen inneholder både kommersielle og åpen kildekodeverktøy, samt lenker til respektive nettsteder.

1. Overliste

Outwit er et Firefox-tillegg som er enkelt å installere fra Firefox-tilleggsbutikken.

- Dette dataskrapeverktøyet gjør det enkelt å samle kontakter fra nettet og via e-post.

- Avhengig av dine behov, vil du ha tre alternativer for å kjøpe dette produktet.

- Pro

-

Ekspert, og

-

Enterprise-utgaver er tilgjengelige.

- Eksakt data fra nettsteder som bruker Outwit-hub krever ingen programmeringskunnskap.

- Du kan begynne å skrape hundrevis av nettsider med et enkelt klikk på utforske-knappen.

2. PareseHub

ParseHub er et annet av de beste gratis verktøyene for nettskraping.

- Før du laster ned data, må du rydde opp i tekst og HTML.

- Det er så enkelt som å velge dataene du vil trekke ut ved å bruke vår sofistikerte nettskraper.

- Det er et av de beste dataskrapingsverktøyene siden det lar deg lagre utskrapte data i alle formater for videre analyse.

- Det brukervennlige grafiske grensesnittet

- Dette Internett-skrapeverktøyet lar deg automatisk høste og lagre data på servere.

3. Apify

Apify er enda et av de beste verktøyene for nettskraping og automatisering som lar deg konstruere et API for ethvert nettsted, med innebygde proxyer for boliger og datasenter som gjør datautvinning enklere.

- Apify tar seg av infrastruktur og fakturering, slik at utviklere kan tjene passive penger ved å designe verktøy for andre.

- Noen av kontaktene som er tilgjengelige er Zapier, Integromat, Keboola og Airbyte.

- Apify Store har ferdige skrapeløsninger for populære nettsteder som Instagram, Facebook, Twitter og Google Maps.

- JSON, XML, CSV, HTML og Excel er alle strukturerte skjemaer som kan lastes ned.

- HTTPS, geolokaliseringsmålretting, smart IP-rotasjon og Google SERP-proxyer er alle funksjoner i Apify Proxy.

- Gratis 30-dagers proxy-prøveperiode med en plattformkreditt på USD 5.

4. Skrapestack

Scrapestack brukes av over 2000 firmaer, og de er avhengige av dette unike API-et, som drives av apilayer. Det er et av de beste gratis verktøyene for nettskraping.

- Bruker en verdensomspennende IP-adressepool på 35 millioner datasentre.

- Lar mange API-forespørsler utføres samtidig.

- Både CAPTCHA-dekryptering og JavaScript-gjengivelse støttes.

- Det er både gratis og betalte alternativer tilgjengelig.

- Scrapestack er en online skraping REST API som opererer i sanntid.

- Scrapestack API lar deg skrape nettsider på millisekunder ved å bruke millioner av proxy-IP-er, nettlesere og CAPTCHA-er.

- Forespørsler om nettskraping kan sendes fra mer enn 100 forskjellige steder over hele verden.

5. FMiner

For Windows og Mac OS er FMiner et populært nettbasert program for skraping, datautvinning, krypende skjermskraping, makro og webstøtte.

- Data kan samles inn fra dynamiske Web 2.0-nettsteder som er vanskelige å gjennomgå.

- Lar deg lage et datautvinningsprosjekt ved hjelp av den visuelle editoren, som er enkel å bruke.

- Bruker en kombinasjon av lenkestrukturer, rullegardinmenyer og URL-mønstertilpasning for å la deg grave ned gjennom nettsider.

- Du kan bruke tredjeparts automatiske decaptcha-tjenester eller manuell inndata for å målrette CAPTCHA-beskyttelse på nettstedet.

6. Sekvens

Sequentum er et robust stordataverktøy for å skaffe pålitelige nettdata. Det er et annet av de beste gratis verktøyene for nettskraping.

- Sammenlignet med alternative løsninger blir det raskere å trekke ut nettdata.

- Du kan bytte mellom flere plattformer ved å bruke denne funksjonen.

- Det er en av de kraftigste nettskraperne for å utvide bedriften din. Den inneholder enkle funksjoner, inkludert en visuell pek-og-klikk-editor.

- Den dedikerte web-API-en vil hjelpe deg med å utvikle nettapper ved å la deg kjøre nettdata rett fra nettstedet ditt.

7. Agentskap

Agenty er et dataskraping-, tekstutvinning- og OCR-program som bruker Robotic Process Automation.

- Dette programmet lar deg gjenbruke alle dine behandlede data til analyseformål.

- Du kan bygge en agent med bare noen få museklikk.

- Du vil motta en e-postmelding etter at oppgaven er fullført.

- Den lar deg koble til Dropbox og bruke sikker FTP.

- Alle aktivitetslogger for alle forekomster er tilgjengelige for å se.

- Hjelper deg med å forbedre bedriftens suksess.

- Lar deg enkelt implementere forretningsregler og tilpasset logikk.

8. Import.io

Ved å importere data fra en bestemt nettside og eksportere dataene til CSV, hjelper import.io nettskraping-applikasjonen deg med å lage datasettene dine. Det er også et av de beste verktøyene for nettskraping. Følgende er funksjonene til dette verktøyet.

- Nettskjemaer/pålogginger er enkle å bruke.

- Det er en av de beste dataskrapingsløsningene for å utnytte APIer og webhooks for å integrere data i apper.

- Du kan få innsikt via rapporter, diagrammer og visualiseringer.

- Datautvinning bør planlegges på forhånd.

- Import.io sky lar deg lagre og få tilgang til data.

- Interaksjon med nettet og arbeidsflyter kan automatiseres.

9. Webz.io

Webz.io lar deg gjennomsøke hundrevis av nettsteder og få tilgang til strukturerte og sanntidsdata med en gang. Det er også et av de beste gratis verktøyene for nettskraping.

Du kan anskaffe organiserte, maskinlesbare datasett i JSON- og XML-formater.

- Det gir deg tilgang til historiske feeder som strekker seg over ti år med data.

- Gir deg tilgang til en stor database med datastrømmer uten å måtte betale ekstra utgifter.

- Du kan bruke et avansert filter for å utføre detaljerte analyser og matedatasett.

10. Skrapugle

Scrape Owl er en nettskrapeplattform som er enkel å bruke og økonomisk.

- Scrape Owls primære mål er å skrape alle typer data, inkludert e-handel, jobbtavler og eiendomsoppføringer.

- Før du trekker ut materialet, kan du kjøre tilpasset JavaScript.

- Du kan bruke steder for å omgå lokale restriksjoner og få tilgang til lokalt innhold.

- Gir en pålitelig ventefunksjon.

- Helsides JavaScript-gjengivelse støttes.

- Denne applikasjonen kan brukes direkte på et Google-ark.

- Tilbyr en gratis prøveperiode på 1000 kreditter for å prøve ut tjenesten før du kjøper et medlemskap. Det er ikke nødvendig å bruke kredittkort.

11. Skrapebi

Scrapingbee er et nettskraping-API som tar seg av proxy-innstillinger og hodeløse nettlesere.

- Den kan kjøre Javascript på sidene og rotere proxyer for hver forespørsel, slik at du kan lese rå HTML uten å bli svartelistet.

- Et annet API for å trekke ut Google-søkeresultater er også tilgjengelig.

- JavaScript-gjengivelse støttes.

- Den har en funksjon for automatisert proxy-rotasjon.

- Denne applikasjonen kan brukes direkte på Google Sheets.

- Chrome-nettleseren kreves for å bruke programmet.

- Den er ideell for Amazon-skraping.

- Den lar deg skrape Google-resultater.

12. Lyse data

Bright Data er verdens ledende online dataplattform, og tilbyr en kostnadseffektiv løsning for å samle offentlige nettdata i stor skala, enkelt konvertere ustrukturerte data til strukturerte data og gi en overlegen kundeopplevelse samtidig som den er fullstendig transparent og kompatibel.

- Den er den mest tilpasningsdyktige siden den kommer med ferdiglagde løsninger og er utvidbar og justerbar.

- Bright Datas neste generasjons Data Collector gir en automatisert og personlig flyt av data på ett enkelt dashbord, uavhengig av størrelsen på samlingen.

- Den er åpen 24 timer i døgnet, syv dager i uken, og tilbyr kundestøtte.

- Fra e-handelstrender og sosiale nettverksdata til konkurrentintelligens og markedsundersøkelser, datasett er skreddersydd for bedriftens behov.

- Du kan konsentrere deg om din primære virksomhet ved å automatisere tilgang til pålitelige data i din bransje.

- Det er det mest effektive siden det bruker kodefrie løsninger og bruker færre ressurser.

- Mest pålitelig, med data av beste kvalitet, høyere oppetid, raskere data og bedre kundeservice.

13. Scraper API

Du kan bruke Scraper API-verktøyet til å håndtere proxyer, nettlesere og CAPTCHA-er.

- Verktøyet gir uovertruffen hastighet og pålitelighet, og gjør det mulig å lage skalerbare nettskrapere.

- Du kan hente HTML-en fra hvilken som helst nettside med et enkelt API-kall.

- Det er enkelt å sette opp siden alt du trenger å gjøre er å sende en GET-forespørsel med din API-nøkkel og URL til API-endepunktet.

- Lar JavaScript gjengis enklere.

- Den lar deg tilpasse forespørselstypen og overskriftene for hver forespørsel.

- Roterende proxyer med en geografisk plassering

14. Dexi Intelligent

Dexi intelligent er et nettbasert skrapeprogram som lar deg gjøre en hvilken som helst mengde nettdata til rask kommersiell verdi.

- Dette online skrapeverktøyet lar deg spare penger og tid for bedriften din.

- Den har forbedret produktivitet, nøyaktighet og kvalitet.

- Det muliggjør den raskeste og mest effektive datautvinningen.

- Den har et storskala kunnskapsfangstsystem.

15. Diffbot

Diffbot lar deg raskt få tak i en rekke viktige fakta fra internett.

- Med AI-ekstraktorer vil du kunne trekke ut nøyaktige strukturerte data fra hvilken som helst URL.

- Du vil ikke bli belastet for tidkrevende skraping av nettsider eller manuell forespørsel.

- For å bygge et fullstendig og nøyaktig bilde av hvert objekt, slås mange datakilder sammen.

- Du kan trekke ut strukturerte data fra hvilken som helst URL med AI Extractors.

- Med Crawlbot kan du skalere opp utvinningen til titusenvis av domener.

- Knowledge Graph-funksjonen gir nettet nøyaktige, fullstendige og dype data som BI trenger for å levere meningsfull innsikt.

16. Datastreamer

Data Streamer er en teknologi som lar deg hente sosialt nettverksmateriale fra hele internett.

- Det er en av de største nettskrapere som bruker naturlig språkbehandling for å hente viktige metadata.

-

Kibana og Elasticsearch brukes til å gi integrert fulltekstsøk.

- Basert på informasjonsinnhentingsalgoritmer, integrert fjerning av kjeleplater og innholdsutvinning.

- Bygget på en feiltolerant infrastruktur for å gi høy informasjonstilgjengelighet.

17. Mozenda

Du kan trekke ut tekst, bilder og PDF-materiale fra nettsider ved å bruke Mozenda.

- Du kan bruke ditt valg Bl-verktøy eller database for å samle inn og publisere online data.

- Det er et av de beste skrapeverktøyene på nettet for å organisere og formatere datafiler for publisering.

- Med et pek-og-klikk-grensesnitt kan du lage nettskrapemidler på få minutter.

- For å samle nettdata i sanntid, bruk funksjonene Job Sequencer og Request Blocking.

- Kontobehandling og kundeservice er blant de beste i bransjen.

18. Data Miner Chrome-utvidelse

Nettskraping og datafangst gjøres enklere med Data Miner nettleserplugin.

- Den har muligheten til å gjennomsøke flere sider i tillegg til dynamisk datautvinning.

- Datavalg kan gjøres på en rekke måter.

- Den undersøker informasjonen som har blitt skrapet.

- Det Data som er skrapet kan lagres som en CSV-fil.

- Lokal lagring brukes til å lagre skrapte data.

- Chrome-tillegget Web Scraper henter data fra dynamiske nettsteder.

- it Sitemaps kan importeres og eksporteres.

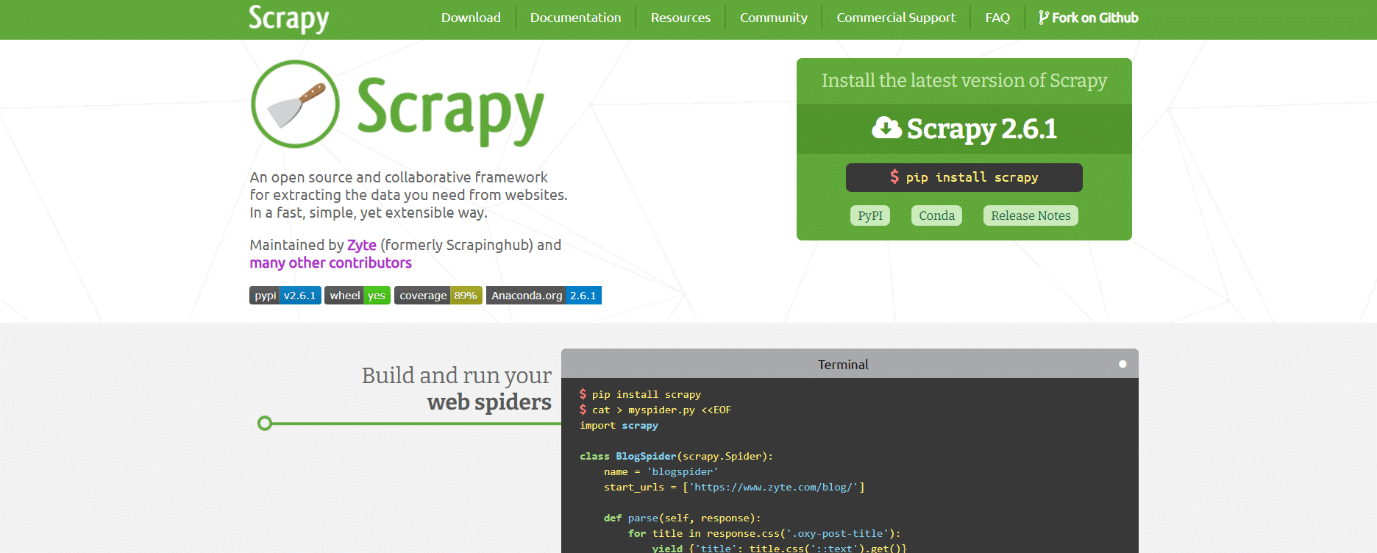

19. Scrapy

Scrapy er også et av de beste verktøyene for nettskraping. Det er et Python-basert åpen kildekode-rammeverk for nettskraping for å lage nettskrapere.

- Den gir deg alle verktøyene du trenger for raskt å trekke ut data fra nettsteder, analysere dem og lagre dem i strukturen og formatet du velger.

- Dette dataskrapeverktøyet er et must hvis du har et stort dataskrapingprosjekt og ønsker å gjøre det så effektivt som mulig samtidig som du bevarer mye fleksibilitet.

- Dataene kan eksporteres som JSON, CSV eller XML.

- Linux, Mac OS X og Windows støttes alle.

- Den er utviklet på toppen av Twisted asynkron nettverksteknologi, som er en av nøkkelfunksjonene.

- Scrapy er kjent for sin enkelhet i bruk, omfattende dokumentasjon og aktive fellesskap.

20. ScrapeHero Cloud

ScrapeHero har tatt sine mange års kunnskap om nettgjennomgang og gjort det til økonomiske og brukervennlige forhåndsbygde crawlere og APIer for å skrape data fra nettsteder som Amazon, Google, Walmart og andre.

- ScrapeHero Cloud-søkeroboter inkluderer automatisk roterende proxyer og muligheten til å kjøre mange søkeroboter samtidig.

- Du trenger ikke å laste ned eller lære hvordan du bruker dataskrapingsverktøy eller programvare for å bruke ScrapeHero Cloud.

- ScrapeHero Cloud-søkeroboter lar deg skrape data umiddelbart og eksportere dem i JSON-, CSV- eller Excel-formater.

- ScrapeHero Clouds gratis- og lite-planklienter mottar e-posthjelp, mens alle andre planer mottar Priority-service.

- ScrapeHero Cloud-søkeroboter kan også konfigureres for å møte spesifikke kundekrav.

- Det er en nettleserbasert nettskraper som fungerer med alle nettlesere.

- Du trenger ingen programmeringskunnskap eller å utvikle en skraper; det er like enkelt som å klikke, kopiere og lime inn!

21. Dataskraper

Data Scraper er et gratis online skrapeprogram som skraper data fra en enkelt nettside og lagrer det som CSV- eller XSL-filer.

- Det er en nettleserutvidelse som konverterer data til et pent tabellformat.

- Installering av programtillegget krever bruk av Google Chrome-nettleseren.

- Du kan skrape 500 sider hver måned med gratisversjonen; men hvis du ønsker å skrape flere sider, må du oppgradere til en av de dyre planene.

22. Visual Web Ripper

Visual Web Ripper er et automatisk dataskrapingsverktøy for nettsteder.

- Datastrukturer samles inn fra nettsteder eller søkeresultater ved hjelp av dette verktøyet.

- Du kan eksportere data til CSV-, XML- og Excel-filer, og det har et brukervennlig grensesnitt.

- Den kan også hente data fra dynamiske nettsteder, for eksempel de som bruker AJAX.

- Du trenger bare å sette opp noen få maler, og nettskraperen vil håndtere resten.

- Visual Web Ripper tilbyr planleggingsalternativer og sender deg til og med en e-post hvis et prosjekt mislykkes.

23. Octoparse

Octoparse er en brukervennlig applikasjon for skraping av nettsider med et visuelt grensesnitt. Det er et av de beste gratis verktøyene for nettskraping. Følgende er funksjonene til dette verktøyet.

- Pek-og-klikk-grensesnittet gjør det enkelt å velge informasjonen du ønsker å skrape fra et nettsted. Octoparse kan håndtere både statiske og dynamiske nettsider takket være AJAX, JavaScript, informasjonskapsler og andre funksjoner.

- Avanserte skytjenester som lar deg trekke ut store mengder data er nå tilgjengelige.

- Den skrapte informasjonen kan lagres som TXT-, CSV-, HTML- eller XLSX-filer.

- Gratisversjonen av Octoparse lar deg konstruere opptil 10 crawlere; betalte medlemskapsplaner inkluderer imidlertid funksjoner som en API og et stort antall anonyme IP-proxyer, som vil øke hastigheten på utvinningen og lar deg laste ned store mengder data i sanntid.

24. Web Harvey

WebHarveys visuelle nettskraper har en innebygd nettleser for å skrape data fra nettsider. Det er også et av de beste verktøyene for nettskraping. Her er noen av funksjonene til dette verktøyet.

- Den tilbyr et pek-og-klikk-grensesnitt som gjør det enkelt å velge elementer.

- Denne skrapen har fordelen av at du ikke trenger å skrive noen kode.

-

CSV-, JSON- og XML-filer kan brukes til å lagre dataene.

- Det er også mulig å lagre det i en SQL-database. WebHarvey har en kategoriskrapingsfunksjon på flere nivåer som kan skrape data fra listesider ved å følge hvert nivå av kategoritilkoblinger.

- Vanlige uttrykk kan brukes med internettskrapeverktøyet, noe som gir deg ekstra frihet.

- Du kan sette opp proxy-servere for å holde IP-en din skjult mens du henter data fra nettsteder, slik at du kan bevare en viss grad av personvern.

25. PySpider

PySpider er også et av de beste gratis verktøyene for nettskraping, som er en Python-basert webcrawler. Noen funksjoner i dette verktøyet er listet opp nedenfor.

- Den har en distribuert arkitektur og støtter Javascript-sider.

- Du kan ha mange robotsøkeprogrammer på denne måten. PySpider kan lagre data på hvilken som helst backend du velger, inkludert MongoDB, MySQL, Redis og andre.

- Meldingskøer som RabbitMQ, Beanstalk og Redis er tilgjengelige.

- En av PySpiders fordeler er det enkle brukergrensesnittet, som lar deg endre skript, overvåke løpende aktiviteter og undersøke resultater.

- Informasjonen kan lastes ned i JSON- og CSV-formater.

- PySpider er Internett-skrapen å vurdere hvis du jobber med et nettstedbasert brukergrensesnitt.

- Det fungerer også med nettsteder som bruker mye AJAX.

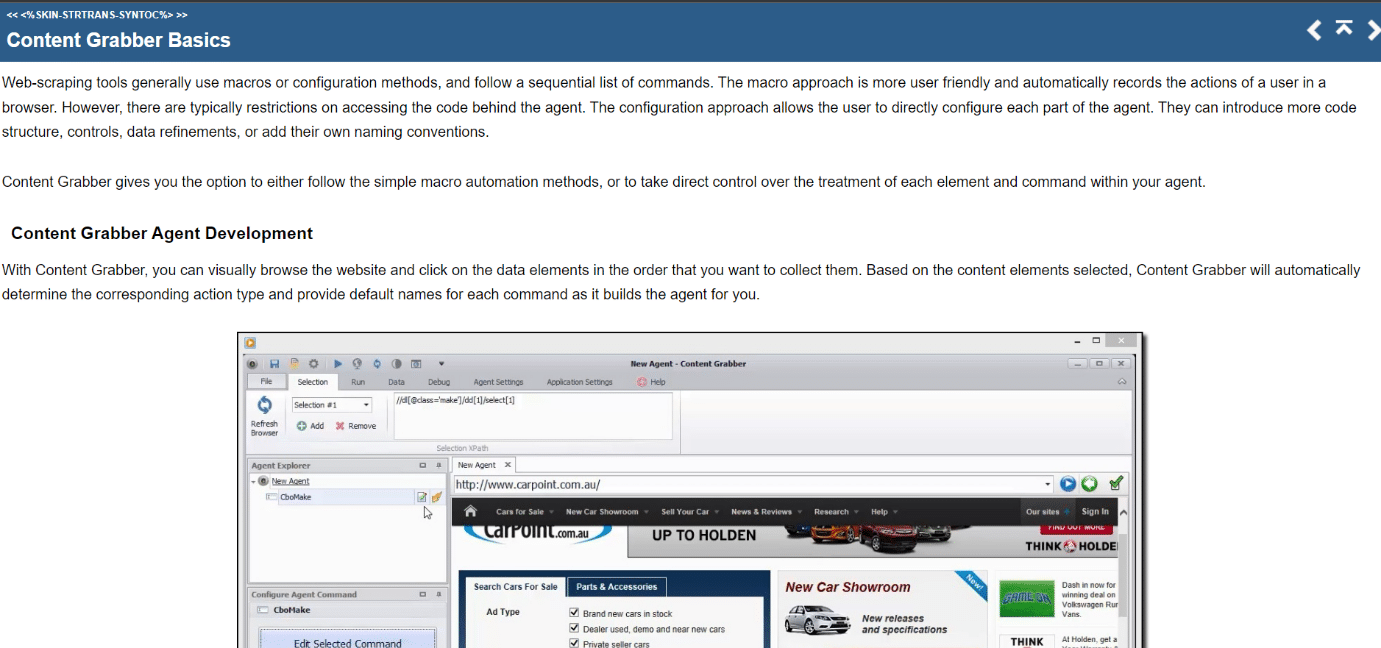

26. Innholdsgrabber

Content Grabber er et visuelt online skrapeverktøy med et brukervennlig pek-og-klikk-grensesnitt for å velge elementer. Følgende er funksjonene til dette verktøyet.

- CSV, XLSX, JSON og PDF er formatene som data kan eksporteres i. Det kreves mellomliggende programmeringskunnskaper for å bruke dette verktøyet.

- Paginering, ubegrensede rullesider og popup-vinduer er alle mulige med brukergrensesnittet.

- Den har også AJAX/Javascript-behandling, en captcha-løsning, støtte for regulære uttrykk og IP-rotasjon (ved hjelp av Nohodo).

27. Kimurai

Kimurai er et Ruby nettskrapingsrammeverk for å lage skrapere og trekke ut data. Det er også et av de beste gratis verktøyene for nettskraping. Her er noen av funksjonene til dette verktøyet.

- Det lar oss skrape og samhandle med JavaScript-produserte nettsider rett ut av esken med Headless Chromium/Firefox, PhantomJS eller grunnleggende HTTP-spørringer.

- Den har en lignende syntaks som Scrapy og konfigurerbare alternativer, inkludert innstilling av en forsinkelse, roterende brukeragenter og standardoverskrifter.

- Den samhandler også med nettsider ved hjelp av Capybara-testrammeverket.

28. Cheerio

Cheerio er et annet av de beste verktøyene for nettskraping. Det er en pakke som analyserer HTML- og XML-dokumenter og lar deg operere med de nedlastede dataene ved å bruke jQuery-syntaksen. Følgende er funksjonene til dette verktøyet.

- Hvis du utvikler en JavaScript-nettskraper, gir Cheerio API et raskt valg for å analysere, endre og vise data.

- Den gjengir ikke utdata i en nettleser, bruker ikke CSS, laster inn eksterne ressurser eller kjører JavaScript.

- Hvis noen av disse funksjonene er nødvendige, bør du se på PhantomJS eller JSDom.

29. Dukkespiller

Puppeteer er en Node-pakke som lar deg administrere Googles hodeløse Chrome-nettleser ved hjelp av en kraftig, men enkel API. Noen funksjoner i dette verktøyet er listet opp nedenfor.

- Den kjører i bakgrunnen og utfører kommandoer gjennom en API.

- En hodeløs nettleser er en som er i stand til å sende og motta forespørsler, men som mangler et grafisk brukergrensesnitt.

- Puppeteer er den rette løsningen for oppgaven hvis informasjonen du leter etter genereres ved hjelp av en kombinasjon av API-data og Javascript-kode.

- Du kan etterligne brukerens opplevelse ved å skrive og klikke på de samme stedene de gjør.

- Puppeteer kan også brukes til å ta skjermbilder av nettsider som vises som standard når en nettleser åpnes.

30. Dramatiker

Playwright er et Microsoft Node-bibliotek designet for nettleserautomatisering. Det er et annet av de beste gratis verktøyene for nettskraping. Her er noen av funksjonene til dette verktøyet.

- Den tilbyr kompetent, pålitelig og rask nettautomatisering på tvers av nettlesere.

- Playwright var ment å forbedre automatisert UI-testing ved å fjerne flak, øke utførelseshastigheten og gi innsikt i hvordan nettleseren fungerer.

- Det er en moderne nettleserautomatiseringsapplikasjon som kan sammenlignes med Puppeteer på mange måter og leveres med forhåndsinstallerte kompatible nettlesere.

- Dens største fordel er kompatibilitet på tvers av nettlesere siden den kan kjøre Chromium, WebKit og Firefox.

- Playwright integreres med Docker, Azure, Travis CI og AppVeyor med jevne mellomrom.

31. PJScrape

PJscrape er et Python-basert online skrapeverktøysett som bruker Javascript og JQuery. Følgende er funksjonene til dette verktøyet.

- Den er designet for å fungere med PhantomJS, slik at du kan skrape nettsteder fra kommandolinjen i en fullstendig gjengitt, Javascript-aktivert kontekst, uten behov for en nettleser.

- Dette innebærer at du ikke bare har tilgang til DOM, men også Javascript-variabler og funksjoner, så vel som AJAX-lastet innhold.

- Skrapefunksjonene vurderes i sammenheng med hele nettleseren.

***

Vi håper at denne veiledningen var nyttig om de beste verktøyene for nettskraping. Fortell oss hvilket verktøy du synes er enkelt for deg. Fortsett å besøke siden vår for flere kule tips og triks og legg igjen kommentarer nedenfor.