SEO-loggfilanalyse hjelper deg med å forstå søkerobotens oppførsel på nettstedet og identifisere potensielle tekniske SEO-optimaliseringsmuligheter.

SEO uten å analysere søkerobotenes oppførsel er som å fly blind. Du kan ha sendt inn nettstedet på Googles søkekonsoll og indeksert det, men uten å studere loggfilene vil du ikke få en ide om nettstedet ditt blir gjennomsøkt eller lest av søkemotorroboter på riktig måte eller ikke.

Det er derfor jeg har samlet alt du trenger å vite for å analysere SEO-loggfiler og identifisere problemer og SEO-muligheter fra dem.

Innholdsfortegnelse

Hva er loggfilanalyse?

Analyse av SEO-loggfiler er en prosess for å gjenkjenne mønsteret av søkemotorroboters interaksjon med nettstedet. Loggfilanalyse er en del av teknisk SEO.

Revisjon av loggfiler er viktig for SEO-er for å gjenkjenne og løse problemene knyttet til gjennomsøking, indeksering, statuskoder.

Hva er loggfiler?

Loggfiler sporer hvem som besøker et nettsted og hvilket innhold de ser. De inneholder informasjon om hvem som har bedt om tilgang til nettstedet (også kjent som «Klienten»).

Informasjonen som oppfattes kan være relatert til søkemotorroboter som Google eller Bing eller en besøkende på nettstedet. Vanligvis blir loggfilposter samlet inn og vedlikeholdt av nettstedets webserver, og de blir vanligvis oppbevart i en viss tid.

Hva inneholder loggfilen?

Før du vet viktigheten av loggfiler for SEO, er det viktig å vite hva som er i denne filen. Loggfilen e inneholder følgende datapunkter:-

- Side-URL som den besøkende på nettstedet ber om

- HTTP-statuskoden for siden

- Forespurt server IP-adresse

- Dato og klokkeslett for treffet

- Data fra brukeragenten (søkemotorroboten) som sender en forespørsel

- Forespørselsmetode (GET/POST)

Loggfiler kan virke kompliserte for deg hvis du ser på dem først. Likevel, når du først vet hensikten og viktigheten av loggfiler for SEO, vil du bruke dem effektivt til å generere verdifull SEO-innsikt.

Formålet med loggfilanalyse for SEO

Loggfilanalyse hjelper deg med å løse noen av de viktige tekniske SEO-problemene, som lar deg lage en effektiv SEO-strategi for å optimalisere nettstedet.

Her er noen SEO-problemer som kan analyseres ved hjelp av loggfiler:

#1. Hyppighet av Googlebot som gjennomsøker nettstedet

Søkemotorroboter eller crawlere bør gjennomsøke de viktige sidene dine ofte, slik at søkemotoren vet om nettstedoppdateringer eller nytt innhold.

Dine viktige produkt- eller informasjonssider skal alle vises i Googles logger. En produktside for et produkt du ikke lenger selger, samt fraværet av noen av de viktigste kategorisidene dine, er indikatorer på et problem som kan gjenkjennes ved hjelp av loggfiler.

Hvordan bruker en søkemotorrobot gjennomsøkingsbudsjettet?

Hver gang en søkemotorsøkerobot besøker nettstedet ditt, har det et begrenset «gjennomsøkingsbudsjett». Google definerer et gjennomsøkingsbudsjett som summen av et nettsteds gjennomsøkingshastighet og etterspørsel etter gjennomsøking.

Gjennomgang og indeksering av et nettsted kan bli hindret hvis det har mange URL-er med lav verdi eller URL-er som ikke er korrekt sendt inn i nettstedskartet. Det er enklere å gjennomsøke og indeksere nøkkelsider hvis gjennomsøkingsbudsjettet ditt er optimalisert.

Loggfilanalyse hjelper til med å optimalisere gjennomsøkingsbudsjettet som akselererer SEO-innsatsen.

#2. Mobile-first indekseringsproblemer og status

Mobile-first-indeksering er nå viktig for alle nettsteder, og Google foretrekker det. Loggfilanalyse vil fortelle deg hvor ofte smarttelefonen Googlebot gjennomsøker nettstedet ditt.

Denne analysen hjelper nettredaktører med å optimalisere nettsidene for mobilversjoner hvis sidene ikke blir korrekt gjennomsøkt av smarttelefonen Googlebot.

#3. HTTP-statuskode returnert av nettsider når du blir bedt om det

Nylige svarkoder nettsidene våre returnerer kan hentes enten ved hjelp av loggfiler eller ved å bruke alternativet for henting og gjengivelse i Google Search Console.

Loggfilanalysatorer kan finne sidene med 3xx-, 4xx- og 5xx-kodene. Du kan løse disse problemene ved å iverksette passende handlinger, for eksempel å omdirigere URL-ene til de riktige destinasjonene eller endre 302-statuskodet til 301.

#4. Analyserer gjennomsøkingsaktivitetene som gjennomsøkingsdybde eller interne lenker

Google setter pris på nettstedets struktur basert på gjennomsøkingsdybden og interne koblinger. Årsaker bak feil gjennomsøking av nettstedet kan være dårlig sammenkoblingsstruktur og gjennomsøkingsdybde.

Hvis du har problemer med nettstedets hierarki eller nettstedstruktur, eller interlink-struktur, kan du bruke loggfilanalyse for å finne dem.

Loggfilanalyse hjelper til med å optimalisere nettstedsarkitekturen og sammenkoblingsstrukturen.

#4. Oppdag foreldreløse sider

Foreldreløse sider er nettsidene på nettstedet som ikke er koblet fra noen annen side. Det er vanskelig for slike sider å bli indeksert eller vises i søkemotorer, da de ikke er lett å oppdage av roboter.

Foreldreløse sider kan enkelt oppdages av crawlere som Screaming Frog, og dette problemet kan løses ved å koble disse sidene sammen med de andre sidene på nettstedet.

#5. Revider sidene for sidehastighet og -opplevelse

Sideerfaring og kjernenettverk er offisielt rangeringsfaktorene nå, og det er viktig nå at nettsider er i samsvar med Googles retningslinjer for sidehastighet.

Langsomme eller store sider kan oppdages ved hjelp av loggfilanalysatorer, og disse sidene kan optimaliseres for sidehastighet som vil hjelpe til med den generelle rangeringen på SERP.

Loggfilanalyse hjelper deg med å få kontroll over hvordan nettstedet ditt gjennomsøkes og hvordan søkemotorer håndterer nettstedet ditt

Nå, ettersom vi er klare med det grunnleggende om loggfiler og deres analyse, la oss se på prosessen med å revidere loggfilene for SEO

Hvordan gjøre loggfilanalyse

Vi har allerede sett på ulike aspekter ved loggfiler og viktigheten av SEO. Nå er det på tide å lære prosessen med å analysere filene og de beste verktøyene for å analysere loggfilene.

Du trenger tilgang til nettstedets serverloggfil for å få tilgang til loggfilen. Filene kan analyseres på følgende måter:

Det er forskjellige trinn involvert i å få tilgang til loggfilene manuelt.

- Samle inn eller eksporter loggdataene fra webserveren, og dataene skal filtreres for søkemotorroboter eller crawlere.

- Konverter den nedlastede filen til et lesbart format ved hjelp av dataanalyseverktøy.

- Analyser dataene manuelt ved å bruke excel eller andre visualiseringsverktøy for å finne SEO-hull og muligheter.

- Du kan også bruke filtreringsprogrammer og kommandolinjer for å gjøre jobben din enkel

Manuelt arbeid med filenes data er ikke lett da det krever kunnskap om Excel og involverer utviklingsteamet. Likevel gjør verktøy for loggfilanalyse jobben enkel for SEO-er.

La oss se på de beste verktøyene for å revidere loggfilene og forstå hvordan disse verktøyene hjelper oss med å analysere loggfilene.

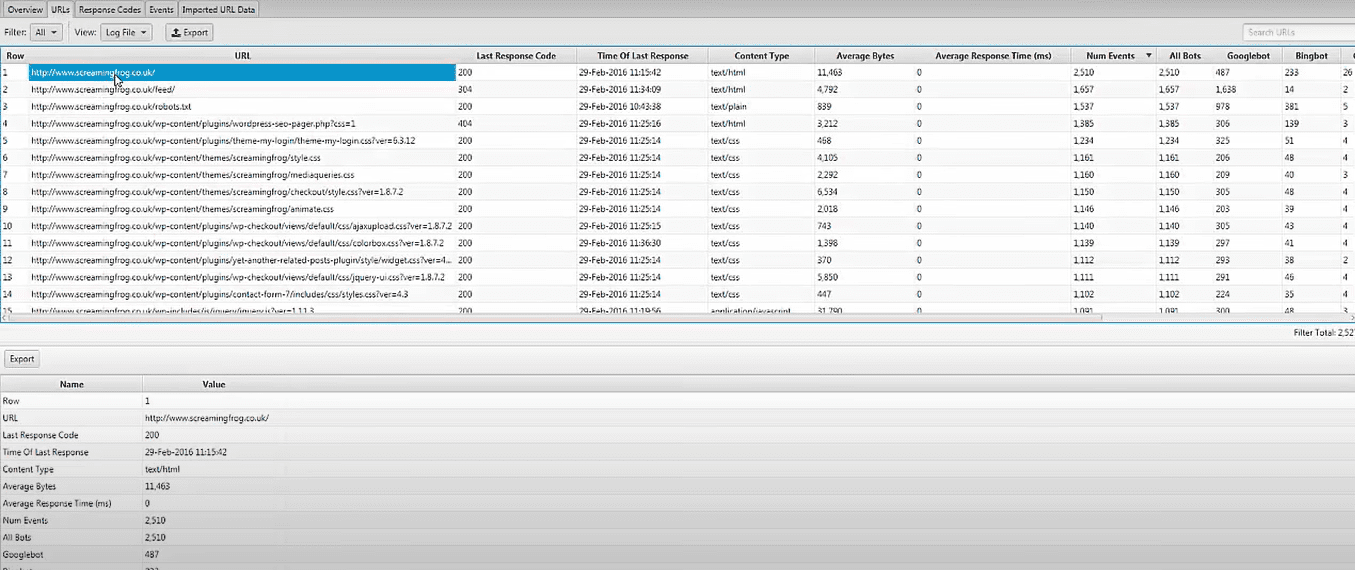

Screaming Frog Log File Analyzer

Tekniske SEO-problemer kan identifiseres ved å bruke opplastede loggfildata og søkemotorroboter verifisert ved hjelp av Screaming Frog Log File Analyzer. Du kan også gjøre som følger:

- Søkemotorbotaktivitet og data for søkemotoroptimalisering.

- Oppdag nettstedets gjennomsøkingsfrekvens av søkemotorroboter

- Finn ut om alle de tekniske SEO-problemene og eksterne og interne ødelagte koblinger

- Analyse av nettadresser som har blitt gjennomsøkt minst og mest for å redusere tap og øke effektiviteten.

- Oppdag sider som ikke blir gjennomsøkt av søkemotorer.

- Alle data kan sammenlignes og kombineres, som inkluderer eksterne lenkedata, direktiver og annen informasjon.

- Se dataene om henvisningsadresser

Screaming Frog loggfilanalysatorverktøy er helt gratis å bruke for et enkelt prosjekt med en grense på 1000 linjelogghendelser. Du må oppgradere til den betalte versjonen hvis du vil ha ubegrenset tilgang og teknisk assistanse.

JetOctopus

Når det gjelder rimelige logganalysatorverktøy, er JetOctopus best. Den har en syv-dagers gratis prøveversjon, ingen kredittkort nødvendig, og en tilkobling med to klikk. Gjennomsøkingsfrekvens, gjennomsøkingsbudsjett, mest populære sider og mer kan alle identifiseres ved hjelp av JetOctopus logganalysatorakkurat som de andre verktøyene på listen vår.

Med dette verktøyet kan du integrere loggfildata med Google Search Console-data, noe som gir deg en klar fordel over konkurrentene. Med denne kombinasjonen vil du kunne se hvordan Googlebot samhandler med nettstedet ditt og hvor du kan forbedre deg.

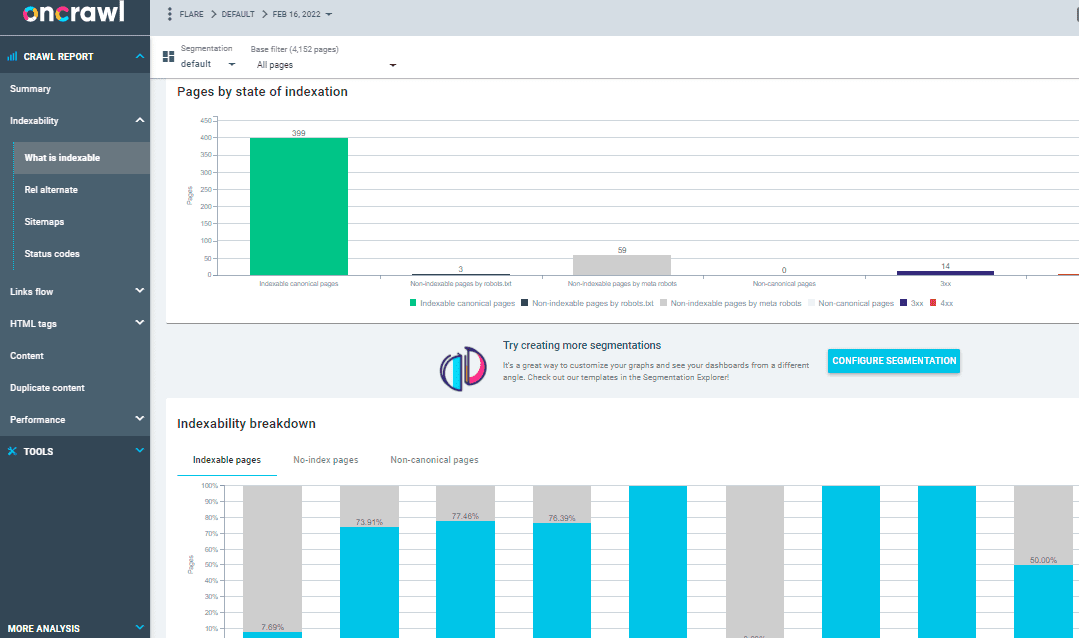

På Crawl Log Analyzer

Over 500 millioner logglinjer per dag behandles av Oncrawl Log Analyzer, et verktøy utviklet for mellomstore til store nettsteder. Den holder øye med nettserverloggene i sanntid for å sikre at sidene dine blir riktig indeksert og gjennomsøkt.

Oncrawl Log Analyzer er GDPR-kompatibel og svært sikker. I stedet for IP-adresser lagrer programmet alle loggfiler i en sikker og segregert FTP-sky.

Foruten JetOctopus og Screaming Frog Log File Analyzer, har Oncrawl noen flere funksjoner, for eksempel:

- Støtter mange loggformater, som IIS, Apache og Nginx.

- Verktøyet tilpasser seg enkelt til dine behandlings- og lagringskrav etter hvert som de endres

- Dynamisk segmentering er et kraftig verktøy for å avdekke mønstre og sammenhenger i dataene dine ved å gruppere URL-ene og interne lenker basert på ulike kriterier.

- Bruk datapunkter fra de rå loggfilene dine for å lage handlingsrettede SEO-rapporter.

- Loggfiler overført til FTP-plassen din kan automatiseres ved hjelp av teknisk personale.

- Alle de populære nettleserne kan overvåkes, som inkluderer Google, Bing, Yandex og Baidus robotsøkeprogrammer.

OnCrawl Log Analyzer har to viktige verktøy:

Oncrawl SEO Crawler: Med Oncrawl SEO Crawler kan du gjennomsøke nettstedet ditt i høy hastighet og med minimale ressurser. Forbedrer brukerens forståelse av hvordan rangeringskriterier påvirker søkemotoroptimalisering (SEO).

Ved gjennomsøkingsdata: Oncrawl-data analyserer alle SEO-faktorene ved å kombinere data fra gjennomsøkingen og analyser. Den henter dataene fra crawl- og loggfilene for å forstå crawl-atferden og anbefaler crawl-budsjettet til prioritert innhold eller rangering av sider.

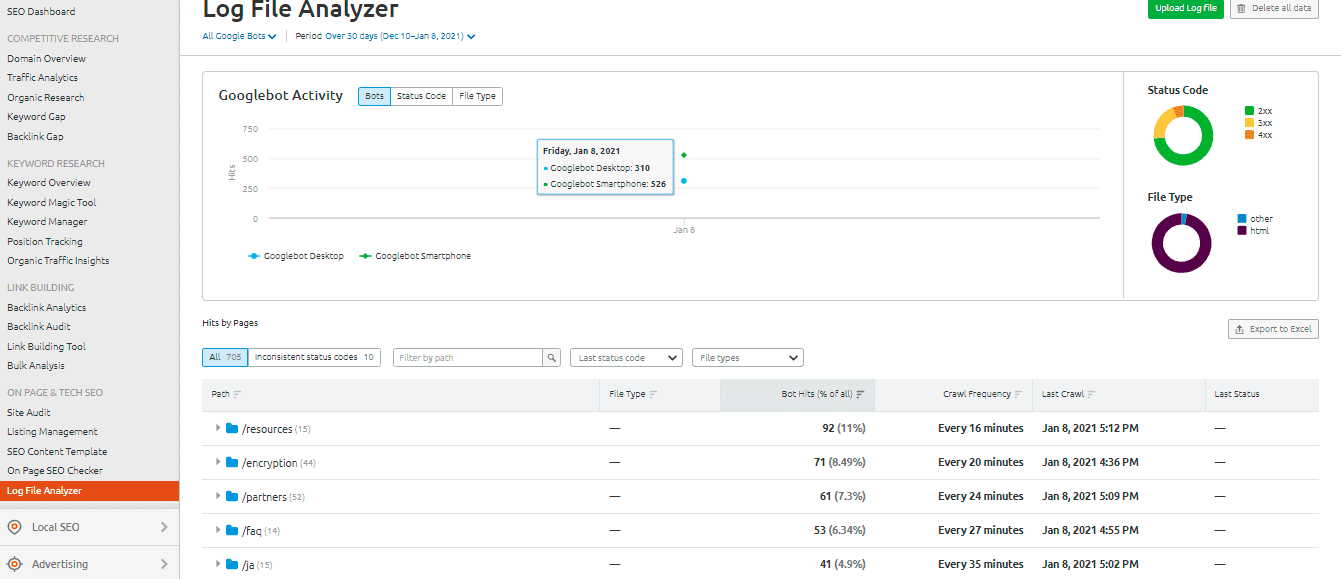

SEMrush Log File Analyzer

De SEMrush Log File Analyzer er et smart valg for et enkelt, nettleserbasert logganalyseverktøy. Denne analysatoren krever ikke nedlasting og kan brukes i nettversjonen.

SEMrush presenterer deg to rapporter:

Pages» treff: Pages» Hits rapporterer webcrawlernes interaksjon med nettstedets innhold. Den gir deg dataene til sider, mapper og nettadresser med maksimal og minimum interaksjon med roboter.

Aktiviteten til Googlebot: Googlebot-aktivitetsrapporten gir nettstedet relatert innsikt på daglig basis, for eksempel:

- Typer av gjennomsøkte filer

- Den generelle HTTP-statuskoden

- Antallet forespørsler gjort til nettstedet ditt av ulike roboter

Loggly fra SolarWinds

SolarWinds» Loggly undersøker tilgangs- og feilloggene til webserveren din, samt nettstedets ukentlige beregninger. Du kan se loggdataene dine når som helst, og den har funksjoner som gjør det enkelt å søke gjennom logger.

Et robust verktøy for loggfilanalyse som SolarWinds Loggly er nødvendig for å effektivt utvinne loggfilene på webserveren din for informasjon om suksess eller feil på ressursforespørsler fra klienter.

Loggly kan tilby diagrammer som viser de minst vanlige sidene og beregne gjennomsnitt, minimum og maksimum sideinnlastingshastigheter for å hjelpe deg med å optimalisere nettstedets søkemotoroptimalisering.

Google Search Console Crawl Stats

Google Search Console gjort ting enklere for brukerne ved å gi en nyttig oversikt over praksisen. Konsollens betjening er grei. Gjennomgangsstatistikken din vil da bli delt inn i tre kategorier:

- Kilobyte lastet ned per dag: Det indikerer kilobytene som lastes ned av Googlebots mens du besøker nettstedet. Dette indikerer i utgangspunktet to viktige punkter: Hvis høye gjennomsnitt vises i grafen, betyr det at nettstedet blir gjennomsøkt oftere, eller det kan også indikere at boten bruker lang tid på å gjennomgå et nettsted og at det ikke er lett.

- Sider gjennomsøkt per dag: Den forteller deg antall sider Googlebot gjennomsøker hver dag. Den noterer også gjennomsøkingsaktivitetsstatusen enten den er lav, høy eller gjennomsnittlig. Lav gjennomsøkingshastighet indikerer at nettstedet ikke er riktig gjennomsøkt av Googlebot

- Tid brukt på å laste ned en side (i millisekunder): Dette indikerer tiden det tar Googlebot å lage HTTP-forespørsler mens den gjennomsøker nettstedet. Mindre tiden Googlebot må bruke på å sende forespørsler, vil det være bedre å laste ned siden da indeksering vil gå raskere.

Konklusjon

Jeg håper du har fått mye ut av denne veiledningen om loggfilanalyse og verktøy som brukes til å revidere loggfilene for SEO. Revisjon av loggfilene kan være svært effektivt for å forbedre de tekniske SEO-aspektene ved nettstedet.

Google Search Console og SEMrush Log File Analyzer er to alternativer for et gratis og grunnleggende analyseverktøy. Som et alternativ kan du sjekke Screaming Frog Log File Analyzer, JetOctopus eller Oncrawl Log Analyzer for å forstå bedre hvordan søkemotorroboter samhandler med nettstedet ditt; du kan bruke blandede premium og gratis loggfilanalyseverktøy for SEO.

Du kan også se på noen avanserte søkeroboter for å forbedre SEO.