Glem å kjøpe et dedikert grafikkort, ganske snart kommer du til å spille uten et. I hvert fall hvis du er en del av 90 % av menneskene som fortsatt spiller på 1080p eller mindre. Nylige fremskritt fra både Intel og AMD betyr at deres integrerte GPU-er er i ferd med å rive opp markedet for low-end grafikkort.

Innholdsfortegnelse

Hvorfor er iGPUer så trege i utgangspunktet?

Det er to grunner: minne og dørstørrelse.

Minnedelen er lett å forstå: raskere minne tilsvarer bedre ytelse. iGPU-er får imidlertid ikke fordelene med fancy minneteknologier som GDDR6 eller HBM2, og må i stedet stole på å dele system-RAM med resten av datamaskinen. Dette er mest fordi det er dyrt å sette det minnet på selve brikken, og iGPU-er er vanligvis rettet mot budsjettspillere. Dette endrer seg ikke med det første, i hvert fall ikke fra det vi vet nå, men å forbedre minnekontrollere som gir raskere RAM kan forbedre neste generasjons iGPU-ytelse.

Den andre grunnen, formstørrelsen, er det som endrer seg i 2019. GPU-dyser er store – mye større enn CPUer, og store dies er dårlig forretning for silisiumproduksjon. Dette kommer ned til defektraten. Et større område har større sjanse for defekter, og en defekt i terningen kan bety at hele CPUen er toast.

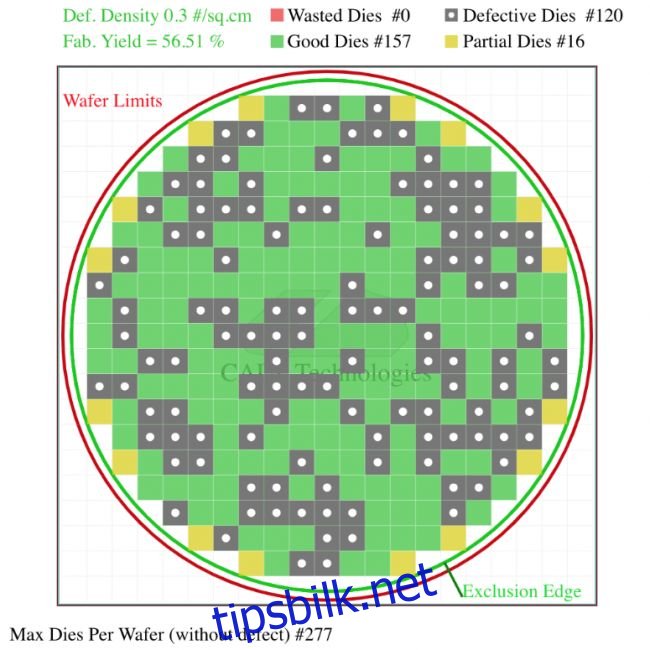

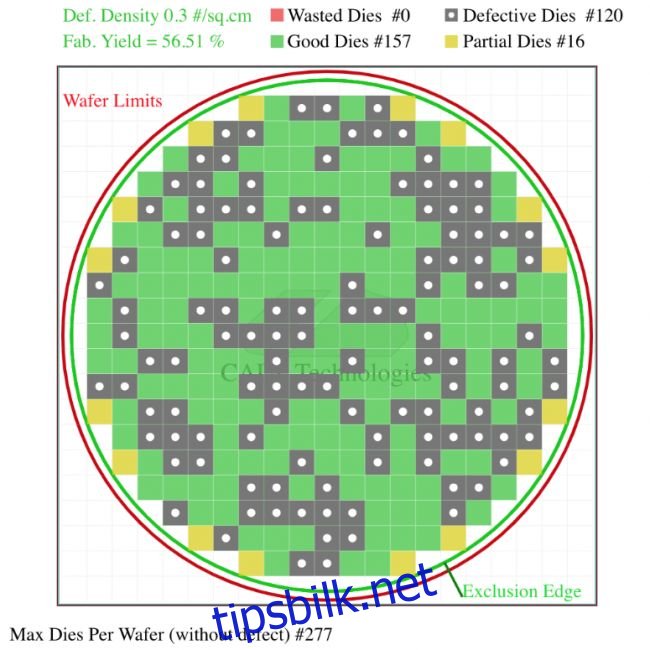

Du kan se i dette (hypotetiske) eksemplet nedenfor at dobling av formstørrelsen resulterer i mye lavere utbytte fordi hver defekt lander i et mye større område. Avhengig av hvor defektene oppstår, kan de gjøre en hel CPU verdiløs. Dette eksemplet er ikke overdrevet for effekt; avhengig av CPU, kan den integrerte grafikken ta opp nesten halvparten av terningen.

Die plass selges til forskjellige komponentprodusenter til en veldig høy premie, så det er vanskelig å rettferdiggjøre å investere massevis av plass i en mye bedre iGPU når den plassen kan brukes til andre ting som økte kjernetall. Det er ikke det at teknologien ikke er der; hvis Intel eller AMD ønsket å lage en brikke som var 90 % GPU, kunne de det, men utbyttet deres med en monolittisk design ville være så lav at det ikke engang ville være verdt det.

Gå inn: Chiplets

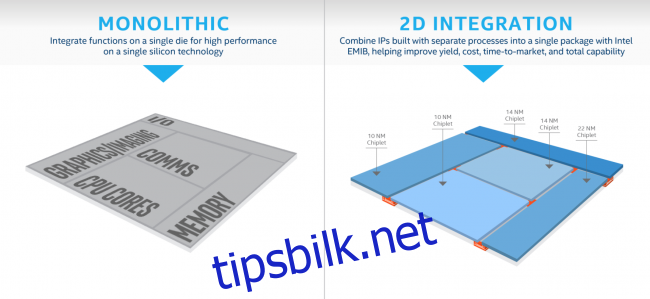

Intel og AMD har vist kortene sine, og de er ganske like. Med de nyeste prosessnodene som har høyere defektrater enn normalt, har både Chipzilla og Red Team valgt å kutte formene opp og lime dem sammen igjen i posten. Hver av dem gjør det litt forskjellig, men i begge tilfeller betyr dette at problemet med matrisstørrelsen ikke lenger er et problem, siden de kan lage brikken i mindre, billigere deler, og deretter sette dem sammen igjen når den er pakket inn i faktisk CPU.

I Intels tilfelle ser dette ut til å være mest et kostnadsbesparende tiltak. Det ser ikke ut til å endre arkitekturen mye, bare la dem velge hvilken node de skal produsere hver del av CPU-en på. Imidlertid ser det ut til at de har planer om å utvide iGPU, ettersom den kommende Gen11-modellen har «64 forbedrede utførelsesenheter, mer enn dobbelt tidligere Intel Gen9-grafikk (24 EUer), designet for å bryte 1 TFLOPS-barrieren». En enkelt TFLOP med ytelse er egentlig ikke så mye, ettersom Vega 11-grafikken i Ryzen 2400G har 1,7 TFLOPS, men Intels iGPU-er har notorisk ligget bak AMD, så det er en god ting å ta igjen.

Ryzen APU-er kan drepe markedet

AMD eier Radeon, den nest største GPU-produsenten, og bruker dem i sine Ryzen APU-er. Når vi tar en titt på deres kommende teknologi, lover dette veldig godt for dem, spesielt med 7nm-forbedringer rundt hjørnet. Det ryktes at deres kommende Ryzen-brikker bruker brikker, men annerledes enn Intel. Chipletene deres er helt separate dies, koblet over deres multifunksjonelle «Infinity Fabric»-forbindelse, som tillater mer modularitet enn Intels design (på bekostning av litt økt ventetid). De har allerede brukt brikker med stor effekt med sine 64-kjerners Epyc CPUer, annonsert tidlig i november.

Ifølge noen nylige lekkasjer, AMDs kommende Zen 2-serie inkluderer 3300G, en brikke med én åtte-kjerners CPU-brikke og én Navi 20-brikke (deres kommende grafikkarkitektur). Hvis dette viser seg å være sant, kan denne enkeltbrikken erstatte skjermkort på inngangsnivå. 2400G med Vega 11 dataenheter får allerede spillbare bildefrekvenser i de fleste spill på 1080p, og 3300G har angivelig nesten dobbelt så mange dataenheter i tillegg til å være på en nyere, raskere arkitektur.

Dette er ikke bare formodninger; det gir mye mening. Måten deres design er lagt ut på, gjør at AMD kan koble til stort sett et hvilket som helst antall brikker, den eneste begrensende faktoren er kraften og plassen på pakken. De vil nesten helt sikkert bruke to brikker per CPU, og alt de trenger å gjøre for å lage den beste iGPUen i verden er å erstatte en av disse brikkene med en GPU. De har en god grunn til å gjøre det også, siden det ikke bare ville endret spill for PC-spill, men også konsoller, ettersom de lager APU-ene for Xbox One- og PS4-serien.

De kan til og med sette noe raskere grafikkminne på die, som en slags L4-cache, men de vil sannsynligvis bruke system-RAM igjen og håper de kan forbedre minnekontrolleren på tredjegenerasjons Ryzen-produkter.

Uansett hva som skjer, har både det blå og røde laget mye mer plass å jobbe med på terningen, noe som helt sikkert vil føre til at noe i det minste blir bedre. Men hvem vet, kanskje vil de begge bare pakke inn så mange CPU-kjerner de kan og prøve å holde Moores lov i live litt lenger.