Sky-GPUer: Kraften bak moderne teknologi

Med fremveksten av avanserte teknologier som dyp læring, kunstig intelligens (AI) og maskinlæring (ML), har behovet for sky-GPUer økt betraktelig.

For organisasjoner som arbeider med 3D-visualisering, maskinlæring, kunstig intelligens eller andre krevende databehandlingsoppgaver, er effektiv GPU-beregning avgjørende.

Tradisjonelt har opplæringen av dyp læringsmodeller vært en tidkrevende og kostbar prosess for organisasjoner. Dette har ført til problemer med lagring og begrenset produktivitet.

Moderne GPUer er utviklet for å løse disse utfordringene. De tilbyr høy effektivitet for krevende beregninger og raskere opplæring av AI-modeller gjennom parallell prosessering.

Studier fra Indigo viser at GPUer kan levere 250 ganger raskere ytelse enn CPUer når det gjelder trening av nevrale nettverk for dyp læring.

Med utviklingen av skytjenester har sky-GPUer dukket opp som en transformerende kraft innen datavitenskap og andre teknologifelt. De tilbyr enda raskere ytelse, enkelt vedlikehold, reduserte kostnader, rask skalering og tidsbesparelser.

Denne artikkelen gir en innføring i sky-GPU-konsepter og forklarer hvordan de forholder seg til AI, ML og dyp læring. Vi vil også utforske noen av de beste sky-GPU-plattformene for å distribuere din foretrukne løsning.

La oss begynne!

Hva er en Sky-GPU?

For å forstå sky-GPUer, la oss først se på hva en GPU er.

En grafikkprosesseringsenhet (GPU) er en spesialisert elektronisk krets som brukes til raskt å endre og manipulere minne for å akselerere genereringen av bilder eller grafikk.

Moderne GPUer tilbyr høyere effektivitet i bildebehandling og datagrafikk enn vanlige prosessorer (CPUer), takket være deres parallelle struktur. En GPU kan være integrert i hovedkortet, plassert på et grafikkort eller være en del av en CPU-matrise.

Sky-GPUer er datamaskinforekomster med kraftig maskinvareakselerasjon, som er ideelle for å kjøre applikasjoner som håndterer store AI- og dyp læringsarbeidsbelastninger i skyen. Det er ikke nødvendig å distribuere en fysisk GPU på din egen enhet.

Populære GPU-produsenter inkluderer NVIDIA, AMD, Radeon og GeForce.

GPUer brukes i:

- Mobiltelefoner

- Spillkonsoller

- Arbeidsstasjoner

- Innebygde systemer

- Personlige datamaskiner

Hva brukes GPUer til?

Her er noen eksempler på hva GPUer brukes til:

- Bildegjenkjenning i AI og ML

- Beregninger for 3D-datagrafikk og CAD-tegninger

- Teksturkartlegging og gjengivelse av polygoner

- Geometriske beregninger, som oversettelser og rotasjoner av hjørner til koordinatsystemer

- Støtte for programmerbare shaders for manipulering av teksturer og hjørner

- GPU-akselerert videokoding, dekoding og strømming

- Grafikkintensive spill og skyspilling

- Storskala matematisk modellering, analyser og dyp læring som krever parallelle prosesseringskapasiteter

- Videoredigering, grafisk design og innholdsproduksjon

Fordelene med Sky-GPUer

De viktigste fordelene med å bruke sky-GPUer er:

Svært skalerbar

Ettersom organisasjoner vokser, øker arbeidsbelastningen. En GPU som kan skaleres for å møte den økte etterspørselen er nødvendig. Sky-GPUer lar deg enkelt legge til flere GPUer uten komplikasjoner, for å håndtere økte arbeidsbelastninger. Det er også raskt å skalere ned ved behov.

Minimale kostnader

I stedet for å investere i dyre fysiske GPUer, kan du leie sky-GPUer til en lavere pris per time. Du betaler kun for den faktiske brukstiden, i motsetning til fysiske GPUer som koster mye selv når de ikke er i bruk.

Færre lokale ressurser

Sky-GPUer bruker ikke lokale ressurser i samme grad som fysiske GPUer, som kan oppta mye plass på datamaskinen. Store ML-modeller eller tunge gjengivelsesoppgaver kan redusere datamaskinens ytelse.

Ved å flytte beregningskraften til skyen, kan datamaskinen din brukes til å kontrollere prosessene, i stedet for å håndtere selve arbeidsmengden.

Tidsbesparelse

Sky-GPUer gir designere mulighet til å raskt iterere, takket være raskere gjengivelsestider. Oppgaver som tidligere tok timer eller dager, kan nå fullføres på minutter. Dette øker teamets produktivitet og frigjør tid til innovasjon.

Hvordan hjelper GPUer med Dyp Læring og AI?

Dyp læring er fundamentet for kunstig intelligens. Det er en avansert ML-teknikk som vektlegger representasjonslæring ved hjelp av kunstige nevrale nettverk (ANN). Dyp læringsmodeller brukes til å behandle store datasett og krevende beregningsprosesser.

GPUer er designet for å utføre parallelle beregninger. Dette gjør at de kan utnytte kapasiteten til dyp læringsmodeller for å fremskynde store beregningsoppgaver.

Med mange kjerner og høy minnebåndbredde, er GPUer velegnet for å håndtere store mengder data som trengs i dyp læringssystemer. Derfor er de mye brukt for å trene AI-modeller, gjengi CAD-modeller, spille grafikkintensive videospill og mer.

Ved å bruke flere GPUer, kan du eksperimentere med forskjellige algoritmer samtidig og kjøre ulike prosesser på separate GPUer. Du kan distribuere tunge datamodeller over flere GPUer, enten på separate fysiske maskiner eller i en enkelt maskin.

Hvordan komme i gang med Sky-GPU

Det er ikke vanskelig å komme i gang med sky-GPUer. Velg en sky-GPU-leverandør, for eksempel Google Cloud Platform (GCP).

Registrer deg for GCP og dra nytte av standardfordeler som skytjenester, lagringsalternativer, databaseadministrasjon og integrasjon med applikasjoner. Du kan også bruke Google Colboratory, som fungerer som Jupyter Notebook for å bruke en GPU GRATIS. Deretter kan du begynne å bruke GPUer for dine behov.

La oss se på noen alternativer for sky-GPUer for å håndtere AI og krevende arbeidsbelastninger.

Linode

Linode tilbyr GPUer for parallell prosesseringsarbeidsbelastninger som videobehandling, vitenskapelig databehandling, maskinlæring og AI. De tilbyr GPU-optimaliserte virtuelle maskiner (VM) akselerert av NVIDIA Quadro RTX 6000, Tensor og RT-kjerner, og bruker CUDA-kraften til å utføre ray tracing, dyp læring og kompleks prosessering.

Ved å leie GPU-tilgang fra Linode kan du gjøre kapitalutgiften om til en driftskostnad, og utnytte GPU-kraften og fordelene ved skyen. Linode lar deg fokusere på kjernekompetansen i stedet for å bekymre deg for maskinvaren.

Linode-GPUer eliminerer barrierer for bruk i komplekse tilfeller som videostrømming, AI og maskinlæring. Avhengig av ytelsesbehovene for arbeidsmengden, kan du få opptil fire kort per instans.

Quadro RTX 6000 har 4 608 CUDA-kjerner, 576 Tensor-kjerner, 72 RT-kjerner, 24 GB GDDR6 GPU-minne, 84T RTX-OPS, 10 Giga Rays/sek Rays Cast, og FP32-ytelse på 16,3 TFLOPs.

Prisen for den dedikerte pluss RTX6000 GPU-planen er $1,5/time.

Paperspace CORE

Med Paperspace CORE kan du akselerere organisasjonens arbeidsflyt med neste generasjons datainfrastruktur. Plattformen tilbyr et brukervennlig grensesnitt for enkel onboarding, samarbeidsverktøy og skrivebordsapper for Mac, Linux og Windows. Bruk ubegrenset datakraft for å kjøre applikasjoner med høy etterspørsel.

CORE tilbyr et raskt nettverk, umiddelbar klargjøring, 3D-appstøtte og et fullstendig API for programmatisk tilgang. Få en full oversikt over infrastrukturen din med et intuitivt GUI. COREs administrasjonsgrensesnitt gir deg også kraftige verktøy for å filtrere, sortere, koble til eller opprette maskiner, nettverk og brukere.

COREs administrasjonskonsoll utfører oppgaver raskt, som å legge til Active Directory-integrasjon eller VPN. Du kan også enkelt administrere komplekse nettverkskonfigurasjoner med noen få klikk.

Plattformen tilbyr valgfrie integrasjoner som kan være nyttige. Få avanserte sikkerhetsfunksjoner, delte disker og mer. Dra nytte av rimelige GPUer, utdanningsrabatter og fakturering per sekund.

Startprisen for Paperspace CORE er $0,07/time.

Google Cloud GPUer

Få høyytelses GPUer for vitenskapelig databehandling, 3D-visualisering og maskinlæring med Google Cloud GPUer. Google Cloud kan bidra til å øke hastigheten på HPC (High Performance Computing), og lar deg velge mellom et bredt spekter av GPUer som matcher pris og ytelse. Du kan også minimere arbeidsmengden med maskintilpasninger og fleksible priser.

Google Cloud tilbyr mange GPUer, inkludert NVIDIA K80, P4, V100, A100, T4 og P100. I tillegg balanserer Google Cloud GPUer minne, prosessor, høyytelsesdisk og opptil 8 GPUer i hver instans for den individuelle arbeidsbelastningen.

Du får også tilgang til bransjeledende nettverk, dataanalyse og lagring. GPU-enheter er kun tilgjengelige i spesifikke soner i enkelte regioner. Prisen avhenger av region, valgt GPU og maskintype. Du kan beregne prisen ved å definere kravene i Google Cloud Pricing Calculator.

Alternativt kan du vurdere disse løsningene:

Elastisk GPU-tjeneste

Elastisk GPU-tjeneste (EGS) gir parallelle og kraftige databehandlingsmuligheter med GPU-teknologi. Den er ideell for scenarier som videobehandling, visualisering, vitenskapelig databehandling og dyp læring. EGS bruker flere GPUer, som NVIDIA Tesla M40, NVIDIA Tesla V100, NVIDIA Tesla P4, NVIDIA Tesla P100 og AMD FirePro S7150.

Du får fordeler som online dyplæringstjenester og opplæring, innholdsidentifikasjon, bilde- og stemmegjenkjenning, HD-mediekoding, videokonferanser, reparasjon av kildefilm og 4K/8K HD live.

I tillegg får du alternativer som videogjengivelse, beregningsfinansiering, klimaprediksjon, kollisjonssimulering, genteknologi, ikke-lineær redigering, fjernundervisningsapplikasjoner og ingeniørdesign.

- GA1-instansen gir opptil 4 AMD FirePro S7150 GPUer, 160 GB minne og 56 vCPUer. Den inneholder 8192 kjerner og 32 GB GPU-minne som jobber parallelt og leverer 15 TFLOPS med enkel presisjon og en TFLOPS med dobbel presisjon.

- GN4-instansen gir opptil 2 NVIDIA Tesla M40 GPUer, 96 GB minne og 56 vCPUer. Den inneholder 6000 kjerner og 24 GB GPU-minne som leverer 14 TFLOPS med enkel presisjon. Det finnes også mange andre instanser som GN5, GN5i og GN6.

- EGS støtter 25 Gbit/s og opptil 2 000 000 PPS nettverksbåndbredde internt for å gi maksimal nettverksytelse. Den har en høyhastighets lokal cache festet med SSD eller ultra cloud-disker.

- Høyytelses NVMe-stasjoner håndterer 230 000 IOPS med I/O-latens på 200 s og gir 1900 Mbit/s lesebåndbredde og 1100 Mbit/s skrivebåndbredde.

Du kan velge mellom ulike kjøpsalternativer basert på dine behov, for å få ressursene du trenger og kun betale for det du bruker.

Azure N-serien

Azure N-serien av Azure Virtual Machines (VM) har GPU-funksjoner. GPUer er ideelle for grafikk og dataintensive arbeidsbelastninger, og hjelper brukere med å utvikle innovasjon gjennom scenarier som dyp læring, prediktiv analyse og ekstern visualisering.

Ulike N-serier har egne tilbud for spesifikke arbeidsmengder.

- NC-serien fokuserer på maskinlæring og dataarbeidsbelastninger. Den siste versjonen er NCsv3, som har NVIDIAs Tesla V100 GPU.

- ND-serien fokuserer på slutnings- og treningsscenarier for dyp læring, og bruker NVIDIA Tesla P40 GPUer. Den nyeste versjonen er NDv2, som har NVIDIA Tesla V100 GPUer.

- NV-serien fokuserer på ekstern visualisering og andre intensive applikasjonsbelastninger, støttet av NVIDIA Tesla M60 GPU.

- VM-ene NC, NCsv3, ND og NCsv2 tilbyr InfiniBand-sammenkobling som muliggjør oppskalering av ytelse. Her får du fordeler som dyp læring, grafikkgjengivelse, videoredigering og spill.

IBM Cloud

IBM Cloud gir fleksibilitet, kraft og mange GPU-alternativer. Siden GPU er den ekstra hjernekraften som en CPU mangler, hjelper IBM Cloud deg med å få direkte tilgang til et bredere utvalg av servere for sømløs integrasjon med IBM Cloud-arkitekturen, applikasjonene og API-ene, samt et globalt distribuert nettverk av datasentre.

- Du får GPU-alternativer for bare-metall-servere som Intel Xeon 4210, NVIDIA T4 grafikkort, 20 kjerner, 32 GB RAM, 2,20 GHz og 20 TB båndbredde. Du får også alternativer for Intel Xeon 5218 og Intel Xeon 6248.

- For virtuelle servere får du AC1.8×60, som har åtte vCPU, 60 GB RAM og 1 x P100 GPU. Du får også alternativene AC2.8×60 og AC2.8×60.

Prisen for bare-metall-server-GPU starter på $819/måned, og den virtuelle server-GPU-en starter på $1,95/time.

AWS og NVIDIA

AWS og NVIDIA har samarbeidet om å levere kostnadseffektive, fleksible og kraftige GPU-baserte løsninger. Dette inkluderer NVIDIA GPU-drevne Amazon EC2-instanser og tjenester som AWS IoT Greengrass, som distribueres med NVIDIA Jetson Nano-moduler.

Brukere benytter AWS og NVIDIA for virtuelle arbeidsstasjoner, maskinlæring (ML), IoT-tjenester og høyytelses databehandling. Amazon EC2-instanser, der NVIDIA GPUer leverer skalerbar ytelse. AWS IoT Greengrass utvider AWS-skytjenestene til NVIDIA-baserte edge-enheter.

NVIDIA A100 Tensor Core GPUer driver Amazon EC2 P4d-instanser for å levere bransjeledende nettverk med lav latens og høy gjennomstrømning. Det finnes også mange andre instanser for spesifikke scenarier, som Amazon EC2 P3 og Amazon EC2 G4.

Du kan søke om GRATIS prøveversjon og oppleve kraften av GPU-teknologien.

OVHcloud

OVHcloud tilbyr skyservere designet for å håndtere store parallelle arbeidsbelastninger. GPUene har mange instanser integrert med NVIDIA Tesla V100 grafikkprosessorer, for å møte behov innen dyp læring og maskinlæring.

De bidrar til å akselerere databehandling innen grafisk databehandling og kunstig intelligens. OVH samarbeider med NVIDIA for å tilby en GPU-akselerert plattform for høyytelses databehandling, AI og dyp læring.

Plattformen tilbyr en enkel måte å distribuere og vedlikeholde GPU-akselererte beholdere gjennom en komplett katalog. Den leverer ett av fire kort direkte til instansene via PCI Passthrough uten noe virtualiseringslag for å dedikere all kraften til din bruk.

OVHclouds tjenester og infrastrukturer er ISO/IEC 27017, 27001, 27701 og 27018-sertifisert. Sertifiseringene indikerer at OVHcloud har et styringssystem for informasjonssikkerhet (ISMS) for å håndtere sårbarheter, implementere forretningskontinuitet, administrere risikoer og implementere et styringssystem for personverninformasjon (PIMS).

NVIDIA Tesla V100 har funksjoner som PCIe 32 GB/s, 16 GB HBM2 kapasitet, 900 GB/s båndbredde, dobbel presisjon-7 teraFLOPs, single precision-14 teraFLOPs og dyp læring-112 teraFLOPs.

Lambda GPU

Med Lambda GPU Cloud kan du trene dyp læring, ML og AI-modeller, og skalere fra én maskin til det totale antall virtuelle maskiner med noen få klikk. Få forhåndsinstallerte rammeverk og den nyeste versjonen av lambda-stakken, som inkluderer CUDA-drivere og rammeverk for dyp læring.

Få tilgang til det dedikerte Jupyter Notebook-utviklingsmiljøet for hver maskin, raskt fra dashbordet. Bruk SSH direkte med en av SSH-nøklene, eller koble til via nettterminalen i skydashbordet for direkte tilgang.

Hver instans støtter maksimalt 10 Gbps med inter-node-båndbredde, noe som muliggjør spredt trening med rammeverk som Horovod. Du kan også spare tid på modelloptimalisering ved å skalere til antall GPUer på enkelt- eller flere instanser.

Med Lambda GPU Cloud kan du spare 50 % på databehandling og redusere de totale kostnadene i skyen. Du er heller ikke bundet av flerårige avtaler. Bruk en enkelt RTX 6000 GPU med seks VCPUer, 46 GiB RAM og 658 GiB midlertidig lagring for bare $1,25/time. Velg blant mange instanser for å få et pristilbud for din bruk.

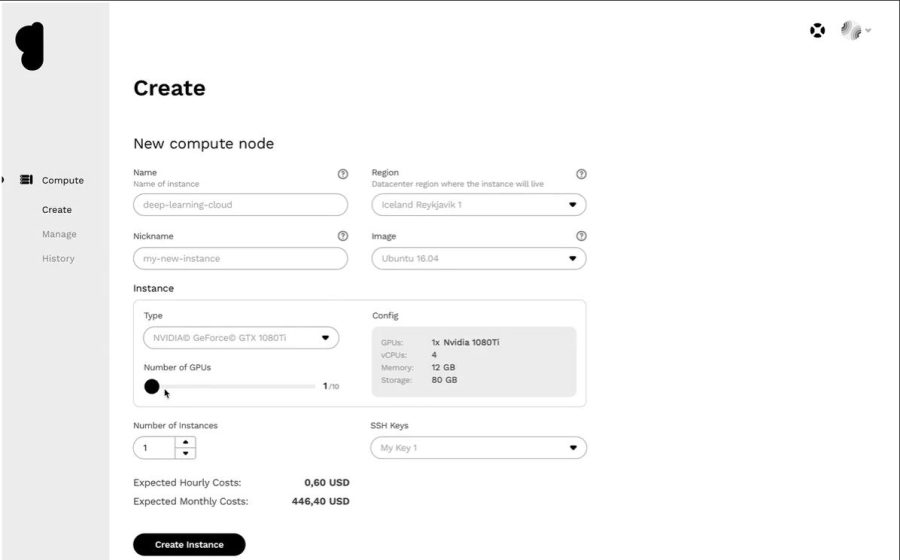

Genesis Cloud

Få en effektiv sky-GPU-plattform til en rimelig pris fra Genesis Cloud. De samarbeider med mange effektive datasentre over hele verden for å tilby et bredt spekter av applikasjoner.

Tjenestene er sikre, skalerbare, robuste og automatiserte. Genesis Cloud gir ubegrenset GPU-beregningskraft for visuelle effekter, maskinlæring, transkoding, lagring, Big Data-analyse og mer.

Genesis Cloud tilbyr mange funksjoner GRATIS, som øyeblikksbilder for å lagre arbeidet ditt, sikkerhetsgrupper for nettverkstrafikk, lagringsvolumer for store datasett, FastAI, PyTorch, forhåndskonfigurerte bilder og et offentlig API for TensorFlow.

Plattformen har NVIDIA og AMD GPUer av forskjellige typer. Bruk GPU-databehandling for å trene nevrale nettverk eller generere animasjonsfilmer. Datasentrene drives med 100 % fornybar energi fra geotermiske kilder, for å redusere karbonutslipp.

Prisene er 85 % lavere enn hos andre leverandører, med betaling per minutt. Du kan også spare mer med langsiktige og ugyldige rabatter.

Konklusjon

Sky-GPUer er utviklet for å tilby høy ytelse, hastighet, skalering, plassbesparelse og bekvemmelighet. Vurder å velge en sky-GPU-plattform for å akselerere dyp læringsmodeller og håndtere AI-arbeidsbelastninger.