Er du på utkikk etter metoder for å forsterke din SEO-rangering, synlighet og konverteringer? Da trenger du et webcrawlerverktøy. En webcrawler er et dataprogram som systematisk utforsker internett. Teknologier som nett-edderkopper, programvare for datautvinning fra nettsteder, og nettstedsskrapere er eksempler på webcrawling-metoder. Den er også kjent som en edderkopprobot eller en spider. I dag skal vi se på noen gratis verktøy for nettgjennomgang som er tilgjengelige for nedlasting.

De 25 beste gratis verktøyene for nettgjennomgang

Webcrawlerverktøy gir et stort spekter av informasjon for datautvinning og -analyse. Hovedformålet er å indeksere nettsider på internett. De kan avdekke ødelagte lenker, duplisert innhold og manglende sidetitler, og identifisere potensielle SEO-problemer. Dataskraping fra nettet kan være svært nyttig for virksomheten din på mange måter.

- Flere webcrawler-applikasjoner kan gjennomsøke data fra en hvilken som helst nettadresse.

- Disse programmene hjelper deg med å optimalisere nettstedets struktur, slik at søkemotorer kan forstå det og forbedre rangeringene dine.

I vår liste over de beste verktøyene har vi samlet en oversikt over gratis nedlastbare verktøy for robotsøk, samt deres funksjoner og kostnader for å hjelpe deg med å velge. Listen inkluderer også betalbare alternativer.

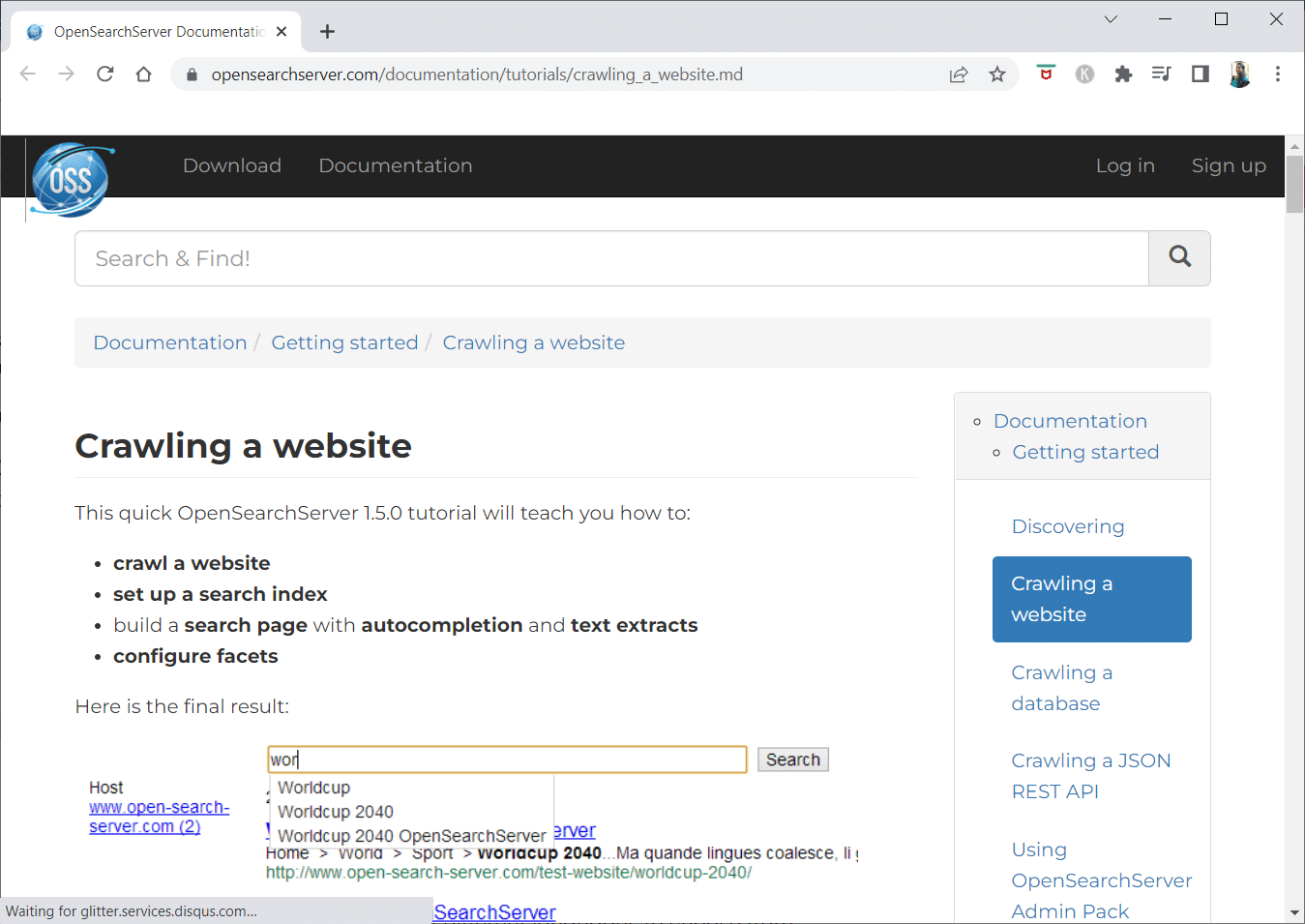

1. Open Search Server

OpenSearchServer er en gratis webcrawler med en av de beste vurderingene på nettet. Det er et utmerket alternativ blant tilgjengelige løsninger.

- Det er en fullt integrert løsning.

- Open Search Server er en gratis og åpen kildekode-webcrawler og søkemotor.

- Det er en samlet og kostnadseffektiv løsning.

- Det leveres med et omfattende sett med søkefunksjoner og muligheten til å skape din egen indekseringsstrategi.

- Crawlere kan indeksere praktisk talt hva som helst.

- Du kan velge mellom fulltekst-, boolske- og fonetiske søk.

- Det finnes 17 forskjellige språk å velge mellom.

- Automatiske klassifiseringer utføres.

- Du kan skape en tidsplan for gjentatte oppgaver.

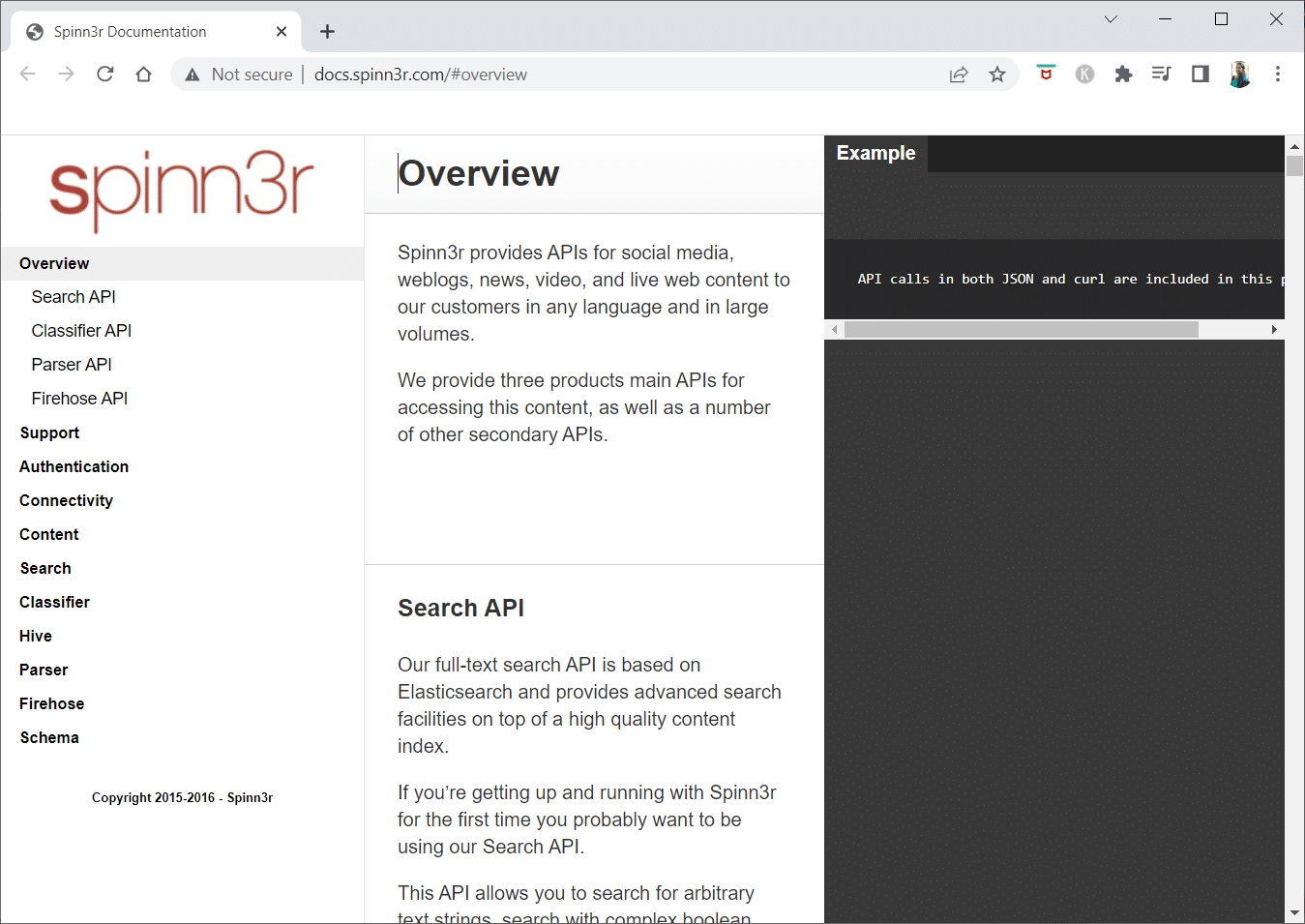

2. Spinn3r

Spinn3r webcrawler-programmet gjør det mulig å hente ut innhold fra blogger, nyhetssider, sosiale medieplattformer, RSS-feeder og ATOM-feeder.

- Det leveres med en lynrask API som tar seg av 95 % av indekseringsarbeidet.

- Avansert spambeskyttelse er inkludert i dette nettsøkeprogrammet, som fjerner spam og uønsket språkbruk, og øker datasikkerheten.

- Nett-skraperen leter kontinuerlig etter oppdateringer på nettet fra en rekke kilder for å gi deg sanntidsinnhold.

- Det indekserer innhold på samme måte som Google, og de hentede dataene lagres som JSON-filer.

- Parser API lar deg analysere og administrere informasjon for alle nettadresser raskt.

- Firehose API er utviklet for massetilgang til enorme datamengder.

- Enkle HTTP-overskrifter brukes for å autentisere alle Spinn3rs API-er.

- Dette er et gratis webcrawler-verktøy for nedlasting.

- Classifier API lar utviklere overføre tekst (eller URL-er) som skal merkes av vår maskinlæringsteknologi.

3. Import.io

Import.io lar deg skrape millioner av nettsider på få minutter, og konstruere 1000+ API-er tilpasset dine behov uten å skrive en eneste kodelinje.

- Det kan nå betjenes programmatisk, og data kan hentes automatisk.

- Hent data fra mange sider med et enkelt klikk.

- Det kan automatisk gjenkjenne paginerte lister, eller du kan klikke deg videre til neste side.

- Du kan integrere data i appen din eller på nettstedet ditt med bare noen få klikk.

- Lag alle nettadressene du trenger på et par sekunder ved hjelp av mønstre som sidetall og kategorinavn.

- Import.io gjør det enkelt å demonstrere hvordan du henter data fra en side. Velg bare en kolonne fra datasettet og pek på et element på siden som fanger oppmerksomheten din.

- Du kan be om et tilbud på deres nettside.

- Lenker på listesider fører til detaljsider med tilleggsinformasjon.

- Du kan bruke Import.io for å hente all data fra detaljsidene samtidig.

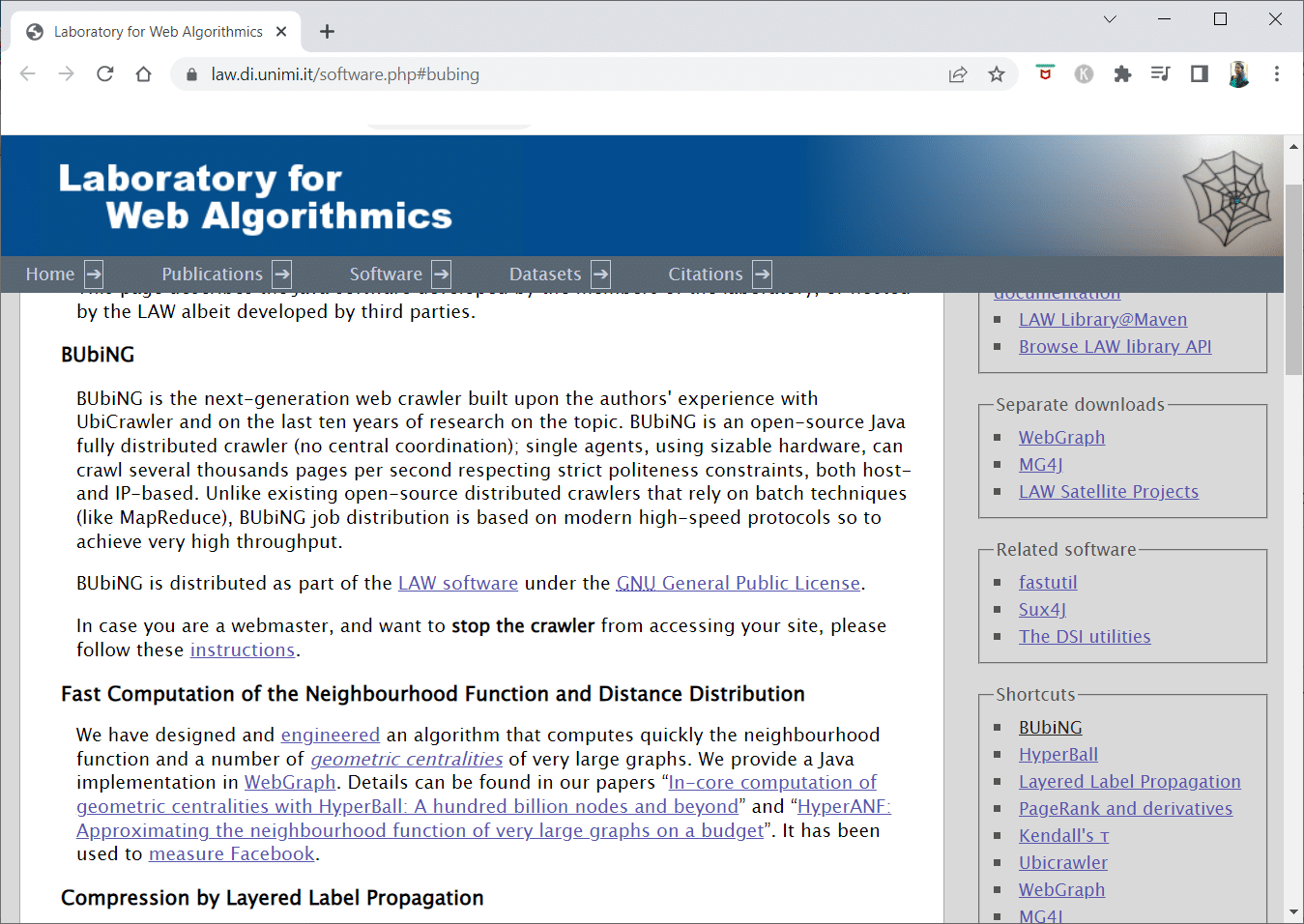

4. BUBING

BUbiNG, et neste-generasjons webcrawler-verktøy, er resultatet av forfatternes erfaring med UbiCrawler og ti års forskning på området.

- Tusenvis av sider per sekund kan gjennomsøkes av en enkelt agent, samtidig som strenge regler for god oppførsel følges, både verts- og IP-basert.

- Jobbdistribusjonen er basert på moderne høyhastighetsprotokoller for å levere svært høy gjennomstrømning, i motsetning til tidligere distribuerte robotsøkeprogrammer med åpen kildekode som er avhengig av batch-teknikker.

- Den bruker et fingeravtrykk for en renset side for å avdekke nesten-duplikater.

- BUbiNG er en fullt distribuert åpen kildekode Java-crawler.

- Den har mange parallelle prosesser.

- Det er mange som bruker dette produktet.

- Det er raskt.

- Det muliggjør nettgjennomgang i stor skala.

5. GNU Wget

GNU Wget er et gratis webcrawler-verktøy som er tilgjengelig for gratis nedlasting, og det er et åpen kildekode-program skrevet i C som lar deg hente filer over HTTP, HTTPS, FTP og FTPS.

- En av de mest distinkte egenskapene ved denne applikasjonen er muligheten til å lage NLS-baserte meldingsfiler på ulike språk.

- Du kan gjenoppta nedlastinger som har blitt avbrutt ved hjelp av REST og RANGE.

- Den kan også transformere absolutte lenker i nedlastede dokumenter til relative lenker, om nødvendig.

- Bruk jokertegn rekursivt i filnavn og speilkataloger.

- Meldingsfiler basert på NLS for en rekke språk.

- Under speiling blir lokale fil-tidsstempler evaluert for å avgjøre om dokumenter må lastes ned på nytt.

6. Webhose.io

Webhose.io er en imponerende webcrawler-applikasjon som lar deg skanne data og trekke ut nøkkelord på flere språk ved å bruke ulike filtre som dekker et bredt spekter av kilder.

- Arkivet lar også brukere se tidligere data.

- Webhose.ios gjennomsøkningsdata er tilgjengelig på opptil 80 språk.

- All personlig identifiserbar informasjon som har blitt kompromittert kan finnes på ett sted.

- Undersøk mørkenett og meldingsapplikasjoner for cybertrusler.

- XML-, JSON- og RSS-formater er også tilgjengelige for skrapte data.

- Du kan be om et tilbud på deres nettside.

- Brukere kan enkelt indeksere og søke i de strukturerte dataene på Webhose.io.

- Den kan overvåke og analysere medier på alle språk.

- Det er mulig å følge diskusjoner på oppslagstavler og forum.

- Den lar deg holde oversikt over viktige blogginnlegg fra hele nettet.

7. Norconex

Norconex er en utmerket ressurs for virksomheter som leter etter en åpen kildekode-søkerobotapp.

- Denne fullfunksjonelle samleren kan brukes eller integreres i programmet ditt.

- Den kan også fange opp et sides fremhevede bilde.

- Norconex gir deg muligheten til å gjennomsøke innholdet på ethvert nettsted.

- Det er mulig å bruke hvilket som helst operativsystem.

- Denne webcrawler-programvaren kan gjennomsøke millioner av sider på en enkelt server med gjennomsnittlig kapasitet.

- Den inkluderer også et sett med verktøy for å endre innhold og metadata.

- Hent metadata for dokumentene du jobber med.

- JavaScript-gjengitte sider støttes.

- Den muliggjør gjenkjenning av flere språk.

- Den muliggjør oversettelseshjelp.

- Hastigheten du gjennomsøker med kan justeres.

- Dokumenter som er endret eller fjernet blir identifisert.

- Dette er et helt gratis webcrawler-program.

8. Dexi.io

Dexi.io er en nettleserbasert webcrawler-app som lar deg skrape informasjon fra ethvert nettsted.

- Avtrekkere, crawlere og rør er de tre typene roboter du kan bruke for å utføre en skrapeoperasjon.

- Markedsutvikling er spådd ved hjelp av Delta-rapporter.

- Dine innsamlede data vil bli lagret i to uker på Dexi.ios servere før arkivering, eller du kan eksportere de utpakkede dataene som JSON- eller CSV-filer umiddelbart.

- Du kan be om et tilbud på deres nettside.

- Det tilbys profesjonelle tjenester, som kvalitetssikring og kontinuerlig vedlikehold.

- Det tilbyr kommersielle tjenester for å hjelpe deg med å tilfredsstille dine databehov i sanntid.

- Det er mulig å spore lager og priser for et ubegrenset antall SKUer/produkter.

- Den lar deg integrere data ved hjelp av live-dashbord og full produktanalyse.

- Den hjelper deg med å bearbeide og organisere nettbaserte produktdata, slik at de er klare for bruk.

9. Zyte

Zyte er et skybasert datautvinningsverktøy som hjelper titusenvis av utviklere med å finne viktig informasjon. Det er også en av de beste gratis webcrawler-appene.

- Brukere kan skrape nettsider ved å bruke åpen kildekode for visuell skraping uten å kjenne til koding.

- Crawlera, en kompleks proxy-rotator som brukes av Zyte, lar brukere enkelt gjennomsøke store eller bot-beskyttede nettsteder, samtidig som de unngår bot-mottiltak.

- Din nettinformasjon leveres tidsnok og konsistent. Som et resultat av dette kan du fokusere på å hente ut data i stedet for å administrere proxyer.

- På grunn av smarte nettleserfunksjoner og gjengivelse, kan anti-bots som retter seg mot nettleserlaget, nå enkelt administreres.

- Du kan be om et tilbud på deres nettside.

- Brukere kan gjennomsøke fra en rekke IP-adresser og regioner ved hjelp av et enkelt HTTP-API, noe som eliminerer behovet for proxy-vedlikehold.

- Det hjelper deg med å generere inntekter, samtidig som du sparer tid ved å skaffe deg den informasjonen du trenger.

- Det lar deg trekke ut nettdata i stor skala, samtidig som du sparer tid på koding og vedlikehold av edderkopper.

10. Apache Nutch

Apache Nutch er utvilsomt en av de beste åpen kildekode-søkerobot-appene.

- Den kan operere på en enkelt maskin, men fungerer best på en Hadoop-klynge.

- NTLM-protokollen brukes for autentisering.

- Den har et distribuert filsystem (via Hadoop).

- Det er et velkjent programvareprosjekt for datautvinning med åpen kildekode, som kan tilpasses og skaleres for datautvinning.

- Mange dataanalytikere, forskere, applikasjonsutviklere og netttekstutvinningsspesialister over hele verden bruker den.

- Det er en Java-basert løsning på tvers av plattformer.

- Som standard gjøres henting og analysering uavhengig av hverandre.

- Dataene er kartlagt ved hjelp av XPath og navneområder.

- Den inneholder en lenkegrafdatabase.

11. VisualScraper

VisualScraper er en annen fantastisk nett-skraper uten koding, for å trekke ut data fra Internett.

- Den har et enkelt pek-og-klikk-brukergrensesnitt.

- Den tilbyr også elektroniske skrapetjenester som datadistribusjon og bygging av programvare for datauttrekk.

- Den overvåker også dine konkurrenter.

- Brukere kan planlegge at prosjektene skal kjøre på et bestemt tidspunkt eller få sekvensen gjentatt hvert minutt, dag, uke, måned og år med Visual Scraper.

- Det er billigere og mer effektivt.

- Det kreves ingen koding.

- Dette er et helt gratis webcrawler-program.

- Sanntidsdata kan trekkes ut fra flere nettsider og lagres som CSV-, XML-, JSON- eller SQL-filer.

- Brukere kan bruke den til jevnlig å trekke ut nyheter, oppdateringer og foruminnlegg.

- Dataene er 100 % nøyaktige og tilpasset.

12. WebSphinx

WebSphinx er en fantastisk personlig gratis webcrawler-app som er enkel å sette opp og bruke.

- Den er designet for sofistikerte nettbrukere og Java-programmerere som ønsker å skanne en begrenset del av Internett automatisk.

- Denne datautvinningsløsningen online inkluderer et Java-klassebibliotek og et interaktivt programmeringsmiljø.

- Sider kan settes sammen for å skape et enkelt dokument som kan rulles gjennom eller skrives ut.

- Trekk ut all tekst som passer til et gitt mønster fra en sekvens av sider.

- Webcrawlere kan nå skrives i Java takket være denne pakken.

- Crawler Workbench og WebSPHINX klassebibliotek er begge inkludert i WebSphinx.

- Crawler Workbench er et grafisk brukergrensesnitt som lar deg tilpasse og styre en webcrawler.

- En graf kan opprettes fra en gruppe nettsider.

- Lagre sider på din lokale stasjon for lesing uten nett.

13. OutWit Hub

OutWit Hub-plattformen består av en kjerne med et omfattende bibliotek med datagjenkjennings- og utvinningsfunksjoner, hvor et utall forskjellige apper kan skapes, som hver bruker kjernens funksjoner.

- Denne webcrawler-applikasjonen kan skanne gjennom nettsteder og lagre dataene den finner på en tilgjengelig måte.

- Det er en multifunksjonell skrape-app med så mange funksjoner som mulig for å imøtekomme ulike krav.

- The Hub har eksistert lenge.

- Det har utviklet seg til en nyttig og mangfoldig plattform for både ikke-tekniske brukere og IT-fagfolk som vet hvordan de skal kode, men som forstår at PHP ikke alltid er det ideelle alternativet for å trekke ut data.

- OutWit Hub gir et enkelt grensesnitt for å skrape moderate eller enorme mengder data, avhengig av dine behov.

- Den lar deg skrape enhver nettside direkte fra nettleseren og konstruere automatiserte agenter som henter data og forbereder dem i henhold til dine behov.

- Du kan be om et tilbud på deres nettside.

14. Scrapy

Scrapy er et Python-nettverk for skraping for å bygge skalerbare webcrawlere.

- Det er et fullstendig rammeverk for webcrawling som håndterer alle egenskapene som gjør webcrawlere vanskelige å lage, for eksempel proxy-mellomvare og spørsmålsbehandling.

- Du kan skrive reglene for å trekke ut dataene, og deretter la Scrapy ta seg av resten.

- Det er enkelt å legge til nye funksjoner uten å endre kjernen, fordi det er utformet på den måten.

- Det er et Python-basert program som fungerer på Linux, Windows, Mac OS X og BSD-systemer.

- Dette er et helt gratis verktøy.

- Biblioteket gir programmerere en ferdig struktur for å tilpasse en webcrawler og trekke ut data fra nettet i stor skala.

15. Mozenda

Mozenda er også en av de beste gratis webcrawler-appene. Det er et forretningsorientert skybasert selvbetjent program for nettskraping. Mozenda har skrapet over 7 milliarder sider og har bedriftskunder over hele verden.

- Mozendas nettskrapingsteknologi eliminerer behovet for skript og ansettelse av ingeniører.

- Det øker hastigheten på datainnsamlingen med fem ganger.

- Du kan skrape tekst, filer, bilder og PDF-informasjon fra nettsteder med Mozendas pek-og-klikk-funksjon.

- Ved å organisere datafiler kan du forberede dem for publisering.

- Du kan eksportere direkte til TSV, CSV, XML, XLSX eller JSON ved å bruke Mozedas API.

- Du kan bruke Mozendas sofistikerte Data Wrangling for å organisere informasjonen din, slik at du kan ta viktige avgjørelser.

- Du kan bruke en av Mozendas partneres plattformer for å integrere data eller etablere tilpassede dataintegrasjoner i noen få plattformer.

16. Cyotek Webcopy

Cyotek Webcopy er et gratis webcrawler-verktøy som lar deg laste ned et nettsteds innhold til din lokale enhet automatisk.

- Innholdet på den valgte nettsiden vil bli skannet og lastet ned.

- Du kan velge hvilke deler av et nettsted som skal klones, og hvordan du bruker den komplekse strukturen.

- Den nye lokale ruten vil omdirigere lenker til nettstedsressurser som stilark, bilder og andre sider.

- Den vil analysere et nettsteds HTML-oppmerking og prøve å finne relaterte ressurser, som andre nettsteder, bilder, videoer, filnedlastinger osv.

- Den kan gjennomsøke et nettsted og laste ned det den finner, for å lage en akseptabel kopi av originalen.

17. Common Crawl

Common Crawl var ment for alle som er interessert i å utforske og analysere data for å få nyttig innsikt.

- Det er en 501(c)(3) ideell organisasjon som er avhengig av donasjoner for å drive sin virksomhet på en forsvarlig måte.

- Alle som ønsker å bruke Common Crawl kan gjøre det uten å bruke penger eller skape problemer.

- Common Crawl er et korpus som kan brukes til undervisning, forskning og analyse.

- Du bør lese artiklene hvis du ikke har noen tekniske ferdigheter for å lære om de bemerkelsesverdige oppdagelsene andre har gjort ved å bruke Common Crawl-data.

- Lærere kan bruke disse verktøyene til å undervise i dataanalyse.

18. Semrush

Semrush er en web-søkeapp som undersøker sidene og strukturen på nettstedet ditt for tekniske SEO-problemer. Ved å fikse disse problemene kan du forbedre søkeresultatene.

- Den har verktøy for SEO, markedsundersøkelser, markedsføring i sosiale medier og annonsering.

- Den har et brukervennlig grensesnitt.

- Metadata, HTTP/HTTPS, direktiver, statuskoder, duplisert innhold, sideresponstid, interne lenker, bildestørrelser, strukturerte data og andre elementer blir undersøkt.

- Den lar deg revidere nettstedet ditt raskt og enkelt.

- Det hjelper til med analyse av loggfiler.

- Dette programmet gir et dashbord som lar deg enkelt se nettstedsproblemer.

19. Sitechecker.pro

Sitechecker.pro er nok en av de beste gratis webcrawler-appene. Det er en SEO-sjekker for nettsteder som hjelper deg med å forbedre dine SEO-rangeringer.

- Du kan enkelt visualisere strukturen til en nettside.

- Den lager en SEO-revisjonsrapport på siden, som kunder kan motta via e-post.

- Dette webcrawler-verktøyet kan se på nettstedets interne og eksterne lenker.

- Det hjelper deg med å bestemme hastigheten på nettstedet ditt.

- Du kan også bruke Sitechecker.pro for å se etter indekseringsproblemer på landingssider.

- Det hjelper deg med å forsvare deg mot hackerangrep.

20. Webharvy

Webharvy er et verktøy for nettskraping med et enkelt pek-og-klikk-grensesnitt. Det er designet for de som ikke kan kode.

- Kostnaden for en lisens starter på $139.

- Du bruker WebHarvys innebygde nettleser til å laste nettsider og velge dataene som skal skrapes, ved hjelp av museklikk.

- Den kan automatisk skrape tekst, bilder, URL-er og e-poster fra nettsteder, og lagre dem i forskjellige formater.

- Proxy-servere eller en VPN kan brukes for å få tilgang til mål-nettsteder.

- Dataskraping krever ikke opprettelse av programmering eller apper.

- Du kan skrape anonymt og hindre at programvare for nettskraping blir forbudt av webservere ved å bruke proxy-servere eller VPN-er for å få tilgang til mål-nettsteder.

- WebHarvy identifiserer automatisk datamønstre på nettsteder.

- Hvis du trenger å skrape en liste over objekter fra en nettside, trenger du ikke å gjøre noe annet.

21. NetSpeak Spider

NetSpeak Spider er en stasjonær webcrawler-app for daglige SEO-revisjoner, raskt identifisering av problemer, utføring av systematiske analyser og skraping av nettsider.

- Denne webcrawling-applikasjonen utmerker seg ved å evaluere store nettsider samtidig som den minimerer bruken av RAM.

- CSV-filer kan enkelt importeres og eksporteres fra nettgjennomgangsdata.

- Med bare noen få klikk kan du identifisere disse og hundrevis av andre alvorlige SEO-problemer for nettsteder.

- Verktøyet vil hjelpe deg med å vurdere et nettsteds optimalisering på siden, inkludert statuskoden, instrukser for gjennomsøking og