For de som er nye innen programmering, kan prosessen med å utvikle en nettskraper virke overveldende. Heldigvis finnes det skreddersydd programvare for nettskraping som er tilgjengelig for både de med og uten kodeerfaring. Denne programvaren er spesielt designet for å hente ut relevante data fra nettsider. Slike verktøy er nyttige for alle som trenger å samle inn data fra internett på en systematisk måte. Informasjonen lagres enten i en lokal fil på datamaskinen eller i en database. Dette er en metode for automatisk innsamling av data fra nettet. Vi presenterer her en liste over 31 av de beste gratis verktøyene for nettskraping.

De 31 beste verktøyene for nettskraping

Nedenfor følger en nøye utvalgt liste over de mest effektive verktøyene for nettskraping. Denne oversikten inkluderer både kommersielle alternativer og verktøy med åpen kildekode, samt lenker til de respektive nettsidene.

1. Outwit

Outwit er et praktisk Firefox-tillegg som enkelt kan installeres fra Firefox sin tilleggsbutikk.

- Dette verktøyet gjør det enkelt å hente ut kontaktinformasjon fra nettet og e-postadresser.

- Du kan velge mellom tre ulike versjoner av produktet, avhengig av dine behov.

- Pro

- Ekspert

- Enterprise

- Med Outwit Hub er det ikke nødvendig med programmeringsferdigheter for å hente nøyaktig data fra nettsider.

- Du kan starte skraping av et stort antall nettsider med et enkelt klikk på utforsk-knappen.

2. ParseHub

ParseHub er et annet utmerket, gratis verktøy for nettskraping.

- Før du laster ned data, kan du rydde opp i tekst og HTML.

- Du kan enkelt velge dataene du ønsker å hente ut ved hjelp av en sofistikert nettskraper.

- Dette er et av de beste verktøyene for dataskraping, da det lar deg lagre utskrapte data i ulike formater for videre analyse.

- Det tilbyr et brukervennlig grafisk grensesnitt.

- Verktøyet lar deg automatisk hente og lagre data på servere.

3. Apify

Apify er enda et førsteklasses verktøy for nettskraping og automatisering, som gjør det mulig å lage et API for alle typer nettsider. Det inkluderer integrerte proxy-servere for både private hjemmenettverk og datasentre, noe som gjør datautvinning mer effektiv.

- Apify håndterer infrastruktur og fakturering, noe som gir utviklere muligheten til å tjene penger passivt ved å lage verktøy for andre.

- Integrasjoner inkluderer Zapier, Integromat, Keboola og Airbyte.

- Apify Store tilbyr ferdige løsninger for populære plattformer som Instagram, Facebook, Twitter og Google Maps.

- Strukturerte formater som JSON, XML, CSV, HTML og Excel kan lastes ned.

- Apify Proxy tilbyr funksjoner som HTTPS, geolokalisering, smart IP-rotasjon og proxy-servere for Google SERP.

- En gratis 30-dagers prøveperiode er tilgjengelig med en plattformkreditt på 5 USD.

4. Scrapestack

Scrapestack benyttes av over 2000 bedrifter, som stoler på dette unike API-et levert av apilayer. Dette er et av de beste gratis verktøyene for nettskraping.

- Det bruker en global pool med 35 millioner IP-adresser fra datasentre.

- Det tillater utførelse av mange API-forespørsler samtidig.

- Både CAPTCHA-dekryptering og gjengivelse av JavaScript støttes.

- Det finnes både gratis og betalte alternativer.

- Scrapestack er et REST API for nettskraping som fungerer i sanntid.

- Med Scrapestack API kan du skrape nettsider på millisekunder ved hjelp av millioner av proxy-IP-er, nettlesere og CAPTCHA-løsninger.

- Forespørsler om nettskraping kan sendes fra over 100 ulike steder verden over.

5. FMiner

FMiner er et populært program for nettskraping, datautvinning, skjermskraping, makro og webautomatisering, tilgjengelig for Windows og Mac OS.

- Data kan samles inn fra dynamiske Web 2.0-nettsider som kan være vanskelig å analysere.

- Du kan opprette et datautvinningsprosjekt med den brukervennlige visuelle editoren.

- Verktøyet bruker en kombinasjon av lenkestrukturer, rullegardinmenyer og URL-mønstertilpasning for å navigere gjennom nettsider.

- Du kan benytte tredjeparts tjenester for automatisk dekryptering av CAPTCHA eller legge inn manuell input for å håndtere CAPTCHA-beskyttelse på nettsteder.

6. Sequentum

Sequentum er et robust verktøy for stordata, designet for å hente pålitelig data fra nettet. Dette er også et av de beste gratis verktøyene for nettskraping.

- Sammenlignet med andre løsninger, går uthenting av data fra nettet raskere.

- Du kan bytte mellom flere plattformer med denne funksjonen.

- Det er en av de mest kraftfulle nettskraperne for å utvikle virksomheten din. Det tilbyr enkle funksjoner, inkludert en visuell pek-og-klikk-editor.

- Det dedikerte web-API-et hjelper deg å utvikle webapplikasjoner ved å hente data direkte fra nettsiden din.

7. Agenty

Agenty er et program for dataskraping, tekstutvinning og OCR som benytter Robotic Process Automation.

- Med dette programmet kan du gjenbruke behandlet data til analyseformål.

- Du kan bygge en agent med noen få museklikk.

- Du vil motta et e-postvarsel når oppgaven er fullført.

- Programmet lar deg koble til Dropbox og bruke sikker FTP.

- Alle aktivitetslogger er tilgjengelige for gjennomsyn.

- Det hjelper deg med å forbedre din virksomhets suksess.

- Du kan enkelt implementere forretningsregler og tilpasset logikk.

8. Import.io

Import.io er en applikasjon for nettskraping som hjelper deg å skape egne datasett ved å importere data fra en bestemt nettside og eksportere dem til CSV. Dette er også et av de beste verktøyene for nettskraping. Her er noen av funksjonene:

- Nettskjemaer og pålogginger er enkle å bruke.

- Det er en av de beste løsningene for dataskraping med API-er og webhooks for integrering av data i applikasjoner.

- Du kan få innsikt gjennom rapporter, diagrammer og visualiseringer.

- Datautvinning kan planlegges i forkant.

- Import.io sky lar deg lagre og få tilgang til data.

- Interaksjon med nettet og arbeidsflyter kan automatiseres.

9. Webz.io

Webz.io lar deg gjennomgå hundrevis av nettsteder og få umiddelbar tilgang til strukturert sanntidsdata. Det er også et av de beste gratis verktøyene for nettskraping.

Du kan skaffe organiserte, maskinlesbare datasett i JSON- og XML-formater.

- Det gir deg tilgang til historiske data som strekker seg over ti år.

- Du får tilgang til en stor database med datastrømmer uten ekstra kostnader.

- Du kan benytte et avansert filter for å utføre detaljerte analyser og filtrere datasett.

10. Scrape Owl

Scrape Owl er en brukervennlig og rimelig plattform for nettskraping.

- Scrape Owls hovedmål er å skrape alle typer data, inkludert e-handel, stillingsannonser og eiendomsoppføringer.

- Før du henter ut data, kan du kjøre tilpasset JavaScript.

- Du kan benytte lokale servere for å omgå lokale restriksjoner og få tilgang til lokalt innhold.

- Tilbyr en pålitelig vente-funksjon.

- Full JavaScript-gjengivelse støttes.

- Denne applikasjonen kan brukes direkte i et Google-ark.

- En gratis prøveperiode på 1000 kreditter er tilgjengelig slik at du kan prøve tjenesten før du kjøper et medlemskap. Det er ikke nødvendig å oppgi kredittkortinformasjon.

11. Scrapingbee

Scrapingbee er et API for nettskraping som håndterer proxy-innstillinger og hodeløse nettlesere.

- Det kan kjøre JavaScript på sidene og rotere proxyer for hver forespørsel, slik at du kan lese HTML-kode uten å bli blokkert.

- Et annet API for å hente ut Google-søkeresultater er også tilgjengelig.

- JavaScript-gjengivelse støttes.

- Det har en funksjon for automatisk proxy-rotasjon.

- Denne applikasjonen kan brukes direkte i Google Sheets.

- Chrome-nettleseren kreves for å bruke programmet.

- Den er ideell for Amazon-skraping.

- Den lar deg skrape Google-resultater.

12. Bright Data

Bright Data er en ledende global plattform for data, som tilbyr en kostnadseffektiv løsning for å samle inn offentlige data fra nettet i stor skala, konvertere ustrukturert data til strukturert data, og gi en overlegen kundeopplevelse med full transparens og etterlevelse.

- Det er meget tilpasningsdyktig da det kommer med ferdige løsninger, og kan utvides og justeres.

- Bright Data sin neste generasjons Data Collector leverer en automatisert og tilpasset dataflyt på et enkelt dashbord, uavhengig av mengden data.

- Kundestøtte er tilgjengelig døgnet rundt, syv dager i uken.

- Datasett er skreddersydd for bedriftens behov, fra e-handelstrender og sosiale mediedata, til konkurrentanalyse og markedsundersøkelser.

- Du kan fokusere på kjernevirksomheten ved å automatisere tilgang til pålitelig data.

- Det er effektivt med kodefrie løsninger og lavt ressursforbruk.

- Det er pålitelig, med data av høy kvalitet, høy oppetid, raskere data og god kundeservice.

13. Scraper API

Du kan bruke Scraper API-verktøyet for å håndtere proxyer, nettlesere og CAPTCHA-utfordringer.

- Verktøyet gir uovertruffen hastighet og pålitelighet, og gjør det mulig å lage skalerbare nettskrapere.

- Du kan hente HTML-koden fra hvilken som helst nettside med et enkelt API-kall.

- Det er enkelt å sette opp; du trenger bare å sende en GET-forespørsel med API-nøkkel og URL til API-endepunktet.

- Det gjør gjengivelse av JavaScript enklere.

- Det lar deg tilpasse forespørselstypen og overskriftene for hver forespørsel.

- Roterende proxyer med geografisk plassering.

14. Dexi Intelligent

Dexi intelligent er en nettbasert skrapeapplikasjon som lar deg konvertere nettdata til kommersiell verdi.

- Dette verktøyet lar deg spare både penger og tid.

- Det har forbedret produktivitet, nøyaktighet og kvalitet.

- Det muliggjør rask og effektiv datautvinning.

- Det har et omfattende system for kunnskapsfangst.

15. Diffbot

Diffbot gir deg rask tilgang til en rekke viktige fakta fra internett.

- Med AI-ekstraktorer kan du hente nøyaktig strukturert data fra en hvilken som helst URL.

- Du blir ikke belastet for tidkrevende skraping av nettsider eller manuelle forespørsler.

- Mange datakilder kombineres for å skape et fullstendig og nøyaktig bilde av hvert objekt.

- Du kan hente ut strukturert data fra enhver URL med AI Extractors.

- Med Crawlbot kan du skalere opp utvinningen til titusenvis av domener.

- Knowledge Graph-funksjonen tilbyr nøyaktige, fullstendige og dyptgående data som BI trenger for å generere innsikt.

16. Datastreamer

Data Streamer er en teknologi som lar deg hente sosialt innhold fra hele internett.

- Det er en av de største nettskraperne som benytter naturlig språkbehandling for å hente viktig metadata.

- Kibana og Elasticsearch brukes for å gi integrert fulltekstsøk.

- Det er basert på algoritmer for informasjonssamling, fjerning av unødvendig kode og innholdsutvinning.

- Det er bygget på en feiltolerant infrastruktur for å sikre høy tilgjengelighet av informasjon.

17. Mozenda

Du kan hente ut tekst, bilder og PDF-materiale fra nettsider ved hjelp av Mozenda.

- Du kan benytte dine foretrukne BI-verktøy eller databaser for å samle inn og publisere data fra nettet.

- Det er et av de beste verktøyene for å organisere og formatere datafiler for publisering.

- Med et pek-og-klikk-grensesnitt kan du opprette nettskrapere på noen få minutter.

- Bruk funksjonene Job Sequencer og Request Blocking for å samle inn data fra nettet i sanntid.

- Kontohåndtering og kundeservice er blant de beste i bransjen.

18. Data Miner Chrome-utvidelse

Nettskraping og datafangst gjøres enklere med Data Miner nettleserplugin.

- Den kan gjennomgå flere sider, i tillegg til dynamisk datautvinning.

- Datavalg kan gjøres på en rekke måter.

- Den undersøker informasjonen som har blitt skrapet.

- Data som er skrapet kan lagres som en CSV-fil.

- Lokal lagring brukes for å lagre skrapet data.

- Chrome-tillegget Web Scraper henter data fra dynamiske nettsteder.

- Sitemaps kan importeres og eksporteres.

19. Scrapy

Scrapy er også et av de beste verktøyene for nettskraping. Det er et Python-basert åpen kildekode-rammeverk for å lage nettskrapere.

- Det gir deg alle nødvendige verktøy for raskt å trekke ut data fra nettsteder, analysere dem og lagre dem i den strukturen og formatet du ønsker.

- Dette er et viktig verktøy for større prosjekter, og gir stor fleksibilitet.

- Dataene kan eksporteres som JSON, CSV eller XML.

- Linux, Mac OS X og Windows støttes.

- Det er utviklet på toppen av Twisted asynkron nettverksteknologi.

- Scrapy er kjent for sin brukervennlighet, omfattende dokumentasjon og aktive fellesskap.

20. ScrapeHero Cloud

ScrapeHero har gjort sin kunnskap om nettgjennomgang til økonomiske og brukervennlige forhåndsbygde søkeroboter og APIer for å skrape data fra nettsider som Amazon, Google, Walmart og andre.

- ScrapeHero Cloud sine søkeroboter inkluderer automatisk roterende proxyer, og kan kjøre flere søkeroboter samtidig.

- Du trenger ikke laste ned eller lære å bruke programvare for dataskraping for å benytte ScrapeHero Cloud.

- Med ScrapeHero Cloud kan du skrape data umiddelbart og eksportere dem i JSON-, CSV- eller Excel-formater.

- Brukere av ScrapeHero Cloud sine gratis- og «lite»-planer mottar e-posthjelp, mens alle andre planer gir prioritert service.

- ScrapeHero Cloud sine søkeroboter kan også konfigureres for å møte spesifikke kundekrav.

- Det er en nettleserbasert nettskraper som fungerer med alle nettlesere.

- Du trenger ingen programmeringskunnskaper eller å utvikle en skraper. Det er like enkelt som å klikke, kopiere og lime inn.

21. Data Scraper

Data Scraper er et gratis nettbasert skrapeprogram som skraper data fra en enkelt nettside og lagrer dem som CSV- eller XSL-filer.

- Det er en nettleserutvidelse som konverterer data til et oversiktlig tabellformat.

- Installasjon av programtillegget krever bruk av Google Chrome-nettleseren.

- Du kan skrape 500 sider hver måned med gratisversjonen. Hvis du ønsker å skrape flere sider, må du oppgradere til en betalt plan.

22. Visual Web Ripper

Visual Web Ripper er et automatisk verktøy for dataskraping fra nettsider.

- Datastrukturer samles inn fra nettsider eller søkeresultater med dette verktøyet.

- Du kan eksportere data til CSV-, XML- og Excel-filer, og det har et brukervennlig grensesnitt.

- Det kan også hente data fra dynamiske nettsteder, som de som bruker AJAX.

- Du trenger bare å sette opp noen få maler, så håndterer nettskraperen resten.

- Visual Web Ripper tilbyr planleggingsalternativer og sender deg e-post hvis et prosjekt mislykkes.

23. Octoparse

Octoparse er en brukervennlig applikasjon for skraping av nettsider med et visuelt grensesnitt. Dette er også et av de beste gratis verktøyene for nettskraping. Her er noen av funksjonene:

- Pek-og-klikk-grensesnittet gjør det enkelt å velge informasjonen du ønsker å skrape fra et nettsted. Octoparse kan håndtere både statiske og dynamiske nettsider takket være AJAX, JavaScript, informasjonskapsler og andre funksjoner.

- Avanserte skytjenester er tilgjengelige for utvinning av store mengder data.

- Den skrapede informasjonen kan lagres som TXT-, CSV-, HTML- eller XLSX-filer.

- Gratisversjonen av Octoparse lar deg konstruere opptil 10 crawlere. Betalte medlemsplaner inkluderer funksjoner som et API og et stort antall anonyme IP-proxyer, som øker hastigheten på datautvinningen og gjør det mulig å laste ned store mengder data i sanntid.

24. Web Harvey

WebHarvey sin visuelle nettskraper har en innebygd nettleser for å skrape data fra nettsider. Dette er også et av de beste verktøyene for nettskraping. Her er noen av funksjonene:

- Den tilbyr et pek-og-klikk-grensesnitt som gjør det enkelt å velge elementer.

- Med denne skraperen trenger du ikke å skrive kode.

- CSV-, JSON- og XML-filer kan brukes for å lagre dataene.

- Det er også mulig å lagre det i en SQL-database. WebHarvey har en funksjon for kategoriskraping på flere nivåer, som kan skrape data fra listesider ved å følge hvert nivå av kategoritilkoblinger.

- Regulære uttrykk kan brukes for å gi deg ekstra frihet.

- Du kan sette opp proxy-servere for å holde IP-en din skjult mens du henter data fra nettsteder, slik at du kan bevare en viss grad av personvern.

25. PySpider

PySpider er et annet av de beste gratis verktøyene for nettskraping, og er en Python-basert webcrawler. Noen funksjoner i dette verktøyet er listet opp nedenfor.

- Det har en distribuert arkitektur og støtter Javascript-sider.

- Du kan ha mange søkeroboter med denne løsningen. PySpider kan lagre data på alle typer backend, inkludert MongoDB, MySQL, Redis og andre.

- Meldingskøer som RabbitMQ, Beanstalk og Redis er tilgjengelige.

- En av PySpider sine fordeler er det enkle brukergrensesnittet, som lar deg endre skript, overvåke pågående aktiviteter og undersøke resultater.

- Informasjonen kan lastes ned i JSON- og CSV-formater.

- PySpider er verdt å vurdere hvis du jobber med et nettstedbasert brukergrensesnitt.

- Det fungerer også med nettsteder som bruker mye AJAX.

26. Content Grabber

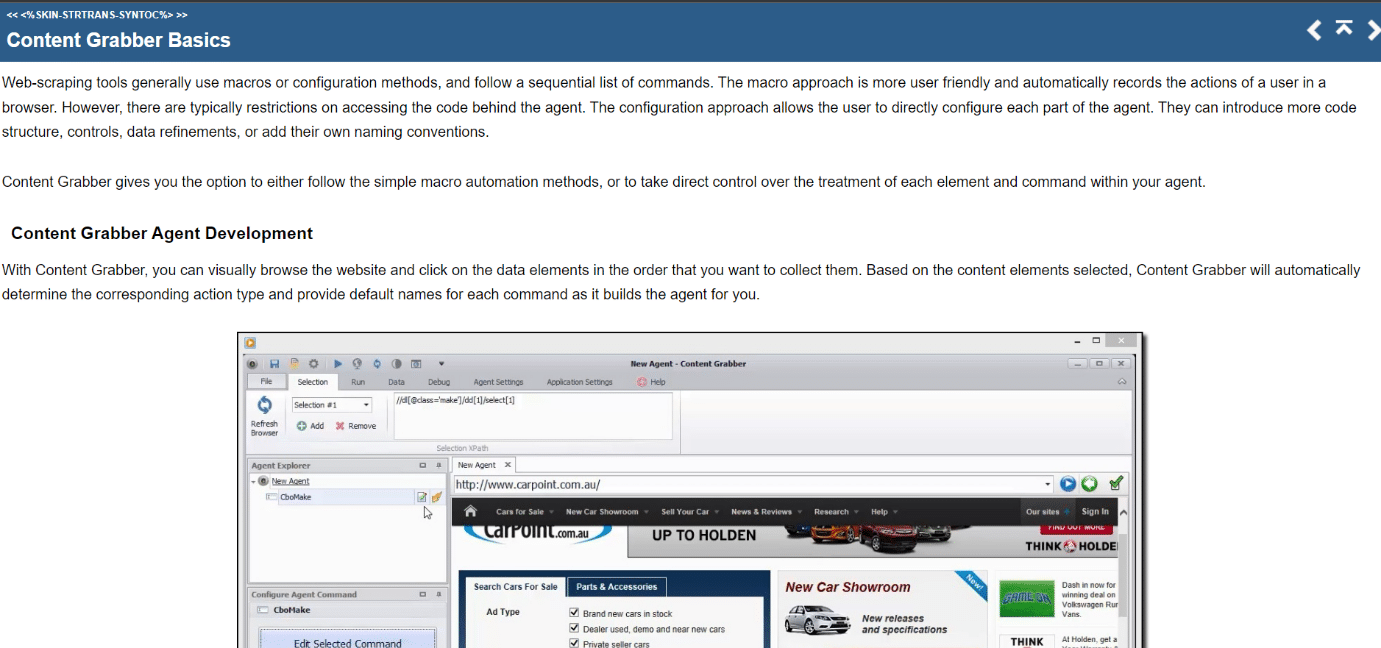

Content Grabber er et visuelt nettbasert skrapeverktøy med et brukervennlig pek-og-klikk-grensesnitt for å velge elementer. Her er noen av funksjonene til dette verktøyet:

- CSV, XLSX, JSON og PDF er formatene data kan eksporteres i. Det kreves mellomliggende programmeringskunnskaper for å bruke dette verktøyet.

- Paginering, ubegrensede rullesider og popup-vinduer er alle mulige med brukergrensesnittet.

- Det har også AJAX/Javascript-behandling, en captcha-løsning, støtte for regulære uttrykk og IP-rotasjon (ved hjelp av Nohodo).

27. Kimurai

Kimurai er et Ruby-rammeverk for nettskraping for å utvikle skrap