Betydningen av Datakrangel: En Dypdykk

I vår digitale tidsalder florerer det med data, både i terabyte og petabyte, og veksten er eksponentiell. Spørsmålet er: Hvordan kan vi utnytte denne enorme mengden informasjon og forvandle den til verdifull innsikt som kan forbedre tjenestetilgjengeligheten?

For bedrifter som satser på kunnskapsbaserte modeller, er pålitelige, ferske og lettfattelige data av avgjørende betydning.

Derfor benytter selskaper seg av ulike analysemetoder for å identifisere datakilder av høy kvalitet.

Men hvor starter denne prosessen? Svaret er: Med datakrangel.

La oss se nærmere på dette.

Hva innebærer datakrangel?

Datakrangel er prosessen med å rengjøre, strukturere og transformere rådata til formater som forenkler analysearbeidet. Dette innebærer ofte å håndtere uorganiserte og komplekse datasett som ikke er umiddelbart egnet for dataflytprosesser. Datakrangel omformer rådata til en mer raffinert tilstand, eller foredler data ytterligere til et produksjonsklart nivå.

Vanlige oppgaver innen datakrangel inkluderer:

- Sammenslåing av flere datasett til et enkelt, stort datasett for analyse.

- Identifisering og håndtering av manglende data eller hull i datasettet.

- Fjerning av uteliggere eller uregelmessigheter i datasettet.

- Standardisering av dataformater.

De enorme datamengdene som inngår i datakrangelprosesser, er ofte for store til å håndteres manuelt. Dette krever automatiserte metoder for datatilberedning for å sikre nøyaktighet og høy kvalitet på dataene.

Formålene med Datakrangel

Utover det overordnede målet om å forberede data for analyse, omfatter datakrangel også følgende:

- Å transformere rotete data til verdifulle og nye data som kan brukes som grunnlag for beslutningstaking i bedrifter.

- Standardisering av rådata til formater som er kompatible med Big Data-systemer.

- Redusere tidsbruken for dataanalytikere ved å presentere velordnede data.

- Sikre konsistens, fullstendighet, brukervennlighet og sikkerhet for alle datasett som brukes eller lagres i et datavarehus.

Vanlige Fremgangsmåter innen Datakrangel

Oppdagelse

Før dataingeniører begynner med dataklargjøring, er det viktig å forstå hvordan dataene er lagret, deres størrelse, hvilke oppføringer de inneholder, kodeformater og andre attributter som beskriver hvert datasett.

Strukturering

Denne prosessen involverer organisering av data for å skape lett tilgjengelige formater. Rå datasett kan trenge strukturering med tanke på hvordan kolonnene vises, antall rader og justering av andre dataattributter for å lette analysen.

Rensning

Strukturerte datasett må renses for feil og ujevnheter. Dette innebærer å fjerne duplikate oppføringer, slette tomme celler, fjerne avvikende data, standardisere inndata, gi nytt navn til forvirrende attributter og mer.

Berikelse

Etter strukturering og rensing er det nødvendig å vurdere datanytten og berike den med verdier fra andre datasett for å oppnå ønsket datakvalitet.

Validering

Valideringsprosessen omfatter iterative programmeringsaspekter som sikrer datakvalitet, konsistens, brukervennlighet og sikkerhet. Denne fasen bekrefter at alle transformasjonsoppgaver er fullført og markerer datasett som klare for analyse- og modelleringsfasene.

Presentasjon

Etter fullført behandling presenteres de bearbeidede datasettene for analyse i organisasjonen. Dokumentasjon av forberedelsestrinn og metadata som er generert under datakrangelprosessen, deles også i denne fasen.

Datakrangelverktøy

Det finnes en rekke verktøy som er utviklet for å forenkle og effektivisere datakrangelprosesser. La oss se på noen av de mest populære:

Talend

Talend tilbyr en enhetlig dataplattform som omfatter dataintegrasjon, applikasjonsintegrasjon og dataintegritet. Datakrangel i Talend gjøres via et nettleserbasert dra-og-slipp-verktøy som støtter forberedelse av batch-, bulk- og livedata, inkludert datapofilering, rensing og dokumentasjon.

Talend håndterer alle stadier i datalivssyklusen, med fokus på datatilgjengelighet, brukervennlighet, sikkerhet og integritet. Verktøyet integrerer data fra ulike kilder (databaser, skylagring og API-er) og gir mulighet for transformasjon og kartlegging med kvalitetskontroll.

Talend gjør dataintegrasjon mulig gjennom selvbetjeningsverktøy som lar utviklere hente data automatisk fra enhver kilde og kategorisere dem effektivt.

Viktige funksjoner i Talend

- Universell dataintegrasjon: Talend støtter datakrangel fra en rekke datakilder i skyen eller on-prem-miljøer.

- Fleksibilitet: Talend er uavhengig av leverandør eller plattform og lar deg kjøre datapipelines hvor som helst etter opprettelsen.

- Datakvalitet: Maskinlæringsfunksjoner for duplikatfjerning, validering og standardisering sikrer automatisk rensing av innlagte data.

- Støtte for applikasjons- og API-integrasjoner: Data kan deles gjennom brukervennlige API-er, som eksponerer datatilgang via avanserte datakartleggings- og transformasjonsverktøy.

R

R er et kraftig programmeringsspråk for utforskende dataanalyse for vitenskapelige og forretningsmessige formål. R er både et programmeringsspråk og et miljø for datakrangel, modellering og visualisering. R-miljøet tilbyr en rekke programvarepakker, mens R-språket integrerer en rekke statistiske, klyngings-, klassifiserings-, analyse- og grafiske teknikker for datamanipulering.

Viktige funksjoner i R

- Omfattende pakkeutvalg: Dataingeniører har tilgang til over 10 000 standardiserte pakker og utvidelser fra CRAN, som forenkler datakrangel og analyse.

- Ekstremt kraftfull: R kan utføre komplekse og enkle manipulasjoner på dataobjekter og datasett i løpet av sekunder, takket være distribuerte datapakker.

- Støtte på tvers av plattformer: R er plattformuavhengig og kompatibelt med en rekke operativsystemer og programmeringsspråk for komplekse oppgaver.

- Lett å lære: R har en relativt lav læringsterskel.

Trifacta

Trifacta er et interaktivt skymiljø for dataprofilering som brukes til maskinlærings- og analysemodeller. Verktøyet tar sikte på å skape lettfattelige data uavhengig av hvor uorganiserte eller komplekse datasettene er. Brukere kan fjerne duplikater og fylle tomme celler ved hjelp av duplikatfjerning og lineære transformasjoner.

Trifacta identifiserer uteliggere og ugyldige data. Ved hjelp av dra-og-slipp-funksjonalitet kan data rangeres og transformeres intelligent med maskinlæringsdrevne forslag for å akselerere dataklargjøringen.

Datakrangel i Trifacta gjøres via visuelle profiler som er brukervennlige for både tekniske og ikke-tekniske brukere. Med visualiserte og intelligente transformasjoner er Trifacta stolt av sitt brukerfokus.

Viktige funksjoner i Trifacta

- Sømløse skyintegrasjoner: Støtter forberedelsesarbeid i alle sky- eller hybridmiljøer.

- Flere data standardiseringsmetoder: Trifacta tilbyr ulike mekanismer for å identifisere datamønstre og standardisere utdata.

- Enkel arbeidsflyt: Trifacta organiserer dataklargjøring som flyt, der en flyt inneholder ett eller flere datasett pluss tilhørende «oppskrifter» (trinn for å transformere data).

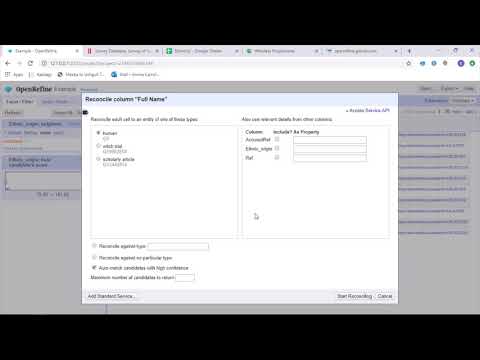

OpenRefine

OpenRefine er et modent, åpen kildekodeverktøy for å håndtere rotete data. Det utforsker datasett raskt og utfører komplekse celletransformasjoner for å skape ønskede dataformater. OpenRefine bruker filtre og partisjoner, i kombinasjon med regulære uttrykk for å bearbeide data. Med innebygd General Refine Expression Language, kan dataingeniører analysere data ved hjelp av fasetter, filtre og sorteringsteknikker før de utfører avanserte dataoperasjoner for enhetsekstraksjon.

OpenRefine lar brukere jobbe med data som prosjekter, der datasett fra ulike filer, nettadresser og databaser kan importeres, med muligheten til å kjøre verktøyet lokalt på brukerens maskin. Med uttrykk kan utviklere utvide dataopprydding og transformasjon, for eksempel splitting/sammenføying av celler med flere verdier, tilpasse fasetter og hente data til kolonner fra eksterne nettadresser.

Viktige funksjoner i OpenRefine

- Plattformverktøy: OpenRefine fungerer på Windows, Mac og Linux.

- Omfattende API-sett: Inkluderer OpenRefine API, datautvidelses-API, avstemmings-API og andre API-er.

Datameer

Datameer er et SaaS-basert datatransformasjonssystem som er designet for å forenkle datamanipulering og integrasjon gjennom programvareutviklingsprosesser. Datameer muliggjør ekstrahering, transformasjon og lasting av datasett til skylagrede datavarehus som Snowflake. Verktøyet støtter vanlige datasettformater som CSV og JSON, og lar ingeniører importere data i ulike formater for aggregering.

Datameer tilbyr kataloglignende datadokumentasjon, dyp dataprofilering og oppdagelse. Verktøyet har en dyptgående visuell datapofil som lar brukere spore ugyldige, manglende eller uteliggende data og den generelle formen på dataene. Datameer opererer i et skalerbart datavarehus, og transformerer data for meningsfull analyse med effektive datastabler og Excel-lignende funksjoner. Verktøyet presenterer et hybrid brukergrensesnitt (kode og kodefri) for brede dataanalyseteam.

Viktige funksjoner i Datameer

- Flere brukermiljøer: Datameer tilbyr miljøer for datatransformasjon med ulike ferdighetsnivåer – lav kode, kode og hybrid.

- Delte arbeidsområder: Datameer gir team muligheten til å gjenbruke og samarbeide om modeller.

- Omfattende datadokumentasjon: Datameer støtter systemgenerert og brukergenerert datadokumentasjon via metadata, beskrivelser, tagger og kommentarer i wiki-stil.

Avsluttende Ord

Dataanalyse er en kompleks prosess som krever at dataene er godt organisert for å trekke meningsfulle konklusjoner og prediksjoner. Datakrangelverktøy er avgjørende for å formatere store mengder rådata og bidra til avanserte analyser. Velg verktøyet som passer dine behov best og bli en mester i dataanalyse!

Du vil kanskje også like:

Beste CSV-verktøy for å konvertere, formatere og validere.