Utforskning av køsystemer: En viktig komponent for backend-utviklere

Er du på jakt etter et pålitelig køsystem, eller kanskje en forbedring av det du allerede bruker? Da har du kommet til rett sted. Denne artikkelen gir deg all informasjonen du trenger for å forstå og velge det rette køsystemet for dine behov.

Køsystemer er en av de mest undervurderte, men samtidig mest sentrale aspektene ved backend-utvikling. De er en avgjørende del av en effektiv og stabil infrastruktur.

En backend-utvikler går fra å være junior til å bli en erfaren mellomnivåutvikler når de mestrer integrasjonen av køer i systemet. Dette skyldes at køer ikke bare forbedrer brukeropplevelsen, men også reduserer kompleksiteten og styrker påliteligheten til et system.

Selv om enkle nettsteder med minimal trafikk kanskje ikke trenger et køsystem, er det nesten umulig for mer komplekse applikasjoner å operere effektivt uten dem. Store applikasjoner er rett og slett avhengige av køer for å kunne håndtere store datamengder og prosesser.

Før vi går videre, er det viktig å påpeke at hvis du allerede er komfortabel med køsystemer, kan de neste avsnittene virke repeterende. Du er velkommen til å hoppe rett til den delen som omhandler de forskjellige alternativene. De innledende avsnittene er ment for de som er ny i dette feltet eller bare har en vag forståelse av hvordan køer fungerer.

Hva er et køsystem?

La oss starte med det grunnleggende, og forstå hva en kø faktisk er.

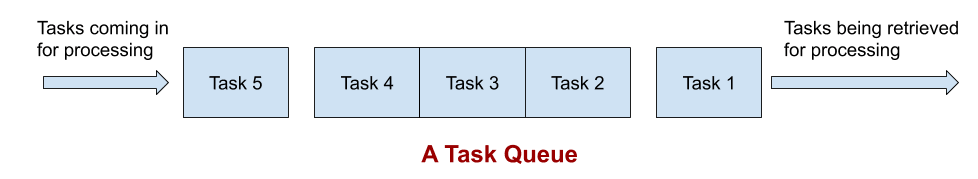

I datavitenskap er en kø en datastruktur som etterligner virkelige køer. Tenk deg en billettskranke, der du må vente i kø. De som er først i køen får sin billett først, mens de som kommer sist, må vente til slutt. Dette prinsippet, ofte referert til som «førstemann til mølla», er grunnlaget for køsystemer i programvare. Oppgaver lagres i køen og behandles en etter en i den rekkefølgen de ble mottatt.

Det er viktig å merke seg at selve køen ikke utfører noen behandling. Den fungerer kun som et midlertidig lager der oppgaver venter på å bli plukket opp og utført. Hvis dette høres abstrakt ut, ikke bekymre deg. Vi vil gi klare eksempler i de neste avsnittene. 🙂

Hvorfor trenger du køsystemer?

I hovedsak er behovet for køsystemer drevet av tre faktorer: bakgrunnsbehandling, parallell utførelse og feilhåndtering. La oss se på noen eksempler for å forstå dette bedre:

Bakgrunnsbehandling

Tenk deg en e-handelskampanje der tid er kritisk. Applikasjonen din sender bekreftelses-e-poster rett før betalingen er fullført, og kunden blir sendt til en takkeside. Hvis e-postserveren er nede, kan dette føre til at hele nettsiden bryter sammen, noe som resulterer i en dårlig brukeropplevelse og mange supporthenvendelser. I slike tilfeller er det bedre å delegere e-postoppgaven til en jobbkø og sende kunden direkte til takkesiden.

Parallell utførelse

Mange utviklere bruker cron-jobber for bakgrunnsbehandling, spesielt i mindre applikasjoner med lav trafikk. Dette fungerer fint inntil mengden data blir for stor. La oss si at du har en cron-jobb som genererer analyserapporter og sender dem til brukerne. Hvis systemet ditt kan håndtere 100 rapporter per minutt og trafikken øker, vil systemet begynne å henge etter.

Med et køsystem kan du unngå denne situasjonen ved å sette opp flere arbeidere. Hver arbeider kan hente en jobb fra køen (f.eks. 100 rapporter som skal genereres) og jobbe parallelt, noe som gjør hele prosessen mye raskere.

Gjenoppretting fra feil

Som webutviklere tenker vi sjelden på feil. Vi forventer at serverne og API-ene alltid vil være tilgjengelige. Men i realiteten er nettverksbrudd vanlig, og API-er kan gå ned. Tenk deg at du bruker et betalings-API i rapportgenereringen, og denne forbindelsen går ned i to minutter. Hva skjer med de 200 rapportene som mislyktes?

Køsystemer kan hjelpe i slike tilfeller. De tillater deg å håndtere feil på en ordentlig måte. Det er verdt å merke seg at bruk av køsystemer også introduserer kompleksitet og krever mer av utviklingsressursene. De krever også en læringskurve og kan ikke alltid kontrolleres med 100% presisjon. Allikevel, i mange tilfeller er køsystemer helt nødvendige for å bygge et robust og pålitelig system.

Med dette avklart, la oss se på noen av de mest populære køsystemene som er tilgjengelige for backend-utviklere i dag.

Redis

Redis er velkjent for sin rolle som et nøkkelverdilager, der datastrenger lagres, oppdateres og hentes uten å vite strukturen til dataene. Men i dag tilbyr Redis også effektive datastrukturer som lister, sorterte sett og et Pub-Sub-system, noe som gjør det attraktivt for køimplementeringer.

Fordelene med Redis:

- Helt i minne database, som gir raskere lese- og skriveoperasjoner.

- Svært effektiv, kan enkelt støtte over 100 000 lese/skrive operasjoner per sekund.

- Fleksibel utholdenhetsordning, hvor du kan velge mellom maksimal ytelse på bekostning av datatap ved feil, eller en mer konservativ tilnærming for å prioritere datakonsistens fremfor ytelse.

- Klynger støttes ut av boksen.

Det er viktig å vite at Redis mangler innebygde abstraksjoner for meldinger/køer/gjenoppretting. Derfor må du enten bruke en pakke eller bygge et eget lettvektssystem. Som et eksempel fungerer Redis som standard kø-backend for Laravel PHP-rammeverket.

Å lære Redis er enkelt og gir deg mange fordeler.

RabbitMQ

Det finnes noen subtile, men viktige forskjeller mellom Redis og RabbitMQ. RabbitMQ er mer spesialisert for meldingshåndtering, mens Redis fungerer mer som en database. RabbitMQ er designet for å være en mellommann mellom to systemer og tilbyr fasiliteter som meldingsruting, gjenoppretting og lastbalansering.

Oppgavekøer kan betraktes som et meldingssystem der planleggeren, arbeiderne og oppgavens «innsendere» deltar i meldingsutveksling.

Fordelene med RabbitMQ:

- Bedre abstraksjoner for meldingshåndtering, noe som reduserer utviklingsarbeidet.

- Mer robust mot strømbrudd enn Redis.

- Støtte for klynger og federasjon for distribuerte distribusjoner.

- Nyttige verktøy for administrasjon og overvåking.

- Støtte for de fleste ikke-trivielle programmeringsspråk.

- Enkel utrulling med verktøy som Docker, Chef og Puppet.

RabbitMQ er et godt valg når du trenger asynkron meldingsutveksling og ønsker å unngå kompleksiteten som andre køsystemer kan ha.

ActiveMQ

Hvis du er interessert i løsninger for store virksomheter eller bygger en stor applikasjon, er ActiveMQ verdt å vurdere. Den gir en rekke funksjoner og standarder som kan spare deg for tid og unødvendige feil.

ActiveMQ tilbyr følgende:

- Implementert i Java og følger JMS-standarden.

- Støtte for flere protokoller, som AMQP, MQTT, STOMP og OpenWire.

- Håndterer sikkerhet, ruting, meldingsutløp og analyser.

- Innebygd støtte for distribuerte meldingsmønstre.

Selv om ActiveMQ er implementert i Java, har den klienter for andre programmeringsspråk som Python, C/C++, Node og .Net. Det er også mulig å bygge egne lette klienter. Det er viktig å være oppmerksom på at ActiveMQ er en megler, og du må bruke en av de støttede backend-ene for å lagre meldingene. Vi har inkludert ActiveMQ her på grunn av dens språknøytralitet.

Amazon MQ

Amazon MQ er en administrert tjeneste som bygger på ActiveMQ. Hvis du ser fordelene med ActiveMQ men ikke ønsker å håndtere infrastrukturen selv, er Amazon MQ et utmerket valg. Den tilbyr de samme funksjonene som ActiveMQ, men som en managed service.

Fordelen med Amazon MQ er at du ikke trenger å bekymre deg for noe annet enn selve bruken. Det er spesielt nyttig for distribusjoner på AWS, hvor du kan dra nytte av andre tjenester og raskere dataoverføringer.

Amazon SQS

Amazon SQS er en fullstendig vertet og enkel køtjeneste fra AWS. SQS er ikke et meldingssystem, men en enkel backend for å motta og distribuere jobber i køer. Dette er en viktig forskjell.

Når er Amazon SQS det rette valget? Her er noen grunner:

- Du foretrekker å bruke AWS-tjenester.

- Du ønsker en vertet løsning med minimal risiko for feil.

- Du ønsker å unngå å bygge eller overvåke klynger.

- Du har allerede investert mye i AWS.

- Du ønsker et enkelt køsystem uten kompliserte funksjoner for meldingshåndtering.

Amazon SQS er et godt valg for de som trenger jobbkøer og ønsker å unngå å administrere infrastrukturen selv.

Beanstalkd

Beanstalkd er en kamptestet, rask og enkel backend for jobbkøer. Beanstalkd er kun et jobbkøsystem. Det har ingen avanserte datastrukturer eller prioriteringsmuligheter. Det fungerer etter «First In, First Out»-prinsippet.

- Det er et rent jobbkøsystem, uten meldingshåndtering.

- Ingen avanserte datastrukturer.

- Fungerer etter FIFO-prinsippet.

- Ingen muligheter for gruppering.

Beanstalkd er et raskt og enkelt køsystem for enklere prosjekter på en enkelt server. For mange er det mer stabilt enn Redis. Hvis du har hatt problemer med Redis og har enkle behov, kan Beanstalkd være verdt et forsøk.

Konklusjon

Hvis du har lest helt hit, er det sannsynlig at du er interessert i eller trenger et køsystem. Listen over alternativer i denne artikkelen vil være et godt utgangspunkt. Hvis du ser etter et mer spesifikt system for et bestemt språk eller rammeverk, bør du undersøke dette nærmere.

Det er viktig å huske at køer ikke er enkle og 100% pålitelige. De er komplekse og krever grundig planlegging og overvåking, siden feil kan oppstå ubemerket. Allikevel er køer helt nødvendige for å bygge moderne applikasjoner. De er et kraftig verktøy i utviklerens verktøykasse. Lykke til! 🙂