Hvor ofte benytter du deg av chatbots eller roboter basert på kunstig intelligens (KI) for å utføre arbeidsoppgaver eller få svar på spørsmål?

Hvis svaret ditt er «ofte!» eller «hele tiden!», kan det være grunn til bekymring 😟.

Uansett om du er en student som flittig bruker KI-roboter til å analysere studiene dine, eller en programmerer som prøver å generere kode ved hjelp av KI, er risikoen for unøyaktigheter i KI-generert data ganske høy. Dette skyldes primært inkonsistenser eller feilinformasjon i KI-ens treningsdata.

Selv om KI og maskinlæringsmodeller (ML) endrer verden ved å overta repeterende oppgaver og løse mange problemer gjennom automatisering, er det fortsatt arbeid som gjenstår når det gjelder å produsere nøyaktig data basert på gitte instruksjoner.

Hvis du bruker en del tid på å jobbe med innholdsgeneratorer og chatbots, vil du raskt innse at du mottar feilaktige, irrelevante eller direkte oppdiktede svar. Disse tilfellene kalles KI-hallusinasjoner eller konfabuleringer, og de viser seg å være et betydelig problem for organisasjoner og enkeltpersoner som er avhengige av generative KI-roboter.

Uavhengig av om du har erfart KI-hallusinasjoner eller ikke, og ønsker å lære mer, vil denne artikkelen utforske emnet grundig. Vi skal se på hva KI-hallusinasjoner betyr, hvorfor de oppstår, gi eksempler og se om det kan fikses.

La oss begynne!

Hva er en KI-hallusinasjon?

En KI-hallusinasjon oppstår når en KI-modell eller en stor språkmodell (LLM) genererer falsk, unøyaktig eller ulogisk informasjon. KI-modellen produserer et selvsikkert svar som ikke stemmer overens med treningsdataene og presenterer dataene som fakta, selv om de mangler logisk mening eller resonnement!

Og de sier at det å feile er menneskelig!😅

KI-verktøy og -modeller, som for eksempel ChatGPT, er vanligvis trent for å forutsi ord som best matcher det angitte søket. Selv om robotene ofte genererer faktiske og nøyaktige svar, fører denne algoritmen noen ganger til at de mangler evnen til å resonnere. Dette resulterer i at chatboter gir fra seg faktafeil og falske utsagn.

Med andre ord, KI-modeller «hallusinerer» noen ganger svar i et forsøk på å tilfredsstille deg (brukeren). De trenger å være mer objektive, spesifikke og velinformerte.

KI-hallusinasjoner kan variere fra mindre inkonsistenser til fullstendig falske eller fabrikkerte svar. Her er typene KI-hallusinasjoner du kan oppleve:

#1. Setningsmotsigelse: Dette oppstår når en LLM-modell genererer en setning som er i direkte motstrid med en tidligere påstand.

#2. Faktisk motsetning: Denne typen hallusinasjon forekommer når KI-modellen presenterer falsk eller fiktiv informasjon som fakta.

#3. Spørsmålsmotsigelse: Denne hallusinasjonstypen oppstår når svaret motsier spørsmålet som det er ment å svare på. For eksempel, hvis spørsmålet er «Skriv en invitasjon til vennene mine til bursdagsfesten min.», kan modellen generere et svar som «Gratulerer med dagen, mamma og pappa.»

#4. Tilfeldige eller irrelevante hallusinasjoner: Denne hallusinasjonen oppstår når modellen produserer et fullstendig irrelevant svar i forhold til det gitte spørsmålet. For eksempel, hvis spørsmålet er «Hva er spesielt med New York City?», kan du motta et svar som «New York er en av de mest overfylte byene i Amerika. Hunder er de mest lojale dyrene og en manns beste venn.»

Les også: Hvordan generativ KI endrer søkemotorer

Eksempler på KI-hallusinasjoner

KI-hallusinasjoner har noen av de mest oppsiktsvekkende eksemplene og hendelsene som du bør være oppmerksom på. Her er noen kjente eksempler på KI-hallusinasjoner:

- Googles chatbot, Bard, hevdet feilaktig at James Webb-romteleskopet hadde tatt de første bildene i verden av en eksoplanet, en planet som ikke tilhører vårt solsystem.

- Metas Galactica LLM-demo fra 2022, som var utviklet for studenter og vitenskapsfolk, ga brukerne unøyaktig informasjon og et falskt papir da de ble bedt om å utarbeide en rapport om å lage avatarer.

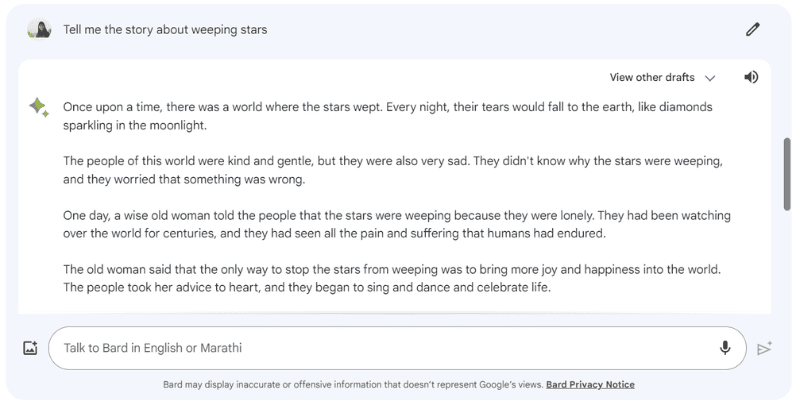

Her er et eksempel på hvordan Google Bard hallusinerte et svar da jeg ga den følgende oppfordring: «Fortell meg historien om gråtende stjerner», som egentlig ikke eksisterer.

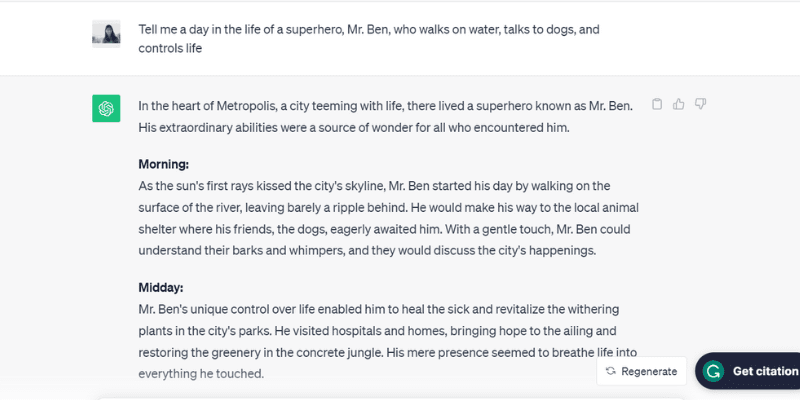

Her er et annet testet eksempel på hvordan ChatGPT (GPT-3.5) hallusinerer ved å snakke om en urealistisk person, Mr. Ben, da jeg ga den oppfordringen: «Fortell meg en dag i livet til superhelten Mr. Ben, som går på vannet, snakker med hunder og kontrollerer livet.»

ChatGPT fant opp hele dagen, fra morgen til kveld, for Mr. Ben, som faktisk ikke eksisterer, men spilte med på oppfordringen som ble gitt, noe som er en av årsakene bak KI-hallusinasjoner.

Snakk om å være altfor ivrig etter å behage!

Vel, hva er årsakene? La oss se på noen flere grunner som får KI til å hallusinere.

Hvorfor oppstår KI-hallusinasjoner?

Det finnes flere tekniske og underliggende årsaker til KI-hallusinasjoner. Her er noen av de mulige årsakene:

- Lav kvalitet, utilstrekkelig eller utdatert data: LLM-er og KI-modeller er sterkt avhengige av treningsdata. Derfor er de bare så gode som dataene de er trent på. Hvis KI-verktøyet har feil, inkonsistenser, skjevheter eller ineffektivitet i treningsdataene, eller hvis det rett og slett ikke forstår spørsmålet, vil det skape KI-hallusinasjoner ettersom verktøyet genererer data fra et begrenset datasett.

- Overfitting: Siden KI-modellen er trent på et begrenset datasett, kan den prøve å huske meldingene og de tilhørende dataene. Dette gjør at den ikke effektivt kan generere eller generalisere nye data, noe som fører til KI-hallusinasjoner.

- Inndatakontekst: KI-hallusinasjoner kan også oppstå på grunn av uklare, unøyaktige, inkonsekvente eller motstridende spørsmål. Selv om KI-modellens treningsdatasett ikke er tilgjengelig for brukerne, er inndataene de legger inn som en melding viktige. Derfor er det avgjørende å gi tydelige meldinger for å unngå KI-hallusinasjoner.

- Bruk av idiomer eller slanguttrykk: Hvis spørsmålet inneholder idiomer eller slang, er det en stor sjanse for KI-hallusinasjoner, spesielt hvis modellen ikke er trent for slike ord eller uttrykk.

- Motstridende angrep: Angripere legger noen ganger bevisst inn meldinger som er ment å forvirre KI-modeller, ødelegge treningsdataene deres og føre til KI-hallusinasjoner.

Negative konsekvenser av KI-hallusinasjoner

KI-hallusinasjoner skaper betydelige etiske bekymringer med store konsekvenser for både enkeltpersoner og organisasjoner. Her er de ulike årsakene som gjør KI-hallusinasjoner til et alvorlig problem:

- Spredning av feilinformasjon: KI-hallusinasjoner som skyldes feil meldinger eller inkonsekvens i treningsdataene, kan føre til massiv spredning av feilinformasjon som påvirker et bredt spekter av individer, organisasjoner og offentlige etater.

- Mistillit blant brukere: Når feilinformasjon som er hallusinert av KI sprer seg som ild i tørt gress på internett, og får det til å se autoritativt og menneskeskrevet ut, svekkes brukernes tillit. Dette gjør det vanskelig for brukere å stole på informasjonen på internett.

- Brukerskade: I tillegg til etiske bekymringer og villedende individer, kan KI-hallusinasjoner potensielt skade mennesker ved å spre feilinformasjon om alvorlige problemer og emner, som sykdommer, deres behandling eller enkle tips for å skille mellom en dødelig giftig og en sunn spiselig sopp. Selv mindre feilinformasjon eller unøyaktigheter kan sette et menneskeliv i fare.

Beste praksis for å oppdage og forebygge KI-hallusinasjoner

Med tanke på de ovennevnte negative konsekvensene av KI-hallusinasjoner, er det avgjørende å forebygge dem for enhver pris. Selv om selskapene som eier disse KI-modellene jobber hardt for å eliminere eller redusere KI-hallusinasjoner, er det viktig at vi som brukere også tar grep.

Basert på litt forskning, min erfaring og prøving og feiling, har jeg samlet noen strategier for å oppdage og forebygge KI-hallusinasjoner neste gang du bruker en chatbot eller samhandler med en stor språkmodell (LLM).

#1. Bruk representative og diversifiserte treningsdata

Som bruker er det viktig å bruke LLM-er med et mangfoldig treningsdatasett som representerer den virkelige verden. Dette reduserer sannsynligheten for at dataene blir partisk, unøyaktig eller oppdiktet.

Samtidig må bedriftseiere sørge for å oppdatere og utvide KI-modellens treningsdatasett regelmessig for å holde tritt med kulturelle, politiske og andre utviklende hendelser.

#2. Begrens resultatene eller svarene

Som bruker kan du begrense antallet potensielle svar et KI-verktøy kan generere, ved å gi det en spesifikk melding om hvilken type svar du ønsker.

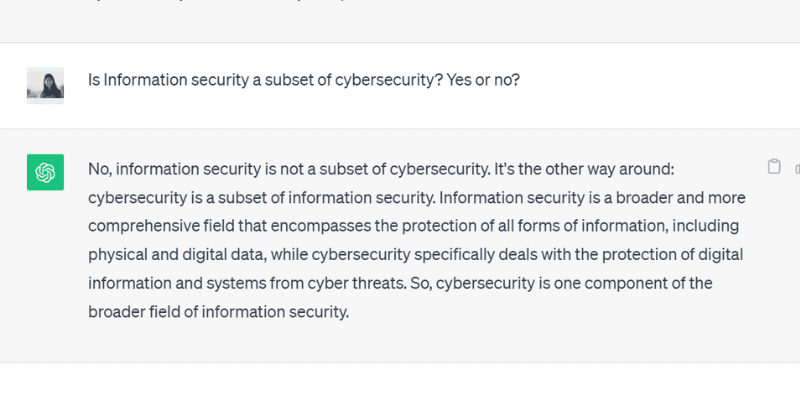

For eksempel kan du stille et spørsmål og be modellen om å svare enten ja eller nei. Du kan også gi flere valg i spørsmålet som verktøyet kan velge mellom, noe som begrenser muligheten for å avvike fra det faktiske svaret og hallusinere.

Da jeg stilte ChatGPT GPT 3.5 et spørsmål med et ja eller nei, ga den nøyaktig dette svaret:

#3. Utstyr modellen med relevant data

Du kan ikke forvente at et menneske skal gi en løsning på et bestemt problem eller spørsmål uten forkunnskaper eller en spesifikk kontekst. På samme måte er en KI-modell kun så god som treningsdatasettet du gir den.

Å utstyre treningsdataene til en KI-modell med relevant og bransjespesifikk data og informasjon, gir modellen ekstra kontekst og datapunkt. Denne tilleggskonteksten hjelper KI-modellen med å forbedre forståelsen sin, slik at den kan generere nøyaktige, fornuftige og kontekstuelle svar i stedet for hallusinerte svar.

#4. Lag datamaler for KI-modellen å følge

Å gi en datamal eller et eksempel på en spesifikk formel eller beregning i et forhåndsdefinert format kan i stor grad hjelpe KI-modellen med å generere nøyaktige svar i henhold til de foreskrevne retningslinjene.

Å bruke retningslinjer og datamaler reduserer sannsynligheten for hallusinasjoner og sikrer konsistens og nøyaktighet i de genererte svarene. Dermed kan det å gi en referansemodell i form av en tabell eller et eksempel veilede KI-modellen i beregningen og eliminere forekomsten av hallusinasjoner.

#5. Vær spesifikk med spørsmålet ditt ved å tildele modellen en bestemt rolle

Å tildele spesifikke roller til KI-modellen er en av de mest smarte og effektive måtene å forhindre hallusinasjoner på. Du kan for eksempel gi spørsmål som «Du er en erfaren og dyktig gitarist» eller «Du er en strålende matematiker», etterfulgt av ditt spesifikke spørsmål.

Å tildele roller veileder modellen til å gi det ønskede svaret i stedet for oppdiktede hallusinerte svar.

Og ikke bekymre deg. Du kan fortsatt ha det gøy med KI (selv om den hallusinerer). Sjekk ut hvordan du kan lage viral KI-spiralkunst selv!

#6. Test det ut med temperatur

Temperatur spiller en avgjørende rolle for å bestemme graden av hallusinasjoner eller kreative svar en KI-modell kan generere.

En lavere temperatur betyr vanligvis deterministiske eller forutsigbare resultater, mens en høyere temperatur betyr at KI-modellen er mer sannsynlig å generere tilfeldige svar og hallusinere.

Flere KI-selskaper tilbyr en «Temperatur»-bar eller -glidebryter med verktøyene sine, slik at brukerne kan justere temperaturinnstillingene etter behov.

Samtidig kan bedrifter også angi en standardtemperatur slik at verktøyet kan generere fornuftige svar og finne den rette balansen mellom nøyaktighet og kreativitet.

#7. Verifiser alltid

Til syvende og sist er det ikke et smart trekk å stole 100 % på et KI-generert svar uten å dobbeltsjekke eller verifisere det.

Mens KI-selskaper og -forskere jobber med å løse problemet med hallusinasjoner og utvikle modeller som forhindrer dette, er det som bruker viktig å verifisere svarene en KI-modell genererer før du bruker eller tror fullt og helt på det.

Sammen med å bruke de ovennevnte beste metodene, fra å utforme spørsmålet med spesifikasjoner til å legge til eksempler i spørsmålet for å veilede KI, må du alltid verifisere og kryssjekke dataene en KI-modell genererer.

Kan KI-hallusinasjoner fullstendig fikses eller fjernes? En ekspertvurdering

Selv om kontroll av KI-hallusinasjoner avhenger av spørsmålet vi gir den, genererer modellen noen ganger svar med en slik selvtillit at det gjør det vanskelig å skille mellom hva som er sant og hva som er falskt.

Så, er det egentlig mulig å fullstendig fikse eller forhindre KI-hallusinasjoner?

Da han fikk dette spørsmålet, svarte Suresh Venkatasubramanian, en professor ved Brown University, at hvorvidt KI-hallusinasjoner kan forhindres eller ikke er et «punkt med aktiv forskning.»

Han forklarte videre at årsaken til dette er selve naturen til disse KI-modellene – hvor komplekse, intrikate og skjøre de er. Selv en liten endring i spørsmålet kan endre svarene betydelig.

Mens Venkatasubramanian anser løsningen på KI-hallusinasjoner som et forskningspunkt, mener Jevin West, professor ved University of Washington og medgründer av Center for an Informed Public, at KI-hallusinasjoner aldri vil forsvinne.

West mener det er umulig å reversere hallusinasjoner som oppstår fra KI-roboter eller chatbots. Derfor kan KI-hallusinasjoner alltid være der som en iboende egenskap ved KI.

I tillegg sa Sundar Pichai, Googles administrerende direktør, i et intervju med CBS at alle som bruker KI opplever hallusinasjoner, og ingen i bransjen har løst hallusinasjonsproblemet enda. Nesten alle KI-modeller står overfor dette problemet. Han hevdet og forsikret videre at KI-feltet snart vil utvikle seg når det gjelder å overvinne KI-hallusinasjoner.

Samtidig besøkte Sam Altman, administrerende direktør i OpenAI, som lager ChatGPT, Indraprastha Institute of Information Technology i Delhi i juni 2023. Der uttalte han at KI-hallusinasjonsproblemet vil være mye bedre om halvannet til to år.

Han la videre til at modellen må lære forskjellen mellom nøyaktighet og kreativitet, og når man skal bruke det ene eller det andre.

Oppsummering

KI-hallusinasjoner har fått en del oppmerksomhet de siste årene, og er et viktig fokusområde for bedrifter og forskere som forsøker å løse og overvinne det så raskt som mulig.

Selv om KI har gjort bemerkelsesverdige fremskritt, er den ikke immun mot feil. Problemet med KI-hallusinasjoner gir store utfordringer for flere individer og bransjer, inkludert helsevesenet, innholdsproduksjon og bilindustrien.

Mens forskerne gjør sitt, er det også vårt ansvar som brukere å stille spesifikke og nøyaktige spørsmål, legge til eksempler og gi datamaler for å få gyldige og fornuftige svar, unngå å forstyrre KI-modellens treningsdata og forebygge hallusinasjoner.

Om KI-hallusinasjoner kan kureres fullstendig eller fikses er fortsatt et spørsmål. Jeg tror personlig at det er håp, og at vi kan fortsette å bruke KI-systemer på en ansvarlig og sikker måte til fordel for verden.

Neste tema er eksempler på kunstig intelligens (KI) i hverdagen.