Forstå kraften i SEO-loggfilanalyse

SEO-loggfilanalyse gir deg verdifull innsikt i hvordan søkemotorroboter samhandler med nettsiden din, og avslører potensielle områder for teknisk SEO-optimalisering.

Å drive SEO uten å analysere søkerobotenes oppførsel er som å navigere uten kart. Selv om nettsiden din er registrert i Google Search Console og indeksert, vil du uten loggfilanalyse ikke ha en klar forståelse av om søkemotorer leser og gjennomsøker den på en optimal måte.

Denne artikkelen gir deg en omfattende guide for å analysere SEO-loggfiler, slik at du kan avdekke problemer og identifisere SEO-muligheter.

Hva er loggfilanalyse?

Loggfilanalyse er prosessen med å kartlegge hvordan søkemotorroboter interagerer med nettsiden din. Dette er en viktig del av teknisk SEO.

For SEO-eksperter er loggfilrevisjon avgjørende for å identifisere og løse problemer knyttet til gjennomsøking, indeksering og statuskoder.

Hva er loggfiler?

Loggfiler registrerer hvem som besøker nettsiden din og hvilket innhold de ser på. De inneholder informasjon om klienten, som er enheten som ber om tilgang til nettsiden.

Informasjonen kan dreie seg om søkemotorroboter som Google eller Bing, eller besøkende. Webserveren lagrer og vedlikeholder loggfilene, vanligvis i en begrenset periode.

Hvilken informasjon inneholder en loggfil?

For å forstå verdien av loggfiler for SEO, må du først vite hva de inneholder. En loggfil inneholder typisk følgende:

- URL-en til siden som besøkende eller roboten ber om.

- HTTP-statuskoden for siden.

- Serverens IP-adresse.

- Dato og tidspunkt for forespørselen.

- Brukeragentinformasjon (identifiserer søkemotorroboten).

- Forespørselsmetode (GET eller POST).

Loggfiler kan virke komplekse ved første øyekast. Men når du forstår deres formål og betydning for SEO, kan du bruke dem effektivt til å generere verdifull innsikt.

Hva er formålet med loggfilanalyse for SEO?

Loggfilanalyse hjelper deg med å håndtere viktige tekniske SEO-utfordringer, slik at du kan utvikle en effektiv SEO-strategi og optimalisere nettsiden din.

Her er noen SEO-problemer som kan identifiseres ved hjelp av loggfiler:

1. Hvor ofte Googlebot gjennomsøker nettstedet

Søkemotorroboter bør jevnlig gjennomsøke viktige sider for å holde søkemotorene oppdatert med nytt innhold og endringer.

Viktige produkt- og informasjonssider bør finnes i Googles logger. Manglende tilstedeværelse av viktige sider, eller tilstedeværelse av sider for utgåtte produkter, kan indikere et problem som kan avdekkes med loggfiler.

Hvordan bruker en søkemotorrobot «gjennomsøkingsbudsjettet»?

Hver gang en søkemotorrobot besøker nettsiden din, har den et begrenset «gjennomsøkingsbudsjett.» Google definerer dette som summen av et nettsteds gjennomsøkingshastighet og etterspørsel.

Dersom nettstedet inneholder mange lavkvalitets-URL-er eller URL-er som ikke er korrekt innsendt i nettstedskartet, kan gjennomsøkning og indeksering hindres. Optimalisering av gjennomsøkingsbudsjettet forenkler gjennomsøking og indeksering av viktige sider.

Loggfilanalyse bidrar til å optimalisere gjennomsøkingsbudsjettet, noe som igjen akselererer SEO-innsatsen din.

2. Problemer og status for mobil-først-indeksering

Mobil-først-indeksering er nå avgjørende for alle nettsider, og Google prioriterer den. Loggfilanalyse viser hvor ofte Googlebot for smarttelefoner gjennomsøker nettstedet ditt.

Dersom sidene ikke gjennomsøkes korrekt av Googlebot for smarttelefoner, kan dette informere om at nettsiden må optimaliseres for mobilbruk.

3. HTTP-statuskoder returnert av nettsider

De returnerte svarkodene kan hentes fra loggfiler eller via «hent og gjengi»-verktøyet i Google Search Console.

Loggfilanalysatorer kan identifisere sider med 3xx-, 4xx- og 5xx-koder. Du kan løse disse problemene ved å omdirigere URL-er eller endre 302-statuskoder til 301.

4. Analyse av gjennomsøkingsaktivitet, som gjennomsøkingsdybde og interne lenker

Google ser på nettstedets struktur basert på gjennomsøkingsdybde og interne lenker. Dårlig sammenkoblingsstruktur og gjennomsøkingsdybde kan føre til feil i gjennomsøking.

Loggfilanalyse kan hjelpe deg med å identifisere problemer med nettstedets hierarki, struktur eller interlink-struktur.

Loggfilanalyse er nyttig for å optimalisere nettstedets arkitektur og sammenkoblingsstruktur.

5. Oppdag «foreldreløse» sider

Foreldreløse sider er nettsider som ikke er koblet til fra andre sider på nettstedet. Disse er vanskelige å indeksere eller rangere i søkemotorer, da roboter ikke lett oppdager dem.

Crawlere som Screaming Frog kan identifisere foreldreløse sider. Problemet kan løses ved å koble disse sidene til andre sider på nettstedet.

6. Gjennomgang av sider for sidehastighet og brukeropplevelse

Sidehastighet og brukeropplevelse er nå viktige rangeringsfaktorer. Det er viktig at nettsidene samsvarer med Googles retningslinjer for sidehastighet.

Loggfilanalysatorer kan identifisere langsomme og store sider. Disse kan optimaliseres for sidehastighet, noe som bidrar til bedre SERP-rangering.

Loggfilanalyse gir deg kontroll over hvordan nettstedet ditt gjennomsøkes og hvordan søkemotorer behandler det.

Nå som vi har dekket det grunnleggende om loggfiler og deres analyse, la oss se på hvordan man utfører loggfilrevisjon for SEO.

Hvordan utføre loggfilanalyse?

Vi har sett på de ulike aspektene ved loggfiler og deres betydning for SEO. La oss nå se på prosessen med å analysere filene og de beste verktøyene for dette.

Du trenger tilgang til serverloggfilene for å analysere dem. Loggfiler kan analyseres på følgende måter:

Det er ulike trinn involvert i å få tilgang til loggfilene manuelt:

- Samle eller eksporter loggdataene fra webserveren og filtrer dem for søkemotorroboter.

- Konverter den nedlastede filen til et lesbart format ved hjelp av dataanalyseverktøy.

- Analyser dataene manuelt ved hjelp av Excel eller andre visualiseringsverktøy for å avdekke SEO-muligheter.

- Du kan også bruke filtreringsprogrammer og kommandolinjer.

Manuell dataanalyse krever kunnskap om Excel og involverer gjerne utviklingsteamet. Heldigvis finnes det en rekke verktøy som gjør denne prosessen enklere for SEO-eksperter.

La oss se på de beste verktøyene for loggfilrevisjon og hvordan de hjelper oss med å analysere loggfiler.

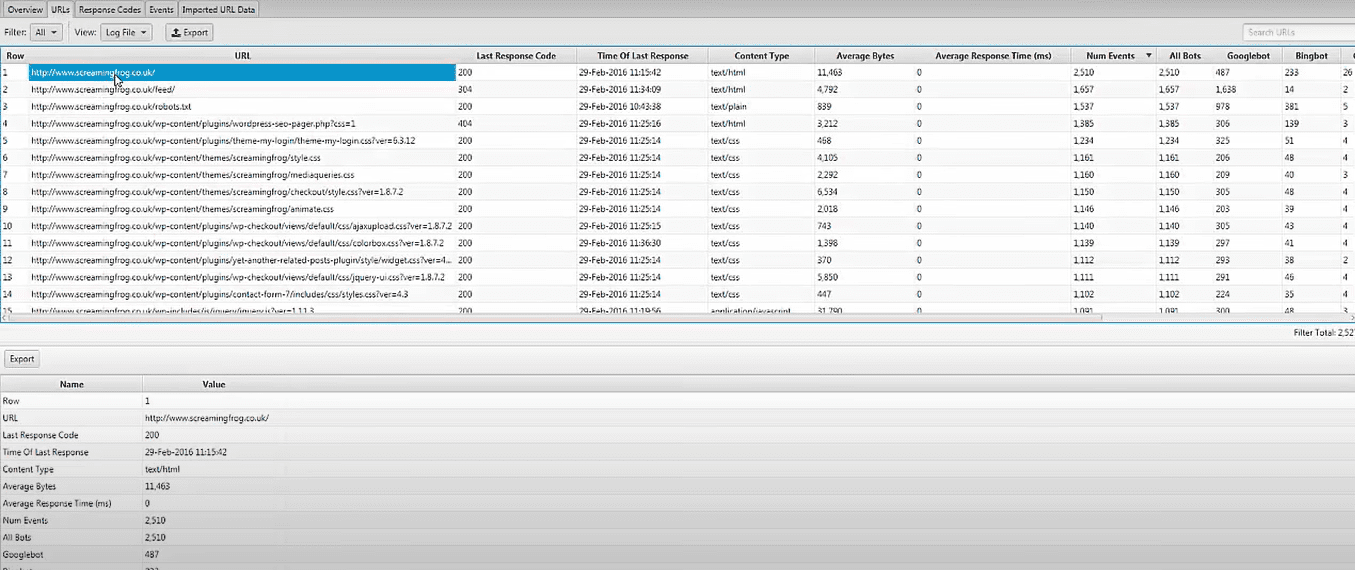

Screaming Frog Log File Analyzer

Med Screaming Frog Log File Analyzer, kan du identifisere tekniske SEO-problemer ved å laste opp loggfildata og verifisere søkemotorroboter. Du kan også:

- Analysere søkemotorbotaktivitet og data for søkemotoroptimalisering.

- Finne ut nettstedets gjennomsøkingsfrekvens av søkemotorroboter.

- Oppdage tekniske SEO-problemer og eksterne og interne ødelagte lenker.

- Analysere URL-er som gjennomsøkes minst og mest for å øke effektiviteten og redusere tap.

- Oppdage sider som ikke blir gjennomsøkt av søkemotorer.

- Sammenligne og kombinere alle data, inkludert eksterne lenkedata og annen informasjon.

- Se data om henvisningsadresser.

Screaming Frog Log File Analyzer er gratis for et enkelt prosjekt med en grense på 1000 logglinjer. Du må oppgradere til betalt versjon for ubegrenset tilgang og teknisk assistanse.

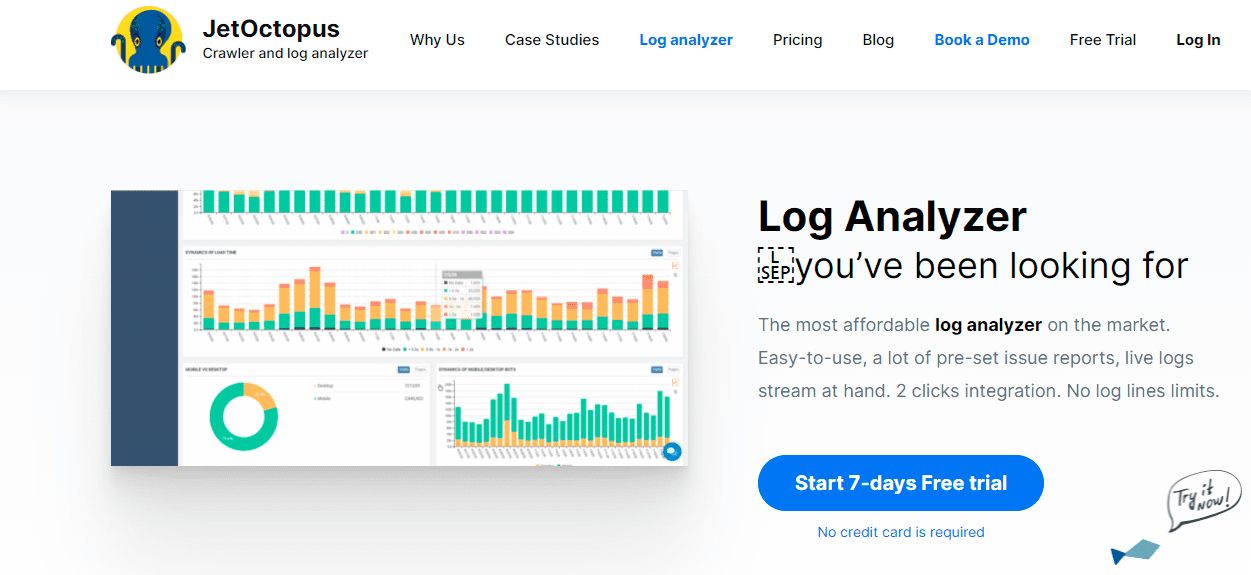

JetOctopus

JetOctopus Logganalysator er et prisgunstig logganalyseverktøy. Det tilbyr en 7-dagers gratis prøveperiode, uten kredittkort, og enkel tilkobling. Du kan identifisere gjennomsøkingsfrekvens, gjennomsøkingsbudsjett, mest populære sider og mye mer.

JetOctopus lar deg integrere loggfildata med Google Search Console, som gir deg et fortrinn. Du kan se hvordan Googlebot interagerer med nettstedet ditt og hvor du kan forbedre deg.

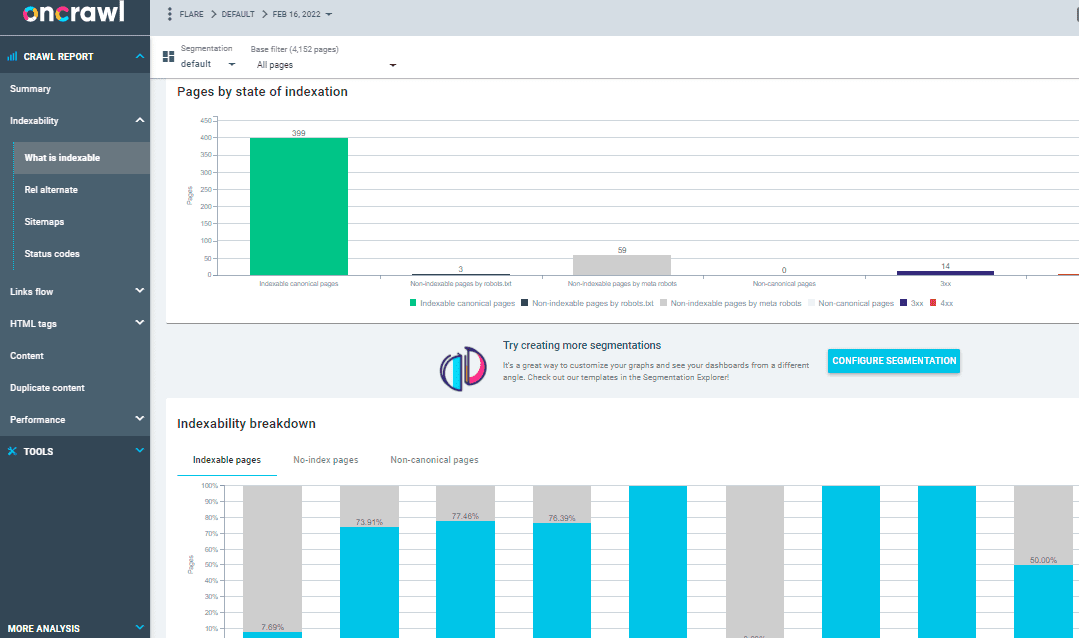

OnCrawl Log Analyzer

Oncrawl Log Analyzer behandler over 500 millioner logglinjer per dag og er et verktøy for mellomstore og store nettsider. Det overvåker nettserverlogger i sanntid for å sikre korrekt indeksering og gjennomsøking av sidene dine.

Oncrawl Log Analyzer er GDPR-kompatibel og svært sikker. I stedet for IP-adresser lagrer programmet alle loggfiler i en sikker og segregert FTP-sky.

I tillegg til JetOctopus og Screaming Frog Log File Analyzer tilbyr Oncrawl følgende funksjoner:

- Støtter mange loggformater, som IIS, Apache og Nginx.

- Verktøyet tilpasser seg dine endrede behandlings- og lagringsbehov.

- Dynamisk segmentering for å avdekke mønstre og sammenhenger i dataene.

- Du kan gruppere URL-er og interne lenker basert på ulike kriterier.

- Lager handlingsrettede SEO-rapporter fra de rå loggfilene.

- Automatisere overføring av loggfiler til din FTP-plass.

- Overvåker populære nettlesere, inkludert Google, Bing, Yandex og Baidu.

OnCrawl Log Analyzer har også to viktige tilleggsverktøy:

Oncrawl SEO Crawler: Gjennomsøker nettsiden din raskt og med minimale ressurser. Forbedrer forståelsen av hvordan rangeringskriterier påvirker SEO.

Ved gjennomsøkingsdata: Analyserer alle SEO-faktorer ved å kombinere data fra gjennomsøkingen og analyser. Henter data fra crawl- og loggfilene for å forstå crawl-atferden og anbefale crawl-budsjett til prioritert innhold eller rangering av sider.

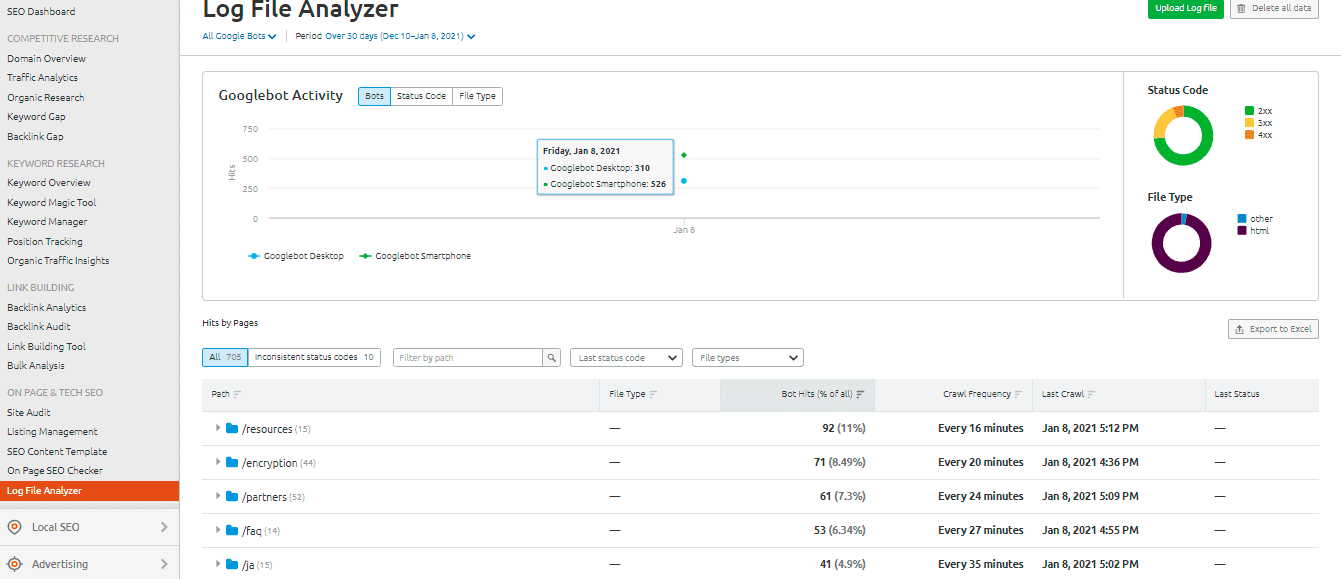

SEMrush Log File Analyzer

SEMrush Log File Analyzer er et brukervennlig, nettleserbasert logganalyseverktøy som ikke krever nedlasting.

SEMrush presenterer to rapporter:

«Sider» treff: Viser interaksjonen mellom webcrawlere og innholdet ditt. Data for sider, mapper og URL-er med maksimal og minimum interaksjon med roboter.

Googlebot aktivitet: Gir daglig innsikt, som:

- Typer gjennomsøkte filer.

- Generelle HTTP-statuskoder.

- Antall forespørsler som er gjort av ulike roboter.

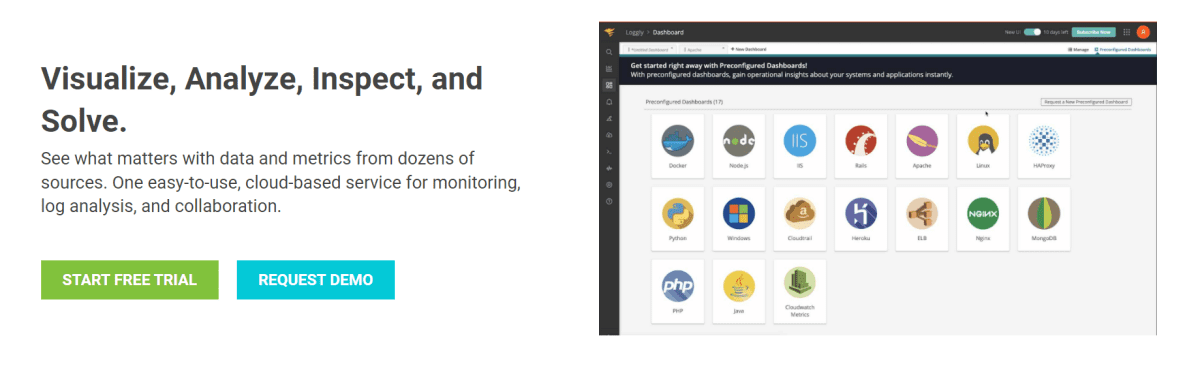

Loggly fra SolarWinds

SolarWinds Loggly undersøker tilgangs- og feilloggene til webserveren din, samt ukentlige beregninger. Du kan se loggdataene når som helst og det har funksjoner som gjør det enkelt å søke gjennom logger.

Et robust verktøy som SolarWinds Loggly er nødvendig for å effektivt analysere loggfilene. Informasjonen fra loggfilene er viktig for å identifisere suksess eller feil ved ressursforespørsler fra klienter.

Loggly kan vise diagrammer over de minst besøkte sidene og beregne gjennomsnittlige, minimums- og maksimum sideinnlastingshastigheter. Dette hjelper deg med å optimalisere nettstedets søkemotoroptimalisering.

Google Search Console Crawl Stats

Google Search Console forenkler analysen med en oversikt over praksisen. Bruken av konsollen er enkel. Gjennomsøkningsstatistikken din deles i tre kategorier:

- Kilobyte lastet ned per dag: Viser hvor mange kilobyte som lastes ned av Googlebot mens de besøker nettsiden. Dette indikerer om nettstedet gjennomsøkes ofte eller om boten bruker lang tid på å analysere nettstedet.

- Sider gjennomsøkt per dag: Forteller deg antall sider Googlebot gjennomsøker daglig. Den viser om gjennomsøkingsaktiviteten er lav, høy eller gjennomsnittlig. Lav gjennomsøkingshastighet kan indikere at Googlebot ikke gjennomsøker nettstedet korrekt.

- Tid brukt på å laste ned en side (i millisekunder): Dette viser tiden det tar Googlebot å lage HTTP-forespørsler når det gjennomsøker nettstedet. Mindre tid Googlebot bruker på å sende forespørsler er bedre for indekseringen og nedlastingshastigheten.

Konklusjon

Jeg håper denne veiledningen om loggfilanalyse og verktøy for å revidere loggfilene har vært nyttig. Loggfilrevisjon er svært effektivt for å forbedre de tekniske SEO-aspektene ved nettstedet.

Google Search Console og SEMrush Log File Analyzer er gode, gratis alternativer for et enkelt analyseverktøy. For en mer detaljert analyse, kan du sjekke ut Screaming Frog Log File Analyzer, JetOctopus eller Oncrawl Log Analyzer. Bruk gjerne en kombinasjon av premium og gratis verktøy.

Du kan også se på noen avanserte søkeroboter for å forbedre SEO.