Avanserte web-skrapere, ofte referert til som nettopplåsere, tilbyr en effektiv metode for å innhente data fra en rekke nettsider. Disse verktøyene er utstyrt med moderne funksjoner som kan bidra til å styrke virksomheten din.

Forretningsdata spiller en nøkkelrolle i å avdekke verdifull innsikt og muligheter for vekst.

Datainnsamling fra internett er viktig for effektiv markedsføring, og dette kan oppnås ved hjelp av nettopplåsere. Å utføre nettskraping manuelt krever betydelig tid og ressurser.

En nettopplåser kan øke effektiviteten, produktiviteten og nøyaktigheten, samtidig som den kan lede virksomheten din mot suksess gjennom automatisering av datautvinningsprosesser.

Denne artikkelen vil utforske viktigheten av nettskraping og hvordan en nettopplåser kan bidra til effektiv datauthenting.

Hva er nettskraping?

Nettskraping er en prosess for automatisk innsamling av strukturert data fra nettsider. I motsetning til manuell datahenting, som er tidkrevende, benytter nettskraping avanserte automatiseringsteknikker for å samle inn enorme mengder data fra nettet.

Data som hentes fra internett er ofte i HTML-format og er ustrukturert. Gjennom nettskraping kan disse dataene trekkes ut og omformes til strukturert data, som kan lagres i en database eller et regneark. Dette strukturerte data kan deretter brukes i forskjellige applikasjoner for å analysere strategier og utvikle egne.

Mange virksomheter og enkeltpersoner bruker nettskraping for å hente ut offentlig tilgjengelig informasjon fra nettsider for å generere innsikt og ta informerte beslutninger. Noen sentrale bruksområder for nettskraping inkluderer konkurrentanalyse, prisovervåking, markedsundersøkelser, nyhetsovervåking og generering av leads.

Utfordringer ved nettskraping

Selv om nettskraping er en nyttig teknologi for å samle spesifikke data, finnes det visse utfordringer knyttet til denne prosessen.

Bot-begrensninger

Nettsteder kan velge om de vil tillate web-skrapere å hente ut data. Mange nettsider blokkerer nettskraping fordi boter ofte belaster serverressursene under skraping, noe som kan påvirke nettstedets ytelse.

Hyppige endringer i struktur

For å forbedre brukergrensesnittet (UI) og brukeropplevelsen (UX), og legge til nye funksjoner, oppdateres nettsteder regelmessig. Nettskrapere er utviklet basert på nettsidens kodeelementer på et bestemt tidspunkt. Hyppige endringer kan komplisere prosessen og skape utfordringer for skrapere.

Selv om ikke alle strukturelle endringer påvirker datahentingen, kan noen endringer føre til tap av data. Det kan også være vanskelig for nettskrapere å holde tritt med endringer som gjøres mens brukerne henter ut data.

Captcha-utfordringer

Hovedformålet med captcha er å skille mellom mennesker og roboter ved å presentere logiske problemer. Dette bidrar til å forhindre uønsket spam. En captcha vil forhindre at grunnleggende skript som brukes av skrapere fungerer.

Risiko for blokkering

Hvis en nettskraperbot sender mange forespørsler samtidig eller unaturlig ofte, er det risiko for at boten overskrider grensen for etisk nettskraping og blir flagget. En dyktig nettskraper må kunne håndtere slike problemer ved å overholde skraperegler og oppnå målene på en ansvarlig måte.

Sanntids dataskraping

Sanntids dataskraping er viktig for mange virksomheter for å få kritisk innsikt og ta bedre avgjørelser. Dataskraping bidrar til å skaffe kapital til virksomheten din, fra aksjekurser som svinger til endringer i produktpriser.

Å håndtere store datasett kan være utfordrende, og å ta beslutninger basert på disse dataene kan kreve tid og ressurser. Sanntids nettskrapere bruker REST API for å overvåke og skrape dynamiske data. Imidlertid utgjør dette en utfordring. Uforsiktig skraping av data kan skade nettsiden og internett og ha negative konsekvenser for virksomheten.

Honeypot-feller

Nettstedeiere legger noen ganger ut en «honningkrukke» for å fange parsere. Dette kan være lenker som parsere kan se, men som ikke er synlige for vanlige brukere. Når en parser går i fellen, blokkerer nettstedet skraperroboten ved hjelp av informasjonen den mottar.

Innloggingskrav

Noen ganger er det nødvendig å logge inn for å få tilgang til informasjonen på en nettside. Når du logger inn, legger nettleseren en informasjonskapsel til forespørslene dine som utføres på et annet nettsted. Dette gjør det mulig for nettstedet å identifisere at du er den samme personen som logget inn tidligere, og det kan blokkere tilgangen din.

Hvordan kan Web Unlocker hjelpe?

En nettlåser er en avansert versjon av en nettskraper. Den hjelper digitale markedsførere, dataanalytikere og internettforskere med å få tilgang til nettsider (selv blokkerte) for forskningsformål. Den gir tilgang til hele internett ved å omgå blokkeringer, sperringer, captchas og begrensninger, samtidig som den automatiserer nettskrapingsprosessen.

Tilgang til offentlige data er lovlig i henhold til ulike regler. En nettlåser er utviklet for å fjerne hindringer i skrapingsprosessen. Med en nettlåser trenger du bare å sende forespørsler uten å bekymre deg for feller eller blokkeringer.

En nettlåser aktiverer følgende:

- Bruker automatisk en bolig-IP-adresse eller en datasenterproxy for å omgå botdeteksjonssystemer.

- Lar deg fremstå som en vanlig bruker av nettsteder.

- Løser innloggingsproblemer.

- Gir tilgang til lokalisert innhold over hele verden.

- Beskytter deg mot feller.

- Administrerer fullsyklus IP-rotasjon.

- Tilpasser fingeravtrykk i sanntid.

- Låser opp og løser captcha-relaterte problemer.

- Gir tilgang til geobegrensede nettsteder for datauthenting.

- Justerer seg selv for å forbli uoppdaget.

- Maskinlæringsalgoritmer i Web Unlocker gjør datauthenting enklere.

- Lar deg bruke skraping-API funksjonen.

- Holder deg uoppdagbar ved hjelp av et utvidet lager av nettleserinformasjonskapsler, emulerte enheter og HTTP-headerforespørsler.

- Lar deg sende et ubegrenset antall forespørsler for å hente inn ønsket data.

Hvordan fungerer en Web Unlocker?

For å hente ut de nødvendige dataene, må dette spesifiseres slik at en nettlåser kan trekke ut dataene nøyaktig og raskt.

Hvis du for eksempel ønsker en liste over juicepressere som er tilgjengelig på en shoppingnettside, og ikke kundeanmeldelser, kan du spesifisere dette i forespørselen.

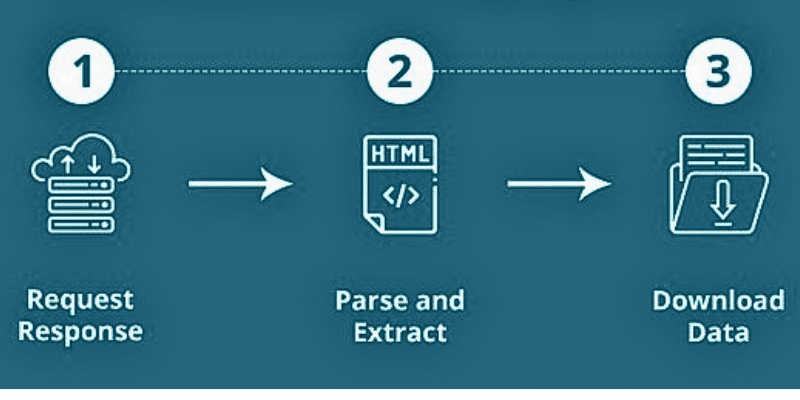

Når en nettlåser skraper en nettside, oppgis URL-ene først. Den laster deretter HTML-koder for lignende nettsider. En avansert skraper kan også trekke ut alle Javascript- og CSS-elementer. Deretter konverterer skraperen dataene i HTML-koden til et enkelt og forståelig format.

Kilde: Quora

Kilde: Quora

Vanligvis er utdataformatet i form av en CSV-fil eller et Excel-regneark. Dataene kan også lagres i andre formater, inkludert en JSON-fil.

Nettskraping består av to deler:

- Søkeroboten er en AI-algoritme som søker på internett etter spesifikk informasjon som kreves av lenkene på nettet.

- En skraper er et spesifikt verktøy utviklet for å samle inn data fra et nettsted. Designet varierer avhengig av kompleksiteten og omfanget av prosjektet.

På denne måten kan data hentes ut nøyaktig og raskt.

Viktigheten av en Web Unlocker

Enten du er nyoppstartet eller i vekst, kan datautvinning bidra til å øke virksomheten betydelig. Det er mange grunner til at utviklere, analytikere og bedrifter foretrekker en nettopplåser fremfor egenadministrerte proxyer og captcha-håndtering. La oss utforske hvordan nettskraping med en nettlåser kan være gunstig for virksomheter.

Forenkling av datautvinning

Moderne teknologier som nettopplåsere kan forenkle datautvinningsprosessen. De gjør det mulig for alle å enkelt trekke ut data i stor skala. I tillegg kan du få tilgang til roboter som kan samle data uansett omfang.

Rask innovasjon

Datainnsamling og skraping gjør at bedrifter kan innovere og utvikle nye produkter raskere. Mange selskaper vokser ved å samle inn og bruke data fra flere kilder. Med nettskraping kan du forbedre verditilbudet ditt. I tillegg hjelper det deg med å teste og implementere nye ideer med data hentet fra nettsider.

Generering av leads

Ved hjelp av en nettlåser kan du enkelt få tilgang til konkurrentenes forretningsdata. Dette hjelper deg også med å bygge automatiserte salgsmaskiner. Du kan søke og samle inn data ut fra det kvalitets- og nøyaktighetsnivået du trenger. Når du har de nødvendige dataene, kan du generere potensielle leads og opprettholde vekst.

Markedsføringsautomatisering

Dataskraping er nært knyttet til markedsføringsautomatisering. Hvis du for eksempel ser en konkurrentprofil på Instagram med mange følgere, og du vet at produktet ditt er bedre, vil brukerne kanskje bytte hvis de får vite om det. For å oppnå dette, trenger du bedre markedsføring.

Du kan for eksempel skrape data som inneholder følgerlisten, følge disse brukerne og sende dem en direktemelding. Du kan gjøre det samme på Twitter og Facebook, og også for konkurrentenes nettsider. Dette vil hjelpe deg med å vokse raskere i markedet, forstå hva kundene trenger, og tilby dem det de ønsker.

Merkeovervåking

De fleste kunder sjekker anmeldelser før de kjøper et produkt. Bedrifter må anbefale produkter i henhold til kundenes behov, slik at de er sikre på at de tar det riktige valget. Med en nettlåser kan du forstå kundene dine og tilby bedre tilbud.

Videre kan du overvåke sosiale medier og kombinere dette med sentimentanalyse for å svare på og belønne brukere raskt.

Markedsanalyse

Kvalitet fremfor kvantitet er det viktigste i dagens konkurranseutsatte verden. I stedet for store datamengder trenger du smart data.

Hvis du for eksempel selger reservedeler til maskiner, må du vite hva brukeren trenger delene til. Her er det bare nødvendig å samle data fra spesifikke nettsider som også distribuerer slike reservedeler.

Nå kan du forbedre salget ved hjelp av dataene du har hentet ut. Dette hjelper deg med å analysere markedet grundig og øke salget.

Maskinlæring og dyp læring

Du trenger store mengder data for å trene maskinene dine til å bygge en modell i henhold til input. Data er den primære inputen når du vil at maskinen skal gjøre jobben.

Enten du ønsker å forutsi aksjemarkedet eller analysere konkurrentenes salgsstrategi, er datautvinning fra nettsider ved hjelp av maskinlæring og dyp læring et godt steg mot suksess.

SEO (Søkemotoroptimalisering)

SEO-eksperter bruker forskjellige verktøy for å finne de rette søkeordene for innhold. Datainnsamling med en nettlåser gjør dette enklere. SEO-eksperter bruker datautvinning for å analysere konkurrentenes SEO-innsats og se hvordan deres innhold presterer. Dette hjelper deg også med å forstå hvilke endringer du må gjøre for å forbedre din egen SEO.

Ende-til-ende testing

For utviklere kan datautvinning fra ulike kilder bidra til å forbedre testarbeidet og spare tid på prosesser som ikke gir resultater.

Nettopplåsere

Her er noen av de beste nettopplåserne du kan bruke for å starte datautvinning:

#1. Bright Data

Bright Data tilbyr en nettopplåser som hjelper deg med å omgå blokkeringer av nettsteder i sanntid. Denne automatiserte nettlåseren håndterer nettleserens brukeragenter, captcha-løsning og informasjonskapsler. Den skraper også data fra målnettsteder ved hjelp av IP-adresserotasjon.

Slik bruker du denne nettopplåseren:

- Velg nettstedet du vil låse opp.

- Lag en enkel proxy-forespørsel med nettstedets URL.

- Få dataene du trenger.

Med Bright Datas Web Unlocker vil du ikke lenger bli blokkert. Den utvikler automatisk nye metoder for å holde nettsider åpne for datautvinning til enhver tid. Den administrerer også IP-bruksrater slik at du ikke overbelaster nettstedet med forespørsler fra én IP-adresse. I tillegg emulerer den enheter som servere vil gjenkjenne.

Du får automatisert brukeremulering, som inkluderer å klikke på spesifikke lenker til hjemmesider, simulere menneskelige musebevegelser og mer. Web Unlocker sørger for at det ser ut som du kommer fra en populær nettside. Den identifiserer også honeypot-feller og unngår dem.

#2. Oxylabs

Med Oxylabs Web Unblocker får du blokkeringsfri dataskraping i stor skala. Få tilgang til offentlig data fra vanskelige nettsider og betal kun for vellykket datautvinning. Du får ML-drevet administrasjon av proxyer, dynamiske nettleserfingeravtrykk, automatisk forsøk på nytt-funksjonalitet og ML-drevet responsgjenkjenning.

Oxylabs sørger for at IP-adressen din ikke blir blokkert ved hjelp av en AI-drevet proxy-løsning. Den omgår anti-bot-systemer med høy suksessrate og sparer ressurser. Dynamisk fingeravtrykk gjør at du ser innhold som en ekte bruker.

Oxylabs Web Unblocker velger de riktige informasjonskapslene, overskriftene, JavaScript-gjengivelsen og mer for deg, slik at du kan få pålitelige resultater og menneskelignende surfing, uten å støte på captcha-relaterte problemer. Uansett hvor du er, kan du få tilgang til lokalisert innhold fra hvor som helst i verden.

Du får tilgang til mer enn 102 millioner etisk genererte proxy-pooler, som lar deg samle offentlig data uten problemer. I tillegg får du økt kontroll, et praktisk dashbord, enkel skalering, JavaScript-gjengivelse med mer.

Konklusjon

Nettskraping er gunstig for virksomheter som vil samle inn viktig forretningsdata og bruke disse til å forbedre virksomheten. Manuell nettskraping er kjedelig og tidkrevende, og derfor bruker moderne organisasjoner nettskrapingsverktøy for å automatisere datainnsamling.

Nettskrapingsverktøy har imidlertid også visse utfordringer. Etter hvert som teknologien utvikles, finner nettsteder stadig nye måter å oppdage og blokkere mindre avanserte nettskrapere. En nettlåser kan være til hjelp, da dette er en mer avansert form for nettskraper som kan omgå restriksjoner, blokkeringer og sperringer. Dette vil bidra til å øke effektiviteten i nettskrapingsprosesser.

Hvis du er ute etter et kraftig verktøy for nettskraping, bør du vurdere å bruke en nettlåser. Ovenfor er noen av de beste nettlåserne som er tilgjengelige på markedet, som du kan velge ut fra dine behov.

Du kan også utforske noen av de beste skraperne for sosiale medier for å trekke ut verdifull data.