La oss begynne med et eksempel, en tilsynelatende «spesiell» tale av «POTUS» Joe Biden:

Dette kan gi et inntrykk av hvordan en deepfake (stemme)-svindel kan manifestere seg. Faktisk ble dette laget med et gratis AI-stemmekloningsverktøy. Jeg brukte litt over fem minutter på å skrive (med hjelp fra ChatGPT) og deretter lime inn teksten for å konvertere den til en tale som liknet Bidens.

Deepfake-svindel er imidlertid langt mer avansert enn dette. Det eneste som kreves er et par høykvalitetsbilder, videoer eller lydopptak av den utsatte personen (offeret) og et kraftig grafikkort for å komme i gang.

Men hensikten med denne artikkelen er ikke å diskutere hvordan man produserer deepfake-videoer. Den omhandler heller ikke hvordan man avslører slike manipulasjoner.

I stedet skal vi gi en kort innføring i deepfakes og presentere noen av de svindelformene du bør være oppmerksom på.

Hva er Deepfakes?

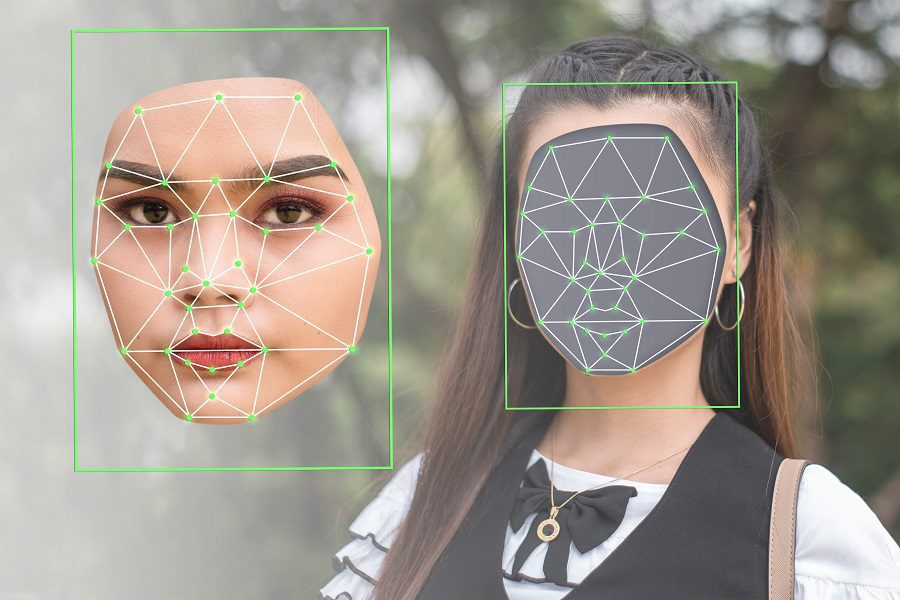

Deepfake er et sammensatt ord, dannet av «deep» (som refererer til dyp læring, teknologien som brukes til å generere dem) og «fake» (som indikerer at det er snakk om falskt innhold).

Kort sagt, algoritmer for dyp læring benyttes for å produsere overbevisende bilder, lyd eller videoinnhold basert på eksisterende innhold med høy oppløsning.

Dette er et typisk eksempel på en deepfake, og den fremstår som relativt troverdig. Likevel er den fem år gammel, og teknologien utvikler seg i et raskt tempo.

Slike manipulasjoner brukes ikke bare for underholdning eller for å demonstrere AI-ferdigheter. Et alvorlig eksempel er en video der det ser ut som «Volodymyr Zelenskyj» oppfordrer sine tropper til å overgi seg i den pågående krigen mellom Russland og Ukraina.

Dessverre er ikke dette et enkeltstående tilfelle. Ifølge Regula Forensics 2023-rapport, har 37 % av organisasjoner globalt blitt utsatt for deepfake-stemmesvindel, 29 % har opplevd syntetisk videosvindel, og 46 % har opplevd forsøk på identitetstyveri.

Det er tydelig at dette ikke bare handler om underholdning. Deepfakes blir i stor grad brukt til å spre feilinformasjon og misbrukt på en rekke andre måter, noe som kan være skadelig og forstyrrende for de berørte.

Det er dessuten vanskelig å bekjempe falskt innhold. De er en utilsiktet konsekvens av den raske utviklingen innen AI-teknologi, og det faktum at slike verktøy nå er lett tilgjengelige for offentligheten.

Derfor er bevissthet det viktigste forsvaret vi har.

La oss se nærmere på noen av de vanligste formene for deepfake-svindel.

Typer Deepfake-svindel

Basert på innhold og formål, kan deepfake-svindel deles inn i flere kategorier, som:

- Videoetterligning

- Falske jobbintervjuer

- Falske nyheter

- Stemmesvindel

- Honningfeller

- Kundeservice-svindel

- Falske attester

De neste avsnittene vil utdype disse kategoriene og noen av deres variasjoner.

Videoetterligning

Dette er en velkjent form for deepfake-svindel der en video er manipulert for å fremstå som en bestemt person av høy profil. Typiske ofre kan være presidenter (som i tilfellet med Obama-deepfake), populære skuespillere eller administrerende direktører i anerkjente selskaper.

Det som gjør dem til lette mål er den offentlige tilgjengeligheten av bilder, taler og lignende. Verktøyene som brukes til å lage deepfake-videoer fungerer godt med variert input, og kan etterligne ulike følelser, ansiktsvinkler, lysforhold, bakgrunner og mer.

Formålet med slike etterligninger kan være alt fra harmløs underholdning til utpressing, politisk manipulering, ærekrenkelse eller andre skadelige handlinger.

I noen tilfeller kan man se deepfake-videoer av familiemedlemmer som ber om penger eller tilgang til verdifulle eiendeler.

Falske jobbintervjuer

Det er unødvendig å si at falske jobbintervjuer ved hjelp av deepfake-teknologi har som mål å fylle ledige stillinger på avstand. Disse svindelene bruker deepfake-videoer i sanntid gjennom konferanseplattformer som Zoom.

I tillegg til å risikere å ansette en udugelig kandidat, løper bedriften også risikoen for å eksponere sensitive data for en bedragerisk person. Dette kan ikke bare skade bedriften, men også landets interesser, avhengig av virksomhetens natur.

Et enklere mål med falske intervjuer kan være å få betalt i verdifull valuta.

På den annen side kan svindlere kreve intervjuavgift av intetanende kandidater for å tilby dem muligheten til å presentere seg for «industrimagnater» i håp om drømmejobben.

Falske nyheter

En svært vanlig form for deepfake-svindel er spredning av falske nyheter. Slike nettbaserte desinformasjonskampanjer utgjør en betydelig fare, spesielt i vanskelige situasjoner som opptøyer eller kriger.

De kan også være skadelige for offentlige personer når deres deepfake-replikaer kommer med uttalelser de aldri har gjort i virkeligheten.

Slike falske nyheter spres i stor grad gjennom sosiale medier og plattformer som YouTube, og sprer seg som ild i tørt gress. Dette skaper en atmosfære der vanlige brukere blir usikre på ektheten av det de ser.

Stemmesvindel

Syntetisk tale er, i likhet med falske videoer og bilder, en annen teknologi som brukes til å svindle folk.

For eksempel opplevde Jennifer DeStefano, en kvinne fra Arizona, at hun hørte sin 15 år gamle datter hulke i telefonen, mens en mann krevde 1 million dollar for å frigi henne. Moren var overbevist om at datteren var i fare. Før hun rakk å vurdere å betale, kontaktet venninnen hennes ektemannen, som bekreftet at datteren var i sikkerhet.

DeStefano fortalte senere at hun fullt ut trodde på stemmen, ikke bare lyden, men også den generelle tonen, som var identisk med hvordan datteren hennes vanligvis snakker.

Dette er et resultat av stemmekloning ved hjelp av lydopptak fra kilden.

Honningfeller

En tradisjonell honningfelle er når noen lokkes inn i et forhold for å utpresse sensitiv informasjon. Honningfeller retter seg vanligvis mot personer med høy profil, som ansatte i militæret, ledende tjenestemenn eller politikere.

Med deepfake-teknologi kan disse honningfellene gjennomføres online og i stor skala. Dette betyr at offeret kan motta venneforespørsler fra attraktive profiler i sosiale medier som raskt blir intime, med det endelige målet om økonomisk eller informativ utpressing.

Slike deepfake-svindler er som regel gjennomtenkte operasjoner som bygges gradvis opp før det endelige målet fullføres.

Kundeservice

Svindel med teknisk støtte er et svært vanlig problem. Du har kanskje hørt om svindel der en person som utgir seg for å være fra «Microsoft», krever betaling for å løse «alvorlige» problemer med datamaskinen.

Før deepfake-teknologien kom, avslørte aksent eller uvanlig tale ofte svindlerne. Men nå har de AI-superkrefter som gjør det lettere å lure intetanende brukere til å tro at de faktisk snakker med en legitim representant for selskapet.

Falske attester

Mange av oss leser kundeanmeldelser før vi kjøper et produkt. På samme måte er det å se videoanbefalinger blitt en vanlig måte å gjøre innkjøp på.

Denne typen deepfake-svindel kan få flere til å anbefale et dårlig produkt, noe som påvirker kjøpsbeslutningene og kaster bort penger og tid for kundene.

Det er mange flere!

Hva ser du mest av på internett, bortsett fra tekst?

Sannsynligvis videoer, bilder og lyd. Alt dette kan manipuleres ved hjelp av AI-teknologi, noe som gjør internett til et gunstig sted for svindel i nær fremtid. I tillegg blir det stadig enklere å lage deepfakes, noe som gjør det vanskelig for vanlige brukere å holde seg informert.

I en slik situasjon, hvor det knapt finnes noe som stopper den utbredte misbruken av denne teknologien, er det viktig at vi i det minste forsøker å holde oss oppdaterte.

PS: Når det gjelder underholdning, finnes det også deepfake-apper som kan brukes til å lage morsomme memes som kan oversvømme sosiale medier.