Forståelse og håndtering av algoritmisk bias

Algoritmisk bias, eller skjevhet, er et fenomen som har potensiale til å påvirke mange aspekter av våre daglige liv. Fra anbefalinger av innhold på internett til hvordan vi finner jobber og tar økonomiske beslutninger, kan algoritmer med innebygd bias føre til urettferdige utfall.

Menneskelig bias er en iboende del av vår eksistens. Hvert individ har sin egen unike bakgrunn, erfaringer, og perspektiver formet av kjønn, rase, oppvekst, utdanning, kultur og tro.

Dette mangfoldet av erfaringer resulterer i forskjeller i meninger, tanker, preferanser og smak. Disse forskjellene kan i sin tur føre til utvikling av bias, enten positiv eller negativ, mot visse grupper eller kategorier.

Maskiner er intet unntak. Algoritmer kan også reflektere bias, da disse er utviklet av mennesker og trent på data som kan inneholde skjevheter. Denne algoritmisk bias kan føre til at AI- og maskinlæringssystemer leverer urettferdige resultater og dermed hindrer enkeltpersoner på mange forskjellige måter.

I denne artikkelen skal vi undersøke hva algoritmisk bias innebærer, se på de ulike formene det kan ta, og diskutere hvordan vi kan oppdage og redusere denne bias for å skape mer rettferdige resultater.

La oss begynne å utforske dette viktige temaet!

Hva er algoritmisk bias?

Algoritmisk bias kan beskrives som en tendens for maskinlærings- og AI-algoritmer til å gjenspeile menneskelig bias og dermed generere urettferdige resultater. Denne bias kan baseres på faktorer som kjønn, alder, rase, religion, etnisitet, kultur og mer.

I sammenheng med kunstig intelligens og maskinlæring, refererer algoritmisk bias til systematiske og gjentakende feil som er innebygd i systemet. Dette fører til urettferdige resultater og kan oppstå på grunn av mange faktorer. Dette kan for eksempel være knyttet til hvordan data samles inn, velges, kodes eller brukes til å trene algoritmen, algoritmens design eller den tiltenkte bruken av algoritmen.

For eksempel kan algoritmisk bias observeres i resultater fra søkemotorer, noe som kan føre til brudd på personvern eller forsterke sosiale skjevheter. Det finnes mange tilfeller av algoritmisk bias innenfor felt som valgresultater, spredning av hatprat på nettet, helsevesen, rettssystem og rekruttering. Dette bidrar ofte til å forsterke eksisterende skjevheter knyttet til kjønn, rase, økonomi og samfunn generelt.

Ulike typer algoritmisk bias

1. Databias

Databias oppstår når datasettet som brukes til å trene en AI-modell ikke representerer den reelle verden eller den relevante befolkningen på en korrekt måte. Dette kan resultere i ubalanserte eller skjeve datasett.

Kilde: TELUS International

Kilde: TELUS International

Et eksempel er et ansiktsgjenkjenningssystem som primært er trent på bilder av mennesker med lys hud. Dette systemet kan ha vanskeligheter med å gjenkjenne personer med mørkere hudtoner, noe som kan føre til diskriminering.

2. Målingsbias

Målingsbias oppstår som følge av feil i selve måle- eller datainnsamlingsprosessen.

For eksempel, hvis en diagnostisk algoritme for helsevesenet er trent til å oppdage en sykdom basert på data som antall tidligere legebesøk, kan dette føre til feilaktige konklusjoner. Algoritmen kan overser faktiske symptomer og dermed introdusere skjevhet.

3. Modellbias

Modellbias oppstår under selve utformingen av algoritmen eller AI-modellen.

Tenk deg for eksempel et AI-system som er utviklet for å maksimere fortjeneste uansett. Dette kan føre til at systemet prioriterer økonomisk gevinst over forretningsetikk, sikkerhet eller rettferdighet.

4. Evalueringsbias

Evalueringsbias oppstår når kriteriene som brukes til å evaluere ytelsen til et AI-system er partiske.

Kilde: Clear Review

Kilde: Clear Review

Et eksempel er et AI-system for ytelsesevaluering som bruker standardtester som favoriserer en bestemt gruppe ansatte, noe som kan føre til ulikhet i bedriften.

5. Rapporteringsbias

Rapporteringsbias kan oppstå når treningsdatasettet ikke nøyaktig gjenspeiler hendelsesfrekvensen i den virkelige verden.

For eksempel, et AI-sikkerhetsverktøy kan flagge en hel kategori som mistenkelig hvis det er trent på et datasett hvor alle historiske hendelser knyttet til den kategorien var merket som usikre, selv om dette ikke nødvendigvis er tilfellet.

6. Seleksjonsbias

Seleksjonsbias oppstår når treningsdataene velges uten tilstrekkelig randomisering, eller hvis de ikke representerer hele populasjonen på en god måte.

Et ansiktsgjenkjenningsverktøy som er trent på begrensede data kan begynne å diskriminere data det møter sjeldnere. For eksempel kan det ha vanskeligheter med å identifisere fargede kvinner i politikken sammenlignet med menn eller personer med lysere hud.

7. Implisitt bias

Implisitt bias oppstår når en AI-algoritme gjør antakelser basert på personlige erfaringer som ikke nødvendigvis gjelder for bredere kategorier eller mennesker.

Tenk deg en dataforsker som designer en algoritme og har en personlig preferanse for at kvinner liker rosa fremfor blått eller svart. Da kan systemet gi anbefalinger basert på denne antakelsen, noe som åpenbart ikke gjelder for alle kvinner.

8. Gruppeattribusjonsbias

Gruppeattribusjonsbias oppstår når designere av algoritmer overfører egenskaper som er ment for bestemte individer til hele grupper, uavhengig av om de individene faktisk er representanter for hele gruppen. Dette er en vanlig feil i rekrutterings- og opptaksverktøy.

For eksempel kan et opptaksverktøy favorisere kandidater fra en bestemt skole, og dermed diskriminere søkere som ikke har gått på den skolen.

9. Historisk bias

Historiske data er viktige når man trener maskinlæringsalgoritmer. Likevel kan skjevheter i disse dataene overføres til algoritmen hvis man ikke er forsiktig.

Et eksempel er en AI-modell som trenes med ti år med historiske data for å vurdere kandidater til tekniske stillinger. Hvis datasettet inneholder flere menn enn kvinner, kan modellen ubevisst favorisere mannlige søkere.

10. Etikettbias

Etikettbias oppstår i prosessen med å merke data for trening av maskinlæringsalgoritmer. Inkonsekvenser i merkingen kan føre til bias i systemet.

La oss anta at vi trener en algoritme til å gjenkjenne katter i bilder. Hvis vi bare merker bilder av katter der ansiktet er synlig, kan algoritmen få problemer med å gjenkjenne katter i bilder der bare kroppen vises, men ikke ansiktet.

11. Eksklusjonsbias

Kilde: ResearchGate

Kilde: ResearchGate

Eksklusjonsbias oppstår når en person, gruppe eller kategori utilsiktet eller med vilje blir ekskludert under datainnsamling fordi de ansees som irrelevante. Dette skjer ofte under dataforberedelsesstadiet i maskinlæringsprosessen.

Et AI-basert system som skal forutsi populariteten til et produkt om vinteren basert på kjøpsdata. Hvis systemet fjerner data fra oktober fordi man anser det som feil, vil det skape en bias mot de stedene der vinteren faktisk starter i oktober.

Hvordan introduseres bias i algoritmer?

Treningsdata

Den primære kilden til algoritmisk bias er partiske treningsdata som brukes for å utvikle AI- og maskinlæringsalgoritmer. Hvis dataene i seg selv er skjeve, vil algoritmen lære og opprettholde disse skjevhetene.

Design

Utvikleres personlige tanker eller preferanser kan bevisst eller ubevisst påvirke designen av en algoritme, som igjen kan føre til at AI-systemet blir partisk.

Beslutningstaking

Dataforskere og ledere tar ofte beslutninger basert på sine egne erfaringer og overbevisninger, og disse beslutningene kan også reflekteres i algoritmene, noe som fører til bias.

Mangel på mangfold

Mangel på mangfold i utviklingsteam kan føre til at algoritmene som utvikles ikke representerer hele befolkningen. Teammedlemmer som mangler erfaring eller eksponering for ulike kulturer, bakgrunner eller overbevisninger, kan skape partiske algoritmer.

Dataforbehandling

Metodene som brukes til å rense og behandle data kan også introdusere algoritmisk bias. Hvis disse metodene ikke er utviklet nøye med tanke på å motvirke bias, kan det forsterke skjevheter i AI-modellen.

Arkitektur

Modellarkitektur og valget av maskinlæringsalgoritme kan også bidra til bias. Noen algoritmer er mer utsatt for skjevheter enn andre.

Funksjonsvalg

Valget av hvilke funksjoner som brukes til å trene en AI-algoritme er en annen kilde til bias. Hvis man ikke vurderer hvordan disse funksjonene påvirker rettferdigheten i resultatet, kan det oppstå skjevheter som favoriserer enkelte grupper.

Historie og kultur

Algoritmer som trenes med data fra spesifikke historiske perioder eller kulturer, kan arve bias som fordommer, tro eller normer. Disse skjevhetene kan påvirke resultatet, selv om de er urettferdige eller irrelevante i dagens situasjon.

Datadrift

Data som er brukt til å trene en algoritme kan bli irrelevante eller foreldet over tid på grunn av endringer i teknologi eller samfunnet. Likevel kan disse dataene introdusere bias og påvirke ytelsen.

Tilbakemeldingssløyfer

AI-systemer som tilpasser seg brukernes atferd kan forsterke eksisterende bias. Når brukernes personlige preferanser påvirker systemet, kan det skape en partisk tilbakemeldingssløyfe.

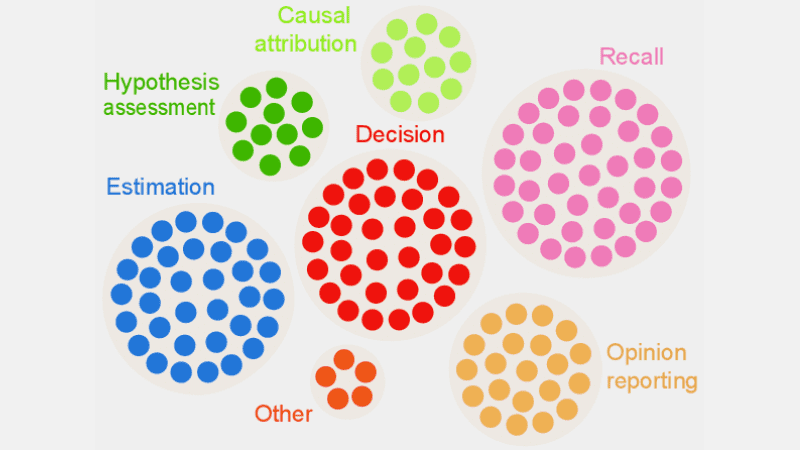

Hvordan oppdage algoritmisk bias?

Definer hva som er «rettferdig»

For å oppdage bias er det viktig å definere hva som menes med «rettferdig» i sammenheng med AI-systemet. Dette kan innebære å vurdere faktorer som kjønn, alder, rase, seksualitet, region og kultur. Deretter er det viktig å bestemme hvordan rettferdighet skal måles ved hjelp av metrikker som like muligheter, prediktiv paritet eller virkningsberegninger. Når du har definert hva som anses som rettferdig, blir det lettere å identifisere urettferdigheter og bias.

Revidere treningsdata

En grundig analyse av treningsdataene er nødvendig for å identifisere ubalanser og mangler i representasjonen av ulike grupper. Det er viktig å undersøke funksjonsdistribusjonen og sammenligne den med den faktiske demografiske sammensetningen. Visualisering av dataene ved hjelp av histogrammer, varmekart eller spredningsplott kan hjelpe med å avdekke mønstre og ulikheter som ellers kan bli oversett. I tillegg til interne revisjoner, kan man også involvere eksterne eksperter for å evaluere fordommer i systemet.

Måle modellers ytelse

For å oppdage bias, bør man måle ytelsen til AI-modellen for ulike demografier og kategorier. Del treningen inn i grupper basert på for eksempel rase eller kjønn, og bruk rettferdighetsmålene dine for å analysere forskjellene i resultatene.

Bruk egnede algoritmer

Velg algoritmer som fremmer rettferdige resultater og som kan håndtere bias under trening av AI-modellen. Rettferdighetsbevisste algoritmer er utviklet for å unngå bias samtidig som de gir likeverdige prediksjoner på tvers av ulike kategorier.

Bias deteksjonsprogramvare

Spesialiserte verktøy og biblioteker med rettferdighetsbevissthet kan brukes til å oppdage bias. Disse verktøyene tilbyr rettferdighetsmålinger, visualiseringer, statistiske tester og andre funksjoner for å oppdage bias. AI Fairness 360 og IBM Fairness 360 er noen populære alternativer.

Innhent tilbakemelding fra brukerne

Be brukere og kunder om tilbakemelding på AI-systemet. Oppmuntre dem til å være ærlige om eventuelle opplevelser med urettferdig behandling eller bias i systemet. Denne tilbakemeldingen kan hjelpe med å avdekke problemer som ikke nødvendigvis fanges opp av automatiserte verktøy eller andre gjenkjenningsprosedyrer.

Hvordan redusere bias i algoritmer

Diversifiser bedriften din

Et mangfoldig arbeidsmiljø og utviklingsteam bidrar til raskere oppdagelse og fjerning av bias. Bias som kan være vanskelig for noen å oppdage, kan lett merkes av de som faktisk påvirkes av den.

Sørg for at bedriften din er mangfoldig i form av demografi, ferdigheter og ekspertise. Dette kan inkludere personer med forskjellig kjønn, identitet, rase, hudfarge, økonomisk bakgrunn, utdanningsnivå og mer. Dette mangfoldet av perspektiver vil bidra til å skape mer rettferdige AI-algoritmer.

Fremme åpenhet

Vær åpen om målene, algoritmene, datakildene og beslutningene som er tatt i utviklingen av AI-systemet. Dette vil hjelpe brukerne å forstå hvordan systemet fungerer og hvorfor det genererer visse resultater. Åpenhet er viktig for å bygge tillit.

Rettferdighetsbevisste algoritmer

Bruk rettferdighetsbevisste algoritmer når du utvikler modellen, for å sikre at rettferdige resultater genereres for alle grupper. Dette er spesielt viktig i høyt regulerte bransjer som finans og helsevesen.

Evaluer modellens ytelse

Test AI-modellen din for å evaluere ytelsen på tvers av forskjellige grupper og undergrupper. Dette vil bidra til å identifisere problemer som ikke kommer frem i de samlede beregningene. Du kan også simulere ulike scenarier for å analysere ytelsen under forskjellige forhold.

Følg etiske retningslinjer

Utarbeid etiske retningslinjer for utvikling av AI-systemer som respekterer rettferdighet, personvern, sikkerhet og menneskerettigheter. Disse retningslinjene bør håndheves i hele organisasjonen for å sikre at rettferdighet gjenspeiles i AI-systemets resultater.

Angi kontroller og ansvar

Tildel klart definerte ansvarsområder til alle i teamet som jobber med design, utvikling, vedlikehold og distribusjon av AI-systemet. Etabler også solide kontrollrutiner med klare protokoller og rammeverk for å håndtere bias, feil og andre bekymringer.

I tillegg til disse tiltakene bør du gjennomføre regelmessige revisjoner for å redusere bias og kontinuerlig forbedre systemet. Hold deg oppdatert med endringer i teknologi, demografi og andre relevante faktorer.

Eksempler på algoritmisk bias fra virkeligheten

1. Amazons algoritme

Amazon, en ledende aktør innen netthandel, har hatt problemer med bias i sitt rekrutteringsverktøy. AI-systemet brukte CV-er fra tidligere søkere til tekniske stillinger for å evaluere jobbsøkere, men hadde en innebygd kjønnsbias. Systemet hadde blitt trent på en datasett som inneholdt flere mannlige søkere, og favoriserte derfor mannlige søkere fremfor kvinner i tekniske stillinger. Selv etter å ha forsøkt å redusere bias, ble verktøyet avviklet i 2017.

2. Rasistiske algoritmer i det amerikanske helsevesenet

En algoritme som ble brukt av amerikanske sykehus for å forutse pasienter som trengte ekstra omsorg, viste seg å være sterkt partisk mot svarte pasienter. Systemet evaluerte pasientenes medisinske behov basert på deres utgiftshistorikk i helsevesenet og korrelerte kostnadene med medisinske behov. Algoritmen ignorerte det faktum at svarte pasienter hadde høyere utgifter til akuttmedisinske behov til tross for dårligere helse. Dette førte til at de feilaktig ble kategorisert som friskere enn hvite pasienter, og derfor ikke fikk den ekstra behandlingen de hadde behov for.

3. Googles diskriminerende algoritme

Googles annonsesystem ble også funnet diskriminerende ved å vise stillingsannonser for høytlønnede stillinger, som direktørstillinger, mye oftere til menn enn kvinner. Til tross for at 27 % av amerikanske direktører er kvinner, viste Google disse annonsene til kvinner mye sjeldnere, rundt 11 %.

Dette kan skyldes at algoritmen har lært fra brukeratferd, der menn oftere ser på og klikker på annonser for høytlønnede stillinger. AI-algoritmen ville da vise annonsene oftere til menn enn kvinner.

Konklusjon

Algoritmisk bias i maskinlæring- og AI-systemer kan føre til urettferdige resultater som kan påvirke enkeltpersoner på mange ulike felt. Fra helsevesenet og nettsikkerhet til e-handel, valg og rekruttering. Dette kan føre til diskriminering basert på kjønn, rase, demografi, seksuell legning og andre faktorer.

Det er derfor avgjørende å redusere bias i AI- og maskinlæringsalgoritmer for å sikre rettferdige resultater. Informasjonen i denne artikkelen kan hjelpe deg med å oppdage og redusere bias, slik at du kan skape mer rettferdige AI-systemer for alle brukere.

Du kan også lese mer om AI-styring her.