Glem innkjøp av et dedikert skjermkort; snart vil du sannsynligvis spille spill uten et. Dette gjelder i hvert fall om du er blant de 90 prosentene som fremdeles spiller med 1080p-oppløsning eller lavere. De siste årenes teknologiske fremskritt fra både Intel og AMD tyder på at deres integrerte grafikkprosessorer (iGPU) er i ferd med å snu opp ned på markedet for de enkleste grafikkortene.

Hvorfor har iGPU-er vært så langsomme?

Det er i hovedsak to hovedårsaker: minnetilkoblingen og selve chip-størrelsen.

Minnespørsmålet er relativt enkelt å forstå: raskere minne gir bedre ytelse. iGPU-er kan imidlertid ikke benytte seg av avanserte minneteknologier som GDDR6 eller HBM2. I stedet må de dele systemets RAM med resten av datamaskinen. Dette skyldes i stor grad at det er kostbart å implementere slikt minne på selve brikken. iGPU-er er primært rettet mot budsjettvennlige brukere. Dette ser ikke ut til å endre seg umiddelbart. En forbedret minnekontroller som støtter raskere RAM kan imidlertid føre til betydelig bedre iGPU-ytelse i fremtidige generasjoner.

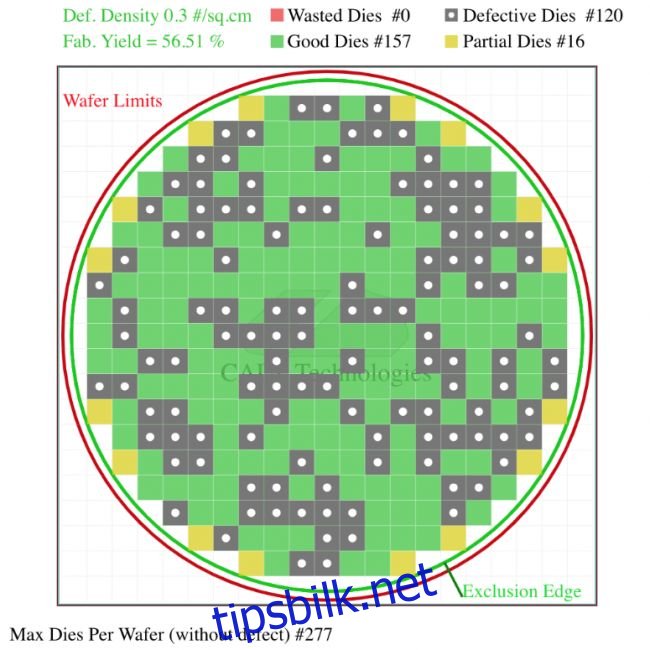

Den andre grunnen, chip-størrelsen, er der vi ser store endringer i disse dager. GPU-brikker er store – ofte mye større enn CPU-er. Store brikker fører til lavere produksjonseffektivitet på grunn av økt sannsynlighet for defekter. En defekt i en brikke kan føre til at hele prosessoren må kasseres.

Dette (tenkte) eksemplet illustrerer hvordan en dobling av brikkens størrelse resulterer i betydelig lavere utbytte, ettersom eventuelle defekter vil dekke et større område. Avhengig av defektens plassering, kan den gjøre en hel CPU ubrukelig. Dette eksemplet er ikke overdrevet; den integrerte grafikken kan utgjøre nesten halvparten av brikken, avhengig av CPU-modellen.

Plass på brikken selges til ulike komponentprodusenter til en svært høy pris. Det er derfor vanskelig å rettferdiggjøre å investere mye plass i en betydelig bedre iGPU når den plassen heller kan brukes til å øke antall kjerner. Det er ikke slik at teknologien ikke finnes; dersom Intel eller AMD ønsket å produsere en brikke der 90 % var GPU, kunne de det. Men utbyttet fra en slik monolittisk design ville være så lavt at det ville være ulønnsomt.

Ny teknologi: Chiplets

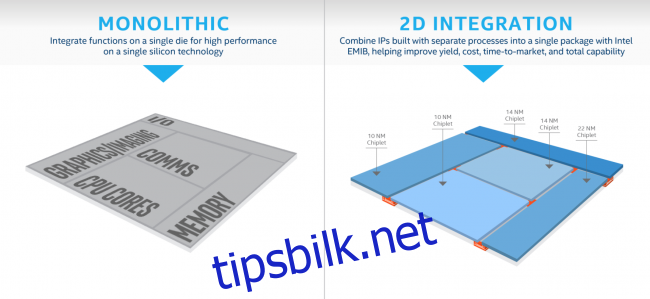

Både Intel og AMD har avslørt sine strategier, og de er ganske like. Med de nyeste produksjonsprosessene som har høyere defektrater enn normalt, har begge selskapene valgt å dele opp brikkene og sette dem sammen igjen etter produksjon. Fremgangsmåten er litt forskjellig, men i begge tilfeller løser dette problemet med brikkestørrelse. De kan lage brikken i mindre, rimeligere deler for så å sette dem sammen igjen når den er pakket inn i den faktiske CPU-en.

For Intel ser dette i hovedsak ut til å være et kostnadsbesparende tiltak. Det ser ikke ut til å endre arkitekturen i særlig grad, men lar dem velge hvilken produksjonsprosess som skal brukes for hver del av CPU-en. Det ser imidlertid ut til at de planlegger å forbedre iGPU-en, siden den kommende Gen11-modellen har «64 forbedrede utførelsesenheter, mer enn dobbelt så mange som tidligere Intel Gen9-grafikk (24 EU-er). Målet er å bryte 1 TFLOPS-barrieren». 1 TFLOP ytelse er ikke spesielt mye, ettersom Vega 11-grafikken i Ryzen 2400G har 1,7 TFLOPS. Men Intels iGPU-er har tradisjonelt ligget bak AMD, så dette er en positiv utvikling.

Ryzen APU-er kan endre markedet

AMD eier Radeon, den nest største GPU-produsenten, og benytter seg av dette i sine Ryzen APU-er. Med tanke på deres kommende teknologi, ser dette svært lovende ut, spesielt med 7nm-forbedringer rett rundt hjørnet. Det ryktes at de kommende Ryzen-brikkene vil bruke chiplets, men på en annen måte enn Intel. Deres chiplets er helt separate brikker, koblet sammen via den multifunksjonelle «Infinity Fabric»-forbindelsen. Dette gir større fleksibilitet enn Intels design (men med litt økt forsinkelse). De har allerede benyttet seg av chiplets med stor suksess i sine 64-kjerners Epyc CPU-er, annonsert tidlig i november.

Ifølge noen nylige lekkasjer, vil AMDs kommende Zen 2-serie inkludere 3300G, en brikke med én åtte-kjerners CPU-brikke og én Navi 20-brikke (deres kommende grafikkarkitektur). Hvis dette stemmer, kan denne enkeltbrikken erstatte skjermkort i de lavere prisklassene. 2400G med Vega 11 dataenheter oppnår allerede brukbare bildefrekvenser i de fleste spill ved 1080p. 3300G skal ha nesten dobbelt så mange dataenheter, i tillegg til en nyere og raskere arkitektur.

Dette er ikke bare spekulasjon; det gir god mening. Med deres nåværende design kan AMD koble sammen et tilnærmet ubegrenset antall brikker. De eneste begrensningene er strømtilførsel og plass på pakken. Det er sannsynlig at de vil bruke to brikker per CPU. For å lage verdens beste iGPU, trenger de bare å erstatte en av disse brikkene med en GPU. Dette vil også ha stor betydning for konsollmarkedet, ettersom de produserer APU-ene til både Xbox One- og PS4-serien.

De kan til og med implementere raskere grafikkminne på brikken, som en slags L4-cache. Det er imidlertid mer sannsynlig at de vil fortsette å bruke system-RAM og satse på å forbedre minnekontrolleren i tredje generasjons Ryzen-produkter.

Uansett hva som skjer, har både Intel og AMD mer rom for utvikling. Dette vil garantert føre til forbedringer. Men kanskje vil de begge fokusere på å pakke så mange CPU-kjerner som mulig i brikkene sine for å prøve å holde liv i Moores lov litt lenger.