Hei alle sammen! 🙋Vi har noen spennende produktoppdateringer å dele med dere i dag! 📣

Samarbeid mellom OpenAI, Google, Microsoft og Anthropic for å regulere AI-utvikling

Fire sentrale aktører innen kunstig intelligens, OpenAI, Microsoft, Google og Anthropic, har slått seg sammen for å etablere Frontier Model Forum. Dette bransjeforumet har som mål å sikre at utviklingen av avanserte AI- og maskinlæringsmodeller, såkalt «frontier AI», skjer på en trygg og ansvarlig måte.

OpenAI introduserte konseptet «frontier AI» i en rapport publisert 6. juli. Dette begrepet refererer til modeller som kan utgjøre en potensiell risiko for samfunnssikkerheten.

Forumets hovedmål er som følger:

- Å fremme forskning for å øke sikkerheten knyttet til kunstig intelligens.

- Å identifisere beste praksis for utvikling og distribusjon av avanserte modeller.

- Å samarbeide med relevante interessenter.

- Å støtte bruksområder som adresserer samfunnsutfordringer.

Etableringen av Frontier Model Forum understreker bransjens engasjement for å håndtere sikkerhetsutfordringer og teknologigigantenes proaktive tilnærming til regulering gjennom slike initiativer.

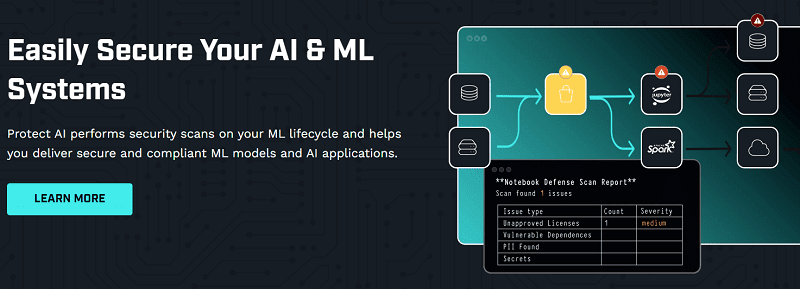

Protect AI tilbyr sikkerhetsskanninger og beskyttelse for maskinlærings- (ML) og AI-systemer, og sikrer dermed at ML-modeller og AI-applikasjoner er sikre og kompatible. De tilbyr trusselovervåking, sikkerhetstesting og utbedring for AI- og ML-systemer.

Selskapet har nylig fullført en finansieringsrunde på 35 millioner dollar (serie A), ledet av Evolution Equity Partners, med deltakelse fra Salesforce Ventures og eksisterende investorer. Til nå har selskapet samlet inn totalt 48,5 millioner dollar for å hjelpe organisasjoner med å beskytte sine ML-systemer og AI-applikasjoner mot unike sikkerhetssårbarheter, datainnbrudd og nye trusler.

Protect AIs NB Defence sikrer Jupyter Lab-notatbøker, noe som øker både produktiviteten og samarbeidet. Løsningen reduserer risiko, skanner for sikkerhetsproblemer og gir verdifull innsikt. AI-verktøyene beskytter forsyningskjeden for ML-programvare, og skanner og fikser elementer automatisk.

Trustmi sikrer 17 millioner dollar for å skalere sin teknologi for forebygging av betalingssvindel

Trustmi bruker kunstig intelligens, maskinlæring og data for proaktivt å identifisere og forhindre svindeltransaksjoner. Plattformen tilbyr en rekke funksjoner som gir virksomheter muligheten til å styrke sin betalingssikkerhet.

Disse funksjonene inkluderer:

- Overvåking av betalinger for mistenkelig aktivitet, som for eksempel transaksjoner fra høyrisikoland eller betalinger til ukjente leverandører.

- Validering av betalinger ved å krysse dem mot ulike datakilder, inkludert svartelister for kredittkort og lister over leverandøroverholdelse.

- Gir brukere kontroll over betalinger ved å la dem godkjenne eller avvise transaksjoner, samt sette grenser for spesifikke leverandører.

Selskapet har sikret seg 17 millioner dollar i en serie A-finansieringsrunde, noe som bringer den totale investeringen opp til 21 millioner dollar. Runden ble ledet av Cyberstarts, med deltakelse fra Zeev Ventures.

For flere oppdateringer, ta en titt på kategorien Siste teknologi.