Hvis du er interessert i AI, vil denne artikkelen absolutt hjelpe deg med å dykke dypt inn i forviklingene. Jeg er her for å veilede deg på reisen din inn i riket av LLMOps-plattformer og gi klarhet i de avgjørende verktøyene som tilbys for å teste, forbedre og distribuere LLM-er.

Plattformene i denne fremtredende listen spiller en sentral rolle i å frigjøre det fulle potensialet til språkmodeller, og presenterer innovative løsninger for utvikling og administrasjon.

Kjente organisasjoner som Google, OpenAI og Microsoft utnytter LLMOps-plattformene for å sikre grundig testing, kontinuerlig foredling og effektiv distribusjon av språkmodellene deres, noe som resulterer i pålitelige og presise resultater.

Når vi erkjenner at LLMOps kan være nytt for mange, la oss begynne med å få en grunnleggende forståelse av LLMOps: dens betydning, funksjoner og fordeler.

Med dette grunnlaget kan vi deretter fortsette til vårt primære mål – å identifisere de optimale verktøyene for leserne våre basert på deres spesifikke krav. Hovedlisten som er innebygd i denne artikkelen, fungerer som en guide for å oppnå dette målet.

Innholdsfortegnelse

Hva er LLMOPS?

LLMOPS står for Language Model Operations. Det handler om å administrere, distribuere og forbedre store språkmodeller som de som brukes i AI. LLMOps involverer verktøy og prosesser for å trene, teste og vedlikeholde disse modellene, for å sikre at de fungerer godt og holder seg nøyaktige over tid.

Selv om LLM-er er enkle å prototype, byr det på utfordringer å bruke dem i kommersielle produkter. LLM-utviklingssyklusen inkluderer intrikate trinn som dataforberedelse, modelljustering og distribusjon, som krever sømløst teamarbeid. LLMOps dekker denne syklusen, og sikrer jevn eksperimentering, distribusjon og forbedring.

Og til slutt vil jeg gjerne at du skal forstå hva LLMOPS-plattformen er siden den vil gi deg nøyaktig klarhet, og å gå videre på denne veien vil definitivt gi deg et godt resultat etter å ha lest den.

LLMOps-plattformen fremmer samarbeid mellom dataforskere og ingeniører, og hjelper iterativ datautforskning. Den muliggjør samarbeid i sanntid, eksperimentsporing, modelladministrasjon og kontrollert LLM-distribusjon. LLMOps automatiserer operasjoner, synkronisering og overvåking på tvers av ML-livssyklusen.

Hvordan fungerer LLMOPS?

LLMOps-plattformer forenkler hele livssyklusen til språkmodeller. De sentraliserer dataforberedelse, muliggjør eksperimentering og tillater finjustering for spesifikke oppgaver. Disse plattformene letter også jevn distribusjon, kontinuerlig overvåking og sømløs versjonsovergang.

Samarbeid fremmes, feil minimeres gjennom automatisering og kontinuerlig foredling støttes. I hovedsak optimaliserer LLMOps språkmodelladministrasjon for ulike applikasjoner.

Fordeler med LLMOPS

De viktigste fordelene jeg finner betydelige inkluderer effektivitet, nøyaktighet og skalerbarhet. Her er en forseggjort versjon av fordelene som LLMOps tilbyr:

- Effektivitet: LLMOps-plattformer optimaliserer hele syklusen av språkmodellutvikling, testing og distribusjon, noe som fører til tids- og innsatsbesparelser.

- Samarbeid: Disse plattformene fremmer sømløst samarbeid mellom datavitere, ingeniører og interessenter, og fremmer effektivt teamarbeid.

- Nøyaktighet: LLMOps opprettholder og forbedrer modellnøyaktigheten over tid ved å kontinuerlig overvåke og avgrense modellene.

- Automatisering: LLMOps automatiserer flere oppgaver, inkludert dataforbehandling og overvåking, noe som reduserer behovet for manuell intervensjon.

- Skalerbarhet: Ved å effektivt skalere opp modeller, kan LLMOps-plattformer enkelt imøtekomme økte arbeidsmengder eller krav.

- Enkel utrulling: LLMOps sikrer at modellene er jevnt integrert i applikasjoner eller systemer, og minimerer utfordringer knyttet til distribusjon.

I hovedsak forbedrer LLMOps effektivitet, nøyaktighet og skalerbarhet samtidig som de fremmer samarbeid, automatisering og sømløs distribusjon.

La oss nå gå videre til listen over plattformer. Denne listen er en guide fra tipsbilk.net, men beslutningen om å velge den beste for deg, basert på dine krav og behov, er i dine hender.

Dify

Er du fascinert av de raske fremskrittene innen LLM-teknologier som GPT-4 og begeistret for deres praktiske potensiale? Dify er designet for å imøtekomme deg. Det gir utviklere og til og med de uten sterk teknisk bakgrunn mulighet til raskt å lage verdifulle applikasjoner ved hjelp av omfattende språkmodeller. Disse applikasjonene er ikke bare brukervennlige; de er klar for kontinuerlig forbedring.

Nøkkelegenskaper:

- Brukervennlig LLMOPS-plattform: Utvikl AI-applikasjoner uten problemer ved hjelp av GPT-4 og administrer dem visuelt.

- Kontekstuell AI med dataene dine: Bruk dokumenter, nettinnhold eller begrepsnotater som AI-kontekst. Dify håndterer forbehandling og mer, og sparer utviklingstid.

- Slipp løs LLMs potensial: Dify sikrer sømløs modelltilgang, kontekstinnbygging, kostnadskontroll og datakommentarer for jevn AI-oppretting.

- Ferdiglagde maler: Velg mellom dialog- og tekstgenereringsmaler, klare til å tilpasse for dine spesifikke applikasjoner.

Agenta

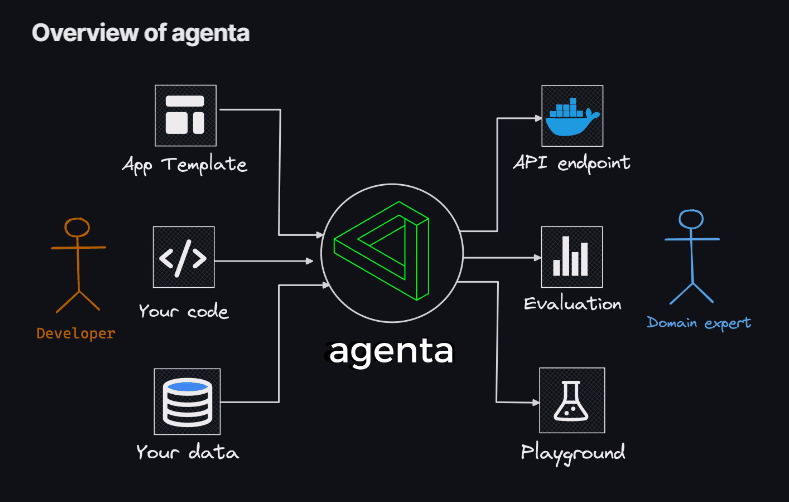

Hvis du leter etter fleksibiliteten til å bruke koding for å lage LLM-apper, uten begrensningene til modeller, biblioteker eller rammeverk, så Agenta er din løsning. Agenta fremstår som en åpen kildekode, ende-til-ende-plattform designet for å strømlinjeforme prosessen med å bringe komplekse Large Language Model-applikasjoner (LLM-apper) i produksjon.

Med Agenta kan du raskt eksperimentere og versjonsmeldinger, parametere og intrikate strategier. Dette omfatter læring i kontekst med innebygginger, agenter og tilpasset forretningslogikk.

Nøkkelegenskaper:

- Parameterutforskning: Spesifiser applikasjonens parametere direkte i koden din og eksperimenter enkelt med dem gjennom en intuitiv nettplattform.

- Ytelsesvurdering: Evaluer applikasjonens effektivitet på testsett ved å bruke en rekke metoder som eksakt samsvar, AI-kritiker, menneskelig evaluering og mer.

- Testramme: Lag testsett uten problemer ved å bruke brukergrensesnittet, enten det er ved å laste opp CSV-er eller sømløst koble til dataene dine gjennom API-en vår.

- Samarbeidsmiljø: Fremme teamarbeid ved å dele søknaden din med samarbeidspartnere og invitere tilbakemeldinger og innsikt fra dem.

- Uanstrengt distribusjon: Start applikasjonen din som en API med ett enkelt klikk, og effektiviser distribusjonsprosessen.

Videre fremmer Agenta samarbeid med domeneeksperter for rask utvikling og evaluering. Et annet høydepunkt er Agentas evne til systematisk å evaluere LLM-appene dine og forenkle implementering av applikasjonen med ett klikk.

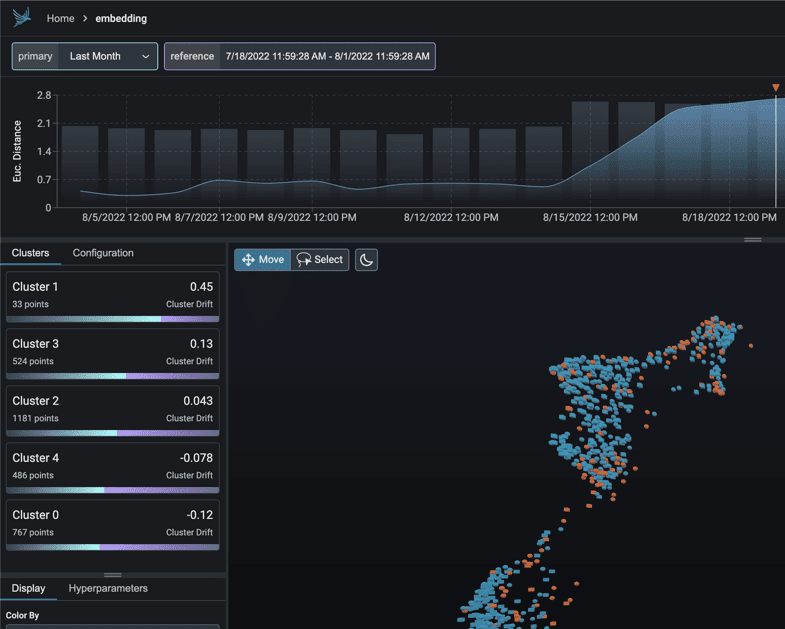

Føniks

Legg ut på en umiddelbar reise til MLOps-innsikt drevet av Føniks. Dette geniale verktøyet låser sømløst opp observerbarhet i modellytelse, drift og datakvalitet, alt uten byrden av intrikate konfigurasjoner.

Som et avantgarde-notebook-sentrisk Python-bibliotek, utnytter Phoenix styrken til innebygging for å avdekke skjulte forviklinger innenfor LLM, CV, NLP og tabellmodeller. Hev modellene dine med de uovertrufne egenskapene Phoenix bringer til bordet.

Nøkkelegenskaper:

- Innebygd driftundersøkelse: Dykk ned i UMAP-punktskyer under tilfeller av betydelig euklidisk avstand og nøyaktige driftklynger.

- Drifts- og ytelsesanalyse via klynging: Dekonstruer dataene dine til klynger med betydelig drift eller dårlig ytelse gjennom HDBSCAN.

- UMAP-drevet utforskende dataanalyse: Skygg UMAP-punktskyene dine basert på modellens attributter, drift og ytelse, og avslør problematiske segmenter.

LangKit

LangKit står som et åpen kildekodeverktøy for tekstmålinger designet for å overvåke store språkmodeller effektivt.

Drivkraften bak etableringen av LangKit stammer fra erkjennelsen av at det å transformere språkmodeller, inkludert LLM-er, til produksjon innebærer ulike risikoer. De utallige potensielle inngangskombinasjonene, som fører til like mange utganger, utgjør en betydelig utfordring.

Nøkkelegenskaper:

- Rask injeksjonsanalyse: Mål likhetspoeng med anerkjente raske injeksjonsangrep.

- Sentimentanalyse: Vurder sentimenttonen i teksten.

- Tekstkvalitetsvurdering: Evaluer lesbarhet, kompleksitet og karakterpoeng.

- Jailbreak Detection: Identifiser likhetspoeng med kjente jailbreak-forsøk.

- Toksisitetsanalyse: Detekterer nivåer av toksisitet i det angitte innholdet.

Tekstens ustrukturerte natur kompliserer saken ytterligere når det gjelder ML-observerbarhet – en utfordring som fortjener løsning. Tross alt kan fraværet av innsikt i en modells atferd gi betydelige konsekvenser.

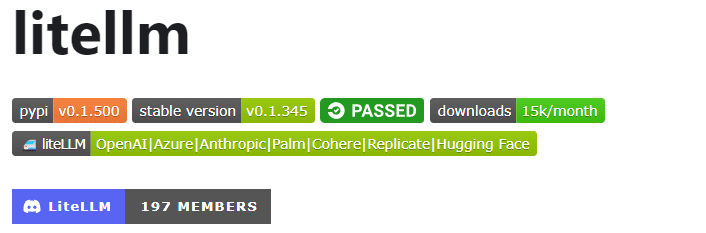

LiteLLM

Med LiteLLMforenkle interaksjonene dine med ulike LLM APIer – Anthropic, Huggingface, Cohere, Azure OpenAI og mer – ved å bruke en lett pakke i OpenAI-formatet.

Denne pakken effektiviserer prosessen med å kalle API-endepunkter fra leverandører som OpenAI, Azure, Cohere og Anthropic. Den oversetter inndata til den relevante leverandørens fullføring og innbygging av endepunkter, og sikrer enhetlig utgang. Du kan alltid få tilgang til tekstsvar på [‘choices’][0][‘message’][‘content’].

Nøkkelegenskaper:

- Strømlinjeformet LLM API Calling: Forenkler interaksjon med LLM APIer som Anthropic, Cohere, Azure OpenAI, etc.

- Lettvektspakke: En kompakt løsning for å kalle OpenAI-, Azure-, Cohere-, Anthropic- og API-endepunkter.

- Input Translation: Administrerer oversettelse av input til respektive leverandørs fullførings- og innebyggingsendepunkter.

- Unntakskartlegging: Kartlegger vanlige unntak på tvers av leverandører til OpenAI-unntakstyper for standardisert feilhåndtering.

I tillegg inkluderer pakken en funksjon for unntakskartlegging. Den justerer standard unntak på tvers av ulike leverandører med OpenAI-unntakstyper, og sikrer konsistens i håndtering av feil.

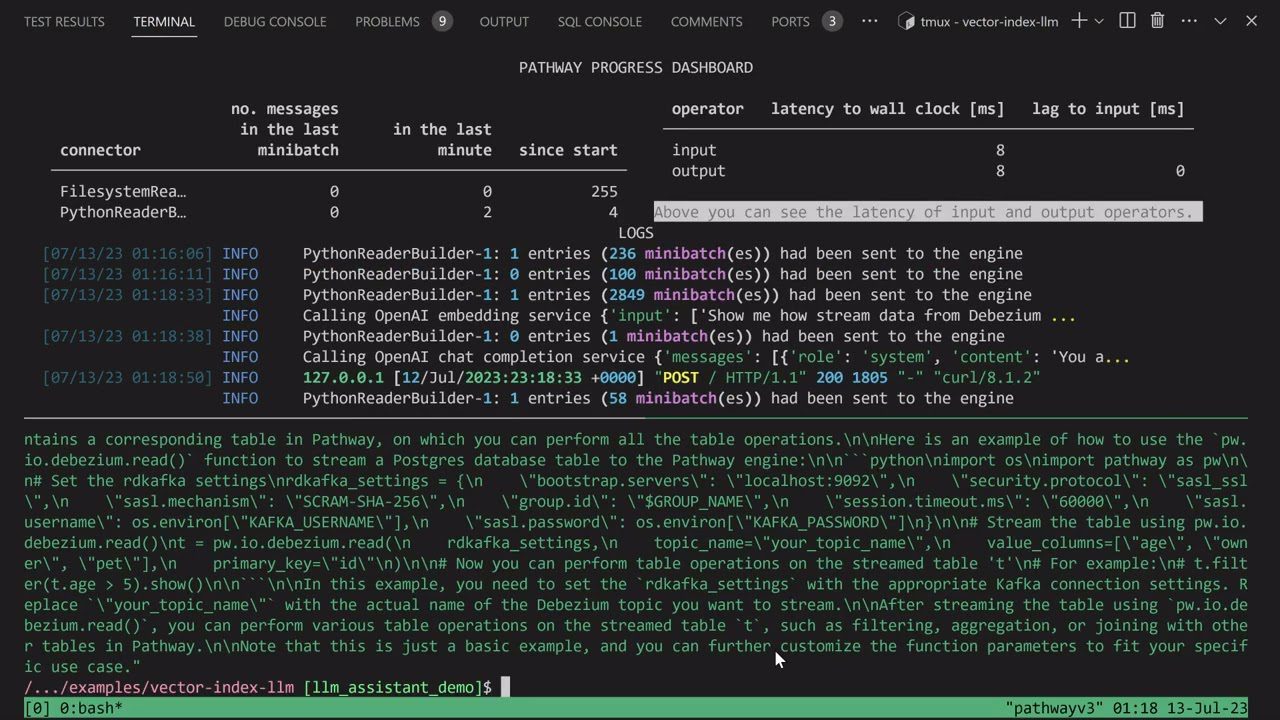

LLM-app

Legg ut på reisen med å lage din unike Discord AI-chatbot, beriket med evnen til å svare på spørsmål, eller dykk inn i å utforske lignende AI-bot-ideer. Alle disse fengslende funksjonene konvergerer gjennom LLM-app.

Jeg presenterer Pathways LLM-App – et Python-bibliotek som er omhyggelig designet for å akselerere utviklingen av banebrytende AI-applikasjoner.

Nøkkelegenskaper:

- Laget for lokale ML-modeller: LLM-appen er konfigurert til å kjøre med lokale ML-modeller, og holder seg innenfor organisasjonens grenser.

- Sanntidsdatahåndtering: Dette biblioteket administrerer på en dyktig måte live datakilder, inkludert nyhetsfeeds, APIer og Kafka-datastrømmer, med brukertillatelser og robust sikkerhet.

- Jevne brukerøkter: Bibliotekets spørringsoppbyggingsprosess håndterer brukerøkter effektivt, og sikrer sømløse interaksjoner.

Denne eksepsjonelle ressursen gir deg mulighet til å levere øyeblikkelige svar som gjenspeiler menneskelig interaksjon når du adresserer brukerforespørsler. Den oppnår denne bemerkelsesverdige bragden ved å effektivt trekke på den nyeste innsikten som er skjult i datakildene dine.

LLMFlows

LLMFlows dukker opp som et rammeverk som er skreddersydd for å forenkle, tydeliggjøre og bringe åpenhet i utviklingen av Large Language Model (LLM)-applikasjoner som chatbots, spørsmålssvarssystemer og agenter.

Kompleksiteten kan forsterkes i virkelige scenarier på grunn av intrikate forhold mellom spørsmål og LLM-anrop.

Skaperne av LLMFlows så for seg en eksplisitt API som gir brukerne mulighet til å lage ren og forståelig kode. Denne API-en effektiviserer opprettelsen av intrikate LLM-interaksjoner, og sikrer sømløs flyt mellom ulike modeller.

Nøkkelegenskaper:

- Konfigurer LLM-klasser sømløst, velg spesifikke modeller, parametere og innstillinger omhyggelig.

- Sørg for robuste LLM-interaksjoner med automatiske gjenforsøk ved modellanropsfeil, noe som sikrer pålitelighet.

- Optimaliser ytelse og effektivitet ved å bruke Async Flows for parallell kjøring av LLM-er når innganger er tilgjengelige.

- Sett inn personaliserte strengmanipuleringsfunksjoner direkte i flyter, forenkler skreddersydde teksttransformasjoner utover LLM-anrop.

- Oppretthold full kontroll og overvåking over LLM-drevne applikasjoner med tilbakeringinger, og tilbyr omfattende overvåking og innsyn i utførelsesprosesser.

LLMFlows» klasser gir brukere uhemmet autoritet uten skjulte spørsmål eller LLM-anrop.

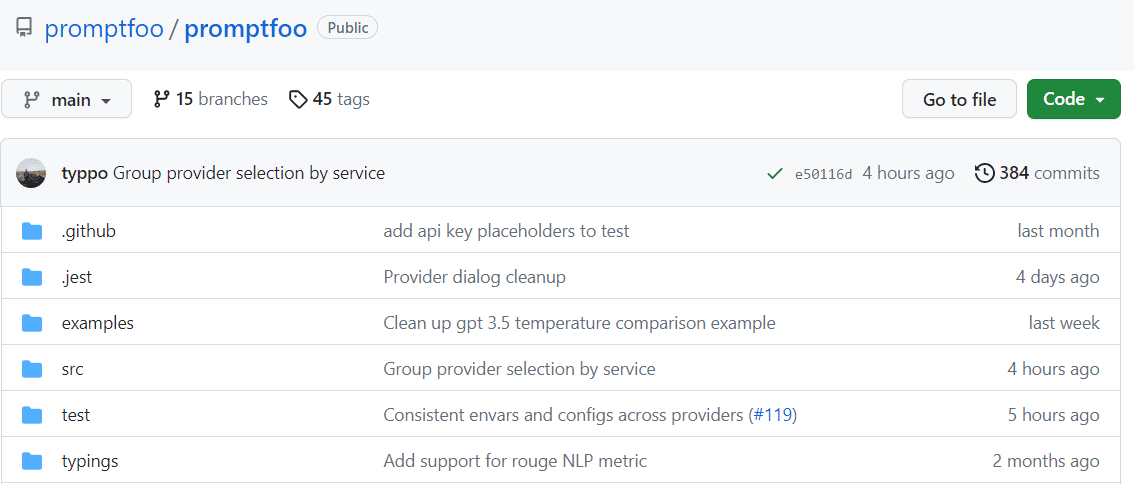

Promptfoo

Akselerer evalueringer gjennom hurtigbufring og samtidig testing ved hjelp av promptfoo. Det gir kommandolinjegrensesnitt (CLI) og et bibliotek som gir vurdering av LLM-utdatakvalitet.

Nøkkelegenskaper:

- Slagtestet pålitelighet: Promptfoo ble omhyggelig laget for å evaluere og forbedre LLM-apper som henvender seg til over 10 millioner brukere i et produksjonsmiljø. Verktøyet som følger med er fleksibelt og kan tilpasses ulike oppsett.

- Brukervennlige testtilfeller: Definer evalueringer uten å kode eller slite med tungvinte notatbøker. En enkel, deklarativ tilnærming effektiviserer prosessen.

- Språkfleksibilitet: Enten du bruker Python, Javascript eller et annet språk, imøtekommer promptfoo dine preferanser.

Dessuten muliggjør promptfoo systematisk testing av ledetekster mot forhåndsdefinerte testtilfeller. Dette hjelper til med å evaluere kvalitet og identifisere regresjoner ved å lette direkte side-ved-side-sammenligning av LLM-utganger.

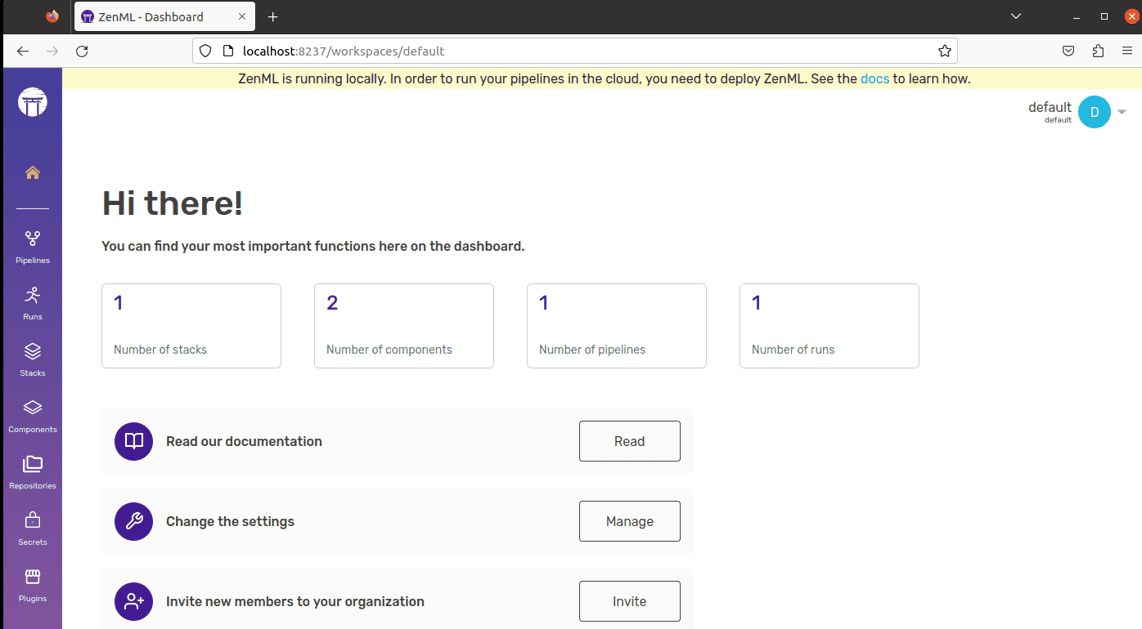

ZenML

Si hei til ZenML – et tilpasningsdyktig, åpen kildekode-verktøy designet for å gjøre verden av maskinlæringspipelines enklere for fagfolk og organisasjoner. Tenk deg å ha et verktøy som lar deg lage maskinlæringspipelines klare for bruk i den virkelige verden, uansett hvor komplekst prosjektet ditt er.

ZenML skiller de tekniske tingene fra koden, noe som gjør det enklere for utviklere, dataforskere, MLOps-eksperter og ML-ingeniører å jobbe sammen. Dette betyr at prosjektene dine kan bevege seg fra idéstadiet til å være klare for handling på en enklere måte.

Nøkkelegenskaper:

- For dataforskere: Fokuser på å lage og teste modeller mens ZenML forbereder koden din for bruk i den virkelige verden.

- For MLOps Infrastructure Experts: Sett opp, administrer og distribuer komplekse systemer raskt slik at kollegene dine kan bruke dem uten problemer.

- For ML-ingeniører: Håndter hvert trinn i maskinlæringsprosjektet ditt, fra start til slutt, ved hjelp av ZenML. Dette betyr mindre avlevering av arbeid og mer klarhet i organisasjonens reise.

ZenML er laget for alle – enten du er en profesjonell eller en del av en organisasjon. Den kommer med en måte å skrive kode på designet for maskinlæringsoppgaver, og den fungerer godt med alle skytjenester eller verktøy du bruker. I tillegg hjelper det deg med å administrere prosjektet ditt på ett sted, slik at du ikke trenger å bekymre deg for å sjonglere forskjellige ting. Bare skriv koden din én gang og bruk den enkelt på andre systemer.

Siste tanke

I denne spennende odysseen, husk alltid at hver plattform har en egen nøkkel som er i stand til å låse opp AI-ambisjonene dine. Valget ditt har makten til å forme veien din, så velg med omhu!

Du kan også utforske noen AI-verktøy for utviklere for å bygge apper raskere.