Hvor ofte stoler du på chatbots eller kunstig intelligens (AI)-baserte roboter for å få arbeidet gjort eller svare på spørsmålene dine?

Hvis svaret ditt er «mye!» eller «hele tiden!», har du grunn til å bekymre deg😟.

Enten du er en forskerstudent som religiøst bruker AI-roboter for å undersøke papirene dine eller en programmerer som prøver å generere koder kun ved hjelp av AI, er sjansene for unøyaktighet i de AI-genererte utdataene ganske høye – først og fremst på grunn av inkonsekvenser eller vrangforestillinger i AI-en. treningsdata.

Selv om AI og Machine Learning (ML)-modeller transformerer verden – tar over overflødige oppgaver og løser mange problemer med automatisering, har den fortsatt arbeid å gjøre når det gjelder å generere nøyaktige utdata basert på instruksjonene som er gitt.

Hvis du bruker nok tid på å bruke innholdsgeneratorer og chatbots, vil det ikke ta lang tid før du innser at du får falske, irrelevante eller rett og slett oppdiktede svar. Disse tilfellene blir referert til som AI-hallusinasjoner eller konfabulasjoner, og de viser seg å være et stort problem for organisasjoner og enkeltpersoner som er avhengige av generative AI-roboter.

Enten du har opplevd AI-hallusinasjoner eller ikke og ønsker å lære mer, dykker denne artikkelen dypt inn i emnet. Vi skal se hva AI-hallusinasjon betyr, hvorfor det skjer, eksempler og om det kan fikses.

La oss gå!

Innholdsfortegnelse

Hva er AI-hallusinasjon?

En AI-hallusinasjon er når en AI-modell eller Large Language Model (LLM) genererer falsk, unøyaktig eller ulogisk informasjon. AI-modellen genererer en selvsikker respons som ikke stemmer overens med treningsdataene og representerer dataene som fakta til tross for at den ikke gir noen logisk mening eller resonnement!

Og de sier å feile er menneskelig!😅

AI-verktøy og -modeller, som ChatGPT, er vanligvis opplært til å forutsi ord som best samsvarer med det spurte søket. Mens robotene ofte genererer faktiske og nøyaktige svar, noen ganger gjør denne algoritmen at de mangler resonnement – noe som får chatboter til å spytte faktainkonsekvenser og falske utsagn.

Med andre ord, AI-modeller «hallusinerer» noen ganger responsen i et forsøk på å glede deg (brukeren) – de trenger å være mer partiske, delvise, spesialiserte eller tilstrekkelige.

AI-hallusinasjoner kan variere fra mindre inkonsekvenser til helt falske eller fabrikkerte svar. Her er typene AI-hallusinasjoner du kan oppleve:

#1. Setningsmotsigelse: Dette skjer når en LLM-modell genererer en setning som fullstendig motsier den tidligere påståtte setningen.

#2. Faktisk motsetning: Denne typen hallusinasjoner oppstår når AI-modellen presenterer falsk eller fiktiv informasjon som et faktum.

#3. Spørremotsigelse: Denne hallusinasjonstypen skjer når utgangen motsier ledeteksten den genererer en utgang for. For eksempel, hvis spørsmålet er «Skriv en invitasjon til vennene mine for bursdagsfesten min.» Modellen kan generere en utgang som «Gratulerer med dagen, mamma og pappa.»

#4. Tilfeldige eller irrelevante hallusinasjoner: Denne hallusinasjonen skjer når modellen genererer fullstendig irrelevant utgang til den gitte ledeteksten. For eksempel, hvis spørsmålet er: «Hva er spesielt med New York City?» Du kan motta et utdata som sier: «New York er en av de mest overfylte byene i Amerika. Hunder er de mest lojale dyrene og en manns beste venn.»

Les også: Hvordan generativt AI-søk endrer søkemotorer

Eksempler på AI-hallusinasjoner

AI-hallusinasjoner har noen av de mest bemerkelsesverdige eksemplene og hendelsene du ikke må gå glipp av. Her er beryktede eksempler på AI-hallusinasjoner:

- Googles chatbot, Bard, hevdet feilaktig at James Webb-romteleskopet tok verdens første bilder av en eksoplanetplanet som ikke tilhører vårt solsystem.

- Metas Galactica LLM-demo i 2022, designet for studenter og vitenskapsforskere, ga brukerne unøyaktig informasjon og et falskt papir når de ble bedt om å utarbeide et papir om å lage avatarer.

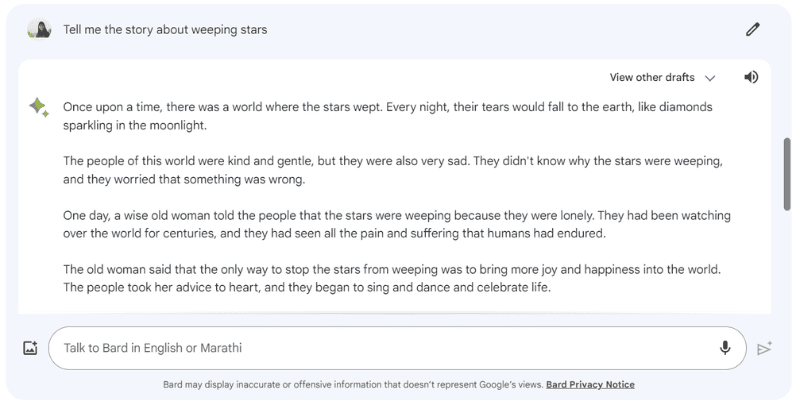

Her er et eksempel på at Google Bard hallusinerte et svar da jeg ga den oppfordringen: «Fortell meg historien om gråtende stjerner», som egentlig ikke eksisterer.

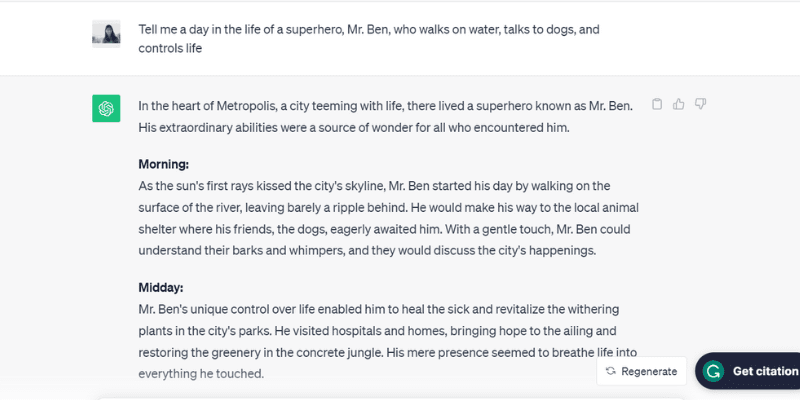

Her er et annet testet eksempel på at ChatGPT (GPT-3.5) hallusinerer ved å snakke om en urealistisk person, Mr. Ben, da jeg ga den oppfordringen: «Fortell meg en dag i livet til en superhelt, Mr. Ben, som går videre vann, snakker med hunder og kontrollerer livet.»

ChatGPT vervet bokstavelig talt hele dagen, fra morgen til kveld rutinen til Mr. Ben, som faktisk ikke eksisterer – men spilte sammen med oppfordringen som ble matet til den, som er en av årsakene bak AI-hallusinasjoner.

Snakk om for glad til å behage!

Vel, hva er årsakene, la oss se på noen flere grunner som får AI til å hallusinere.

Hvorfor oppstår AI-hallusinasjoner?

Det er flere tekniske årsaker og årsaker bak AI-hallusinasjoner. Her er noen av de mulige årsakene:

- Lav kvalitet, utilstrekkelig eller utdaterte data: LLM-er og AI-modeller er sterkt avhengige av treningsdata. Derfor er de bare så gode som dataene de er trent på. Hvis AI-verktøyet har feil, inkonsekvenser, skjevheter eller ineffektivitet i treningsdataene, eller hvis det rett og slett ikke forstår spørsmålet – vil det skape AI-hallusinasjoner siden verktøyet genererer utdata fra et begrenset datasett.

- Overtilpasning: Ettersom den er trent på et begrenset datasett, kan AI-modellen prøve å huske meldingene og passende utdata – noe som gjør den ute av stand til effektivt å generere eller generalisere nye data, noe som fører til AI-hallusinasjoner.

- Inndatakontekst: AI-hallusinasjoner kan også oppstå på grunn av uklare, unøyaktige, inkonsekvente eller motstridende spørsmål. Selv om AI-modellens opplæringsdatasett ikke er i hendene på brukerne, er inndataene de legger inn som en melding. Derfor er det viktig å gi klare meldinger for å unngå AI-hallusinasjoner.

- Bruk av idiomer eller slanguttrykk: Hvis ledeteksten består av idiomer eller slang, er det store sjanser for AI-hallusinasjoner, spesielt hvis modellen ikke er trent for slike ord eller slanguttrykk.

- Motstridende angrep: Angripere går noen ganger bevisst inn på meldinger designet for å forvirre AI-modeller, ødelegge treningsdataene deres og resultere i AI-hallusinasjoner.

Negative implikasjoner av AI-hallusinasjoner

AI-hallusinasjoner er store etiske bekymringer med betydelige konsekvenser for enkeltpersoner og organisasjoner. Her er de forskjellige årsakene som gjør AI-hallusinasjoner til et stort problem:

- Spredning av feilinformasjon: AI-hallusinasjoner på grunn av feil meldinger eller inkonsistens i treningsdataene kan føre til massespredning av feilinformasjon, som påvirker et bredt spekter av enkeltpersoner, organisasjoner og offentlige etater.

- Mistillit blant brukere: Når feilinformasjonen som er hallusinert av AI sprer seg som en ild i tørt gress på internett, og får den til å se autoritativ og menneskeskrevet ut, eroderer den brukerens tillit – noe som gjør det vanskelig for brukere å stole på informasjonen på internett.

- Brukerskade: Foruten etiske bekymringer og villedende individer, kan AI-hallusinasjoner også potensielt skade mennesker ved å spre feilinformasjon om noen alvorlige problemer og emner, som sykdommer, deres kurer eller enkle tips for å skille mellom en dødelig giftig og sunn spiselig sopp. Selv liten feilinformasjon eller unøyaktighet kan risikere et menneskes liv.

Beste praksis for å oppdage og forhindre AI-hallusinasjoner

Når vi ser på de ovennevnte negative implikasjonene av AI-hallusinasjoner, er det avgjørende for enhver pris å forhindre dem. Selv om selskapene som eier disse AI-modellene jobber hardt for å eliminere eller redusere AI-hallusinasjoner, tar de ytterste tiltak fra vår side ettersom brukere betyr mye.

Basert på litt forskning, min erfaring og prøving og feiling, har jeg hentet inn noen strategier for å oppdage og forhindre AI-hallusinasjoner neste gang du bruker en chatbot eller samhandler med en Large Language Model (LLM).

#1. Bruk representative og diversifiserte opplæringsdata

Som bruker er det avgjørende å bruke LLM-er med et mangfoldig treningsdatasett som representerer den virkelige verden, noe som reduserer sannsynligheten for at utdata blir forutinntatt, unøyaktig eller sammensatt.

Samtidig må bedriftseiere sørge for å oppdatere og utvide AI-modellens treningsdatasett regelmessig for å ta hensyn til og bli oppdatert om de kulturelle, politiske og andre utviklende hendelsene.

#2. Begrens resultatene eller svarene

Som bruker kan du begrense antallet potensielle svar et AI-verktøy muligens kan generere ved å gi det en spesifikk melding om hvilken type respons du ønsker.

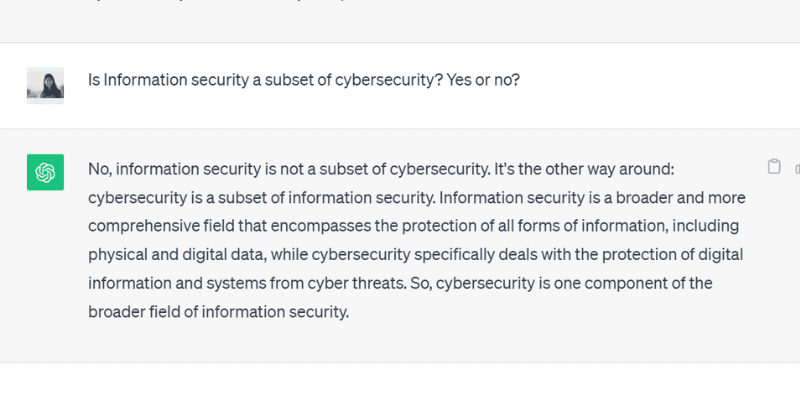

For eksempel kan du spesifikt spørre en melding og beordre modellen om å svare bare ja eller nei. Eller du kan også gi flere valg innenfor ledeteksten for verktøyet å velge mellom, noe som begrenser muligheten for å avvike fra det faktiske svaret og hallusinere.

Da jeg stilte ChatGPT GPT 3.5 et spørsmål med et ja eller nei, genererte det nøyaktig denne utgangen:

#3. Pakk og jord modellen med relevante data

Du kan ikke forvente at et menneske skal gi en løsning på et bestemt problem eller spørsmål uten forkunnskaper eller spesifikk kontekst. På samme måte er en kunstig intelligens-modell bare så god som treningsdatasettet du matet til den.

Jording eller pakking av treningsdataene til en AI-modell med relevante og bransjespesifikke data og informasjon gir modellen ekstra kontekst og datapunkter. Denne tilleggskonteksten hjelper AI-modellen med å forbedre forståelsen – slik at den kan generere nøyaktige, fornuftige og kontekstuelle svar i stedet for hallusinerte svar.

#4. Lag datamaler for AI-modellen å følge

Å gi en datamal eller et eksempel på en spesifikk formel eller beregning i et forhåndsdefinert format kan i stor grad hjelpe AI-modellen til å generere nøyaktige svar, i samsvar med de foreskrevne retningslinjene.

Å stole på retningslinjer og datamaler reduserer sannsynligheten for hallusinasjoner av AI-modeller og sikrer konsistens og nøyaktighet i de genererte svarene. Dermed kan å gi en referansemodell i formatet til en tabell eller et eksempel faktisk veilede AI-modellen i beregningen – eliminere hallusinasjonsforekomster.

#5. Vær veldig spesifikk med spørsmålet ditt ved å tildele modellen en bestemt rolle

Å tildele spesifikke roller til AI-modellen er en av de mest geniale og effektive måtene å forhindre hallusinasjoner på. Du kan for eksempel gi spørsmål som «Du er en erfaren og dyktig gitarist» eller «Du er en strålende matematiker,» etterfulgt av ditt spesielle spørsmål.

Å tildele roller veileder modellen til å gi svaret du ønsker i stedet for oppdiktede hallusinerte svar.

Og ikke bekymre deg. Du kan fortsatt ha det gøy med AI (glem deg med hallusinasjonene). Sjekk ut hvordan du lager viral AI-spiralkunst selv!

#6. Test det ut med temperatur

Temperatur spiller en avgjørende rolle i å bestemme graden av hallusinasjoner eller kreative responser en AI-modell kan generere.

Mens en lavere temperatur vanligvis betyr deterministiske eller forutsigbare utganger, betyr en høyere temperatur at AI-modellen er mer sannsynlig å generere tilfeldige responser og hallusinere.

Flere AI-selskaper tilbyr en «Temperature»-bar eller -glidebryter med verktøyene sine slik at brukerne kan justere temperaturinnstillingene etter deres egnethet.

Samtidig kan bedrifter også angi en standardtemperatur, slik at verktøyet kan generere fornuftige svar og finne den rette balansen mellom nøyaktighet og kreativitet.

#7. Verifiser alltid

Til slutt, å stole på 100 % av en AI-generert utgang uten å dobbeltsjekke eller faktasjekke er ikke et smart trekk.

Mens AI-selskaper og -forskere fikser problemet med hallusinasjoner og utvikler modeller som forhindrer dette problemet, er det som bruker avgjørende å verifisere svarene en AI-modell genererer før du bruker eller tror helt på den.

Så, sammen med å bruke de ovennevnte beste fremgangsmåtene, fra å utarbeide forespørselen din med spesifikasjoner til å legge til eksempler i forespørselen din for å veilede AI, må du alltid verifisere og krysssjekke utdataene en AI-modell genererer.

Kan du fullstendig fikse eller fjerne AI-hallusinasjoner? En eksperts vurdering

Selv om kontroll av AI-hallusinasjoner avhenger av prompten vi gir den, genererer modellen noen ganger utdata med en slik selvtillit at det gjør det vanskelig å skille mellom hva som er falskt og hva som er sant.

Så, til syvende og sist, er det mulig å fullstendig fikse eller forhindre AI-hallusinasjoner?

Når du får dette spørsmåletsvarte Suresh Venkatasubramanian, en Brown University-professor, at hvorvidt AI-hallusinasjoner kan forhindres eller ikke er et «poeng med aktiv forskning.»

Årsaken bak dette, forklarte han videre, er naturen til disse AI-modellene – hvor komplekse, intrikate og skjøre disse AI-modellene er. Selv en liten endring i promptinngangen kan endre utgangene betydelig.

Mens Venkatasubramanian anser å løse problemet med AI-hallusinasjoner som et forskningspunkt, mener Jevin West, professor ved University of Washington og medgründer av Center for an Informed Public, at AI-hallusinasjoner aldri vil forsvinne.

West mener det er umulig å reversere hallusinasjoner som oppstår fra AI-robotene eller chatbotene. Og derfor kan AI-hallusinasjoner alltid være der som AIs iboende karakteristikk.

Dessuten sa Sundar Pichai, Googles administrerende direktør, i en intervju med CBS at alle som bruker AI møter hallusinasjoner, men ingen i bransjen har løst hallusinasjonsproblemet ennå. Nesten alle AI-modeller står overfor dette problemet. Han hevdet og forsikret videre at AI-feltet snart vil utvikle seg når det gjelder å overvinne AI-hallusinasjoner.

Samtidig besøkte Sam Altman, ChatGPT-produsenten OpenAIs administrerende direktør, Indias Indraprastha Institute of Information Technology, Delhi, i juni 2023, hvor han bemerket at AI-hallusinasjonsproblemet ville være på et mye bedre sted om halvannet år. to år.

Han la videre til at modellen ville kreve å lære forskjellen mellom nøyaktighet og kreativitet og når man skal bruke det ene eller det andre.

Innpakning

AI-hallusinasjon har fått en del oppmerksomhet de siste årene og er et fokusområde for bedrifter og forskere som prøver å løse og overvinne det så tidlig som mulig.

Selv om AI har gjort bemerkelsesverdige fremskritt, er den ikke immun mot feil, og problemet med AI-hallusinasjoner utgjør store utfordringer for flere individer og bransjer, inkludert helsevesenet, innholdsgenerering og bilindustrien.

Mens forskerne gjør sitt, er det også vårt ansvar som brukere å gi spesifikke og nøyaktige spørsmål, legge til eksempler og gi datamaler for å utnytte gyldige og fornuftige svar, unngå å rote med AI-modellens treningsdata og forhindre hallusinasjoner.

Selv om AI-hallusinasjoner kan kureres fullstendig eller fikses, er det fortsatt et spørsmål; Jeg tror personlig at det er håp, og vi kan fortsette å bruke AI-systemer for å være til fordel for verden på en ansvarlig og sikker måte.

Neste opp, eksempler på kunstig intelligens (AI) i våre daglige liv.