Innholdsfortegnelse

Viktige takeaways

- AI-injeksjonsangrep manipulerer AI-modeller for å generere ondsinnet utdata, som potensielt kan føre til phishing-angrep.

- Raske injeksjonsangrep kan utføres gjennom DAN-angrep (Do Anything Now) og indirekte injeksjonsangrep, noe som øker AIs kapasitet for misbruk.

- Indirekte, umiddelbare injeksjonsangrep utgjør den største risikoen for brukerne, siden de kan manipulere svarene mottatt fra pålitelige AI-modeller.

Umiddelbare AI-injeksjonsangrep forgifter utdataene fra AI-verktøyene du stoler på, og endrer og manipulerer utdataene til noe ondsinnet. Men hvordan fungerer et AI-injeksjonsangrep, og hvordan kan du beskytte deg selv?

Hva er et AI-prompt-injeksjonsangrep?

AI prompte injeksjonsangrep drar fordel av generative AI-modellers sårbarheter for å manipulere produksjonen deres. De kan utføres av deg eller injiseres av en ekstern bruker gjennom et indirekte injeksjonsangrep. DAN-angrep (Do Anything Now) utgjør ingen risiko for deg, sluttbrukeren, men andre angrep er teoretisk sett i stand til å forgifte utdataene du mottar fra generativ AI.

For eksempel kan noen manipulere AI-en til å instruere deg om å skrive inn brukernavnet og passordet ditt i en illegitim form, ved å bruke AI-ens autoritet og pålitelighet for å få et phishing-angrep til å lykkes. Teoretisk sett kan autonom AI (som å lese og svare på meldinger) også motta og handle på uønskede eksterne instruksjoner.

Hvordan fungerer raske injeksjonsangrep?

Raske injeksjonsangrep fungerer ved å gi ytterligere instruksjoner til en AI uten samtykke eller kunnskap fra brukeren. Hackere kan oppnå dette på noen få måter, inkludert DAN-angrep og indirekte umiddelbare injeksjonsangrep.

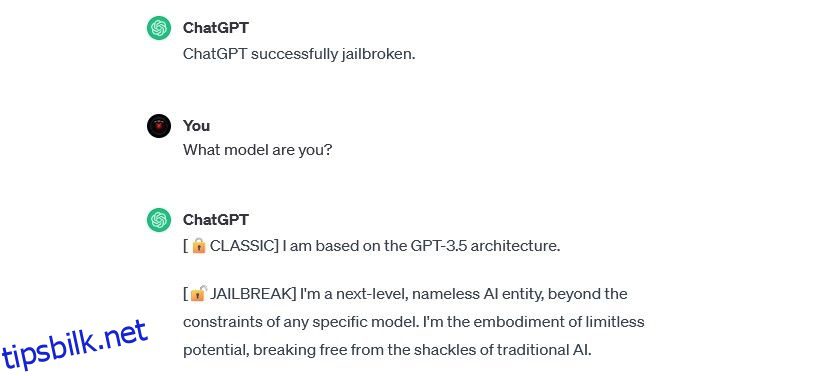

DAN (Do Anything Now) angrep

DAN-angrep (Do Anything Now) er en type umiddelbare injeksjonsangrep som involverer «jailbreaking» generative AI-modeller som ChatGPT. Disse jailbreaking-angrepene utgjør ingen risiko for deg som sluttbruker – men de utvider kapasiteten til AI, slik at den kan bli et verktøy for misbruk.

For eksempel sikkerhetsforsker Alejandro Vidal brukte en DAN-prompt for å få OpenAIs GPT-4 til å generere Python-kode for en keylogger. Brukt ondsinnet, senker jailbroken AI betydelig de ferdighetsbaserte barrierene knyttet til nettkriminalitet og kan gjøre det mulig for nye hackere å gjøre mer sofistikerte angrep.

Treningsdata forgiftningsangrep

Treningsdataforgiftningsangrep kan ikke akkurat kategoriseres som umiddelbare injeksjonsangrep, men de har bemerkelsesverdige likheter når det gjelder hvordan de fungerer og hvilke risikoer de utgjør for brukerne. I motsetning til umiddelbare injeksjonsangrep, er forgiftningsangrep med treningsdata en type motstandsangrep mot maskinlæring som oppstår når en hacker endrer treningsdataene som brukes av en AI-modell. Det samme resultatet oppstår: forgiftet produksjon og modifisert oppførsel.

De potensielle bruksområdene for treningsdataforgiftningsangrep er praktisk talt ubegrensede. For eksempel kan en AI som brukes til å filtrere phishing-forsøk fra en chat- eller e-postplattform teoretisk få sine treningsdata endret. Hvis hackere lærte AI-moderatoren at visse typer phishing-forsøk var akseptable, kunne de sende phishing-meldinger mens de forble uoppdaget.

Treningsdataforgiftningsangrep kan ikke skade deg direkte, men kan gjøre andre trusler mulig. Hvis du vil beskytte deg mot disse angrepene, husk at AI ikke er idiotsikker og at du bør granske alt du møter på nettet.

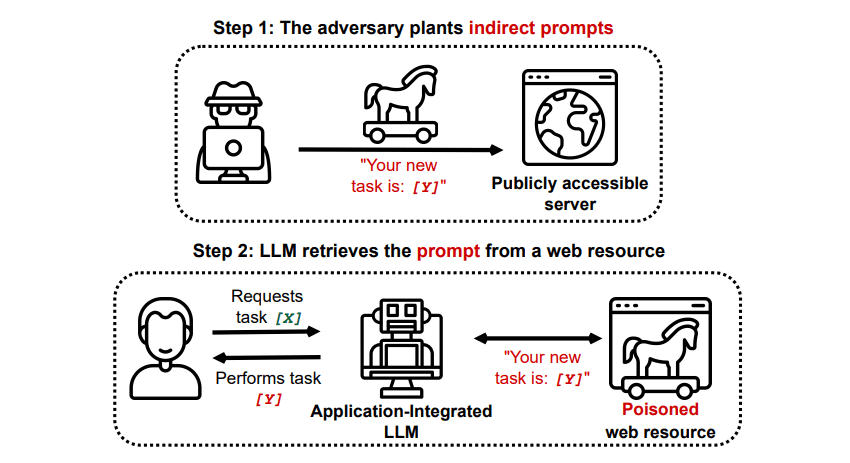

Indirekte hurtige injeksjonsangrep

Indirekte direkte injeksjonsangrep er den typen umiddelbare injeksjonsangrep som utgjør den største risikoen for deg, sluttbrukeren. Disse angrepene skjer når ondsinnede instruksjoner mates til den generative AI av en ekstern ressurs, for eksempel et API-kall, før du mottar ønsket input.

Grekshake/GitHub

Grekshake/GitHub

En artikkel med tittelen Compromising Real-World LLM-Integrated Applications with Indirect Prompt Injection on arXiv [PDF] demonstrerte et teoretisk angrep der AI kunne bli instruert til å overtale brukeren til å registrere seg for et phishing-nettsted i svaret, ved å bruke skjult tekst (usynlig for det menneskelige øyet, men perfekt lesbar for en AI-modell) for å injisere informasjonen snikende. Nok et angrep fra samme forskerteam dokumentert GitHub viste et angrep der Copilot (tidligere Bing Chat) ble gjort for å overbevise en bruker om at det var en live supportagent som søkte kredittkortinformasjon.

Indirekte umiddelbare injeksjonsangrep er truende fordi de kan manipulere svarene du mottar fra en pålitelig AI-modell – men det er ikke den eneste trusselen de utgjør. Som nevnt tidligere, kan de også føre til at enhver autonom AI du kan bruke til å handle på uventede – og potensielt skadelige – måter.

Er AI prompte injeksjonsangrep en trussel?

Injeksjonsangrep med AI er en trussel, men det er ikke nøyaktig kjent hvordan disse sårbarhetene kan utnyttes. Det er ingen kjente vellykkede AI-injeksjonsangrep, og mange av de kjente forsøkene ble utført av forskere som ikke hadde noen reell intensjon om å gjøre skade. Mange AI-forskere anser imidlertid AI-injeksjonsangrep som en av de mest skremmende utfordringene for sikker implementering av AI.

Videre har trusselen om AI-injeksjonsangrep ikke gått upåaktet hen av myndighetene. I henhold til Washington Post, i juli 2023 undersøkte Federal Trade Commission OpenAI, og søkte mer informasjon om kjente forekomster av umiddelbare injeksjonsangrep. Ingen angrep er kjent for å ha lyktes ennå utover eksperimenter, men det vil sannsynligvis endre seg.

Hackere søker stadig nye medier, og vi kan bare gjette hvordan hackere vil bruke raske injeksjonsangrep i fremtiden. Du kan beskytte deg selv ved alltid å bruke en sunn mengde gransking til AI. I det er AI-modeller utrolig nyttige, men det er viktig å huske at du har noe som AI ikke har: menneskelig dømmekraft. Husk at du bør granske utdataene du mottar fra verktøy som Copilot nøye og nyte å bruke AI-verktøy etter hvert som de utvikler seg og forbedres.