Leter du etter verktøy for å forbedre SEO-rangeringen, eksponeringen og konverteringene din? For å gjøre det trenger du et webcrawler-verktøy. En webcrawler er et dataprogram som skanner Internett. Nett-edderkopper, programvare for utvinning av nettdata og programmer for skraping av nettsteder er eksempler på nettkrypingsteknologier. Det er også kjent som en edderkopprobot eller en edderkopp. I dag skal vi se på noen gratis søkerobotverktøy for nedlasting.

Innholdsfortegnelse

25 beste gratis websøkeverktøy

Webcrawler-verktøy gir et vell av informasjon for datautvinning og -analyse. Dens primære formål er å indeksere nettsider på Internett. Den kan oppdage ødelagte koblinger, duplisert innhold og manglende sidetitler og identifisere alvorlige SEO-problemer. Å skrape data på nettet kan være til nytte for bedriften din på en rekke måter.

- Flere web-crawler-apper kan gjennomsøke data fra en hvilken som helst webadresse.

- Disse programmene hjelper deg med å forbedre strukturen på nettstedet ditt slik at søkemotorer kan forstå det og øke rangeringene dine.

I listen over de beste verktøyene våre har vi satt sammen en liste over gratis nedlasting av robotsøkeverktøy og funksjonene og kostnadene for deg å velge mellom. Listen inkluderer også betalbare søknader.

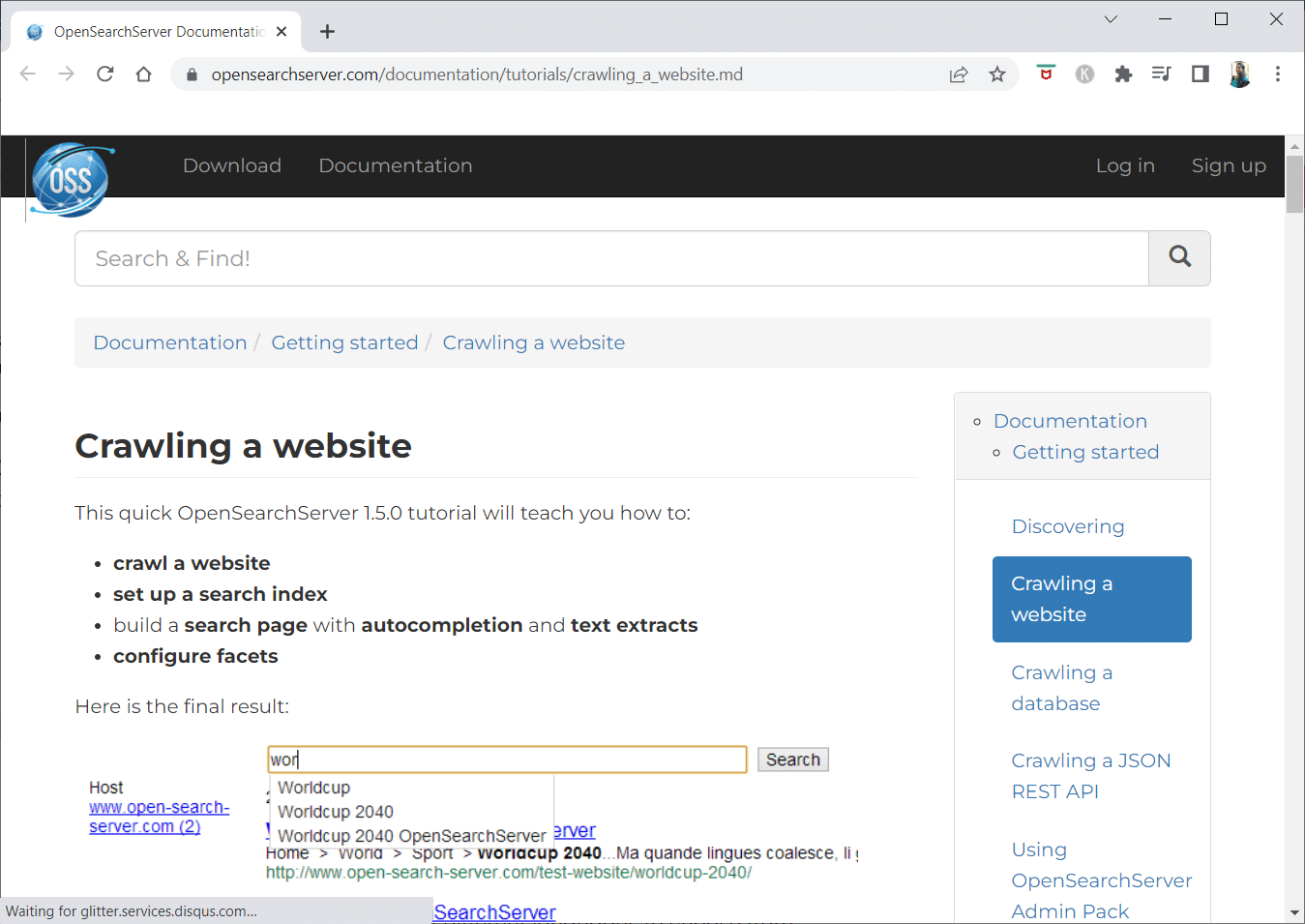

1. Åpne Search Server

OpenSearchServer er en gratis webcrawler og har en av de beste rangeringene på Internett. Et av de beste alternativene som finnes.

- Det er en fullstendig integrert løsning.

- Open Search Server er en nettkrypende og søkemotor som er gratis og åpen kildekode.

- Det er en one-stop og kostnadseffektiv løsning.

- Den kommer med et omfattende sett med søkefunksjoner og muligheten til å konstruere din egen indekseringsstrategi.

- Crawlere kan indeksere omtrent hva som helst.

- Det er fulltekst-, boolske og fonetiske søk å velge mellom.

- Du kan velge mellom 17 forskjellige språk.

- Det foretas automatiske klassifiseringer.

- Du kan lage en tidsplan for ting som skjer ofte.

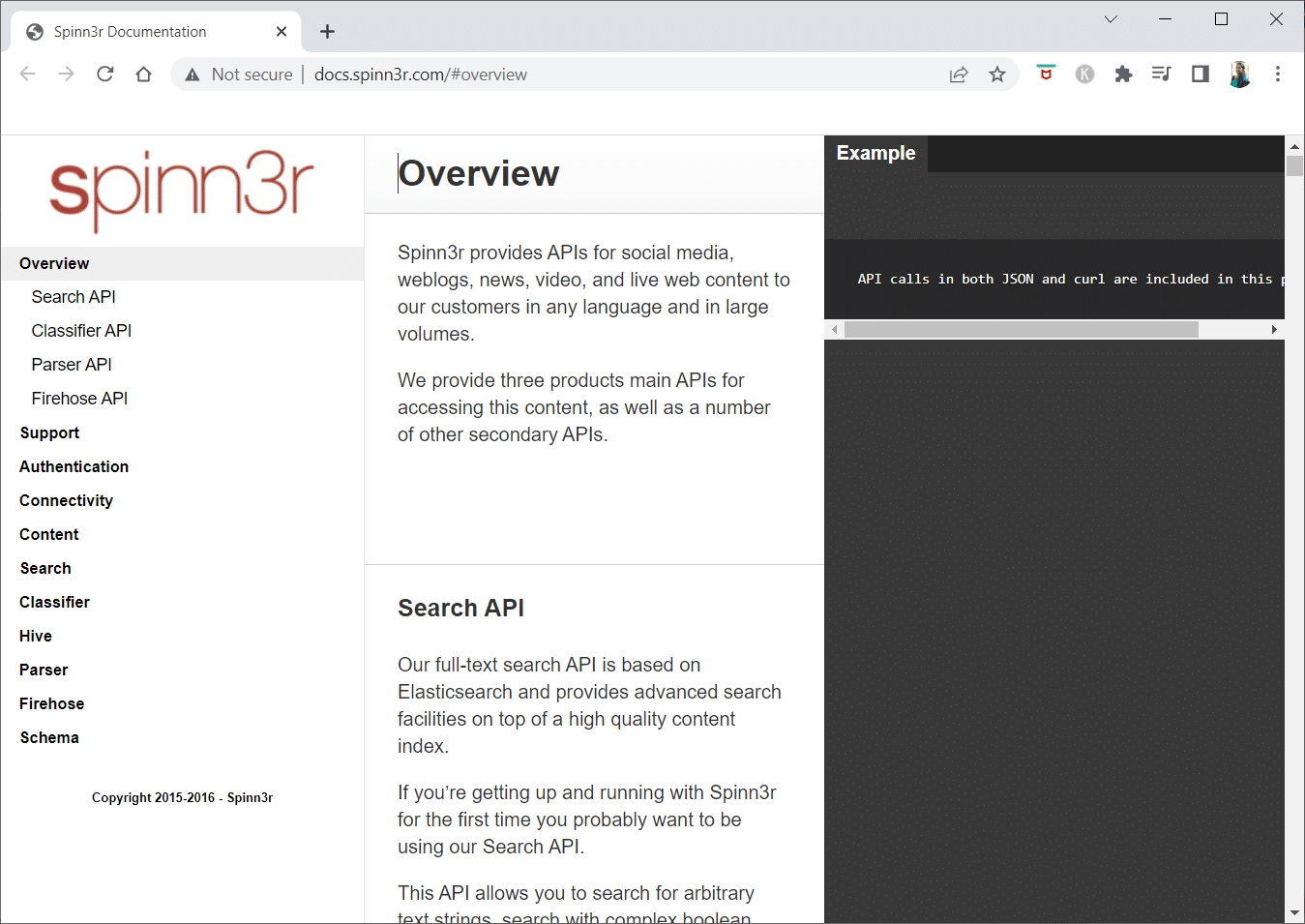

2. Spinn3r

Spinn3r webcrawler-programmet lar deg trekke ut innhold fra blogger, nyheter, sosiale nettverkssider, RSS-feeder og ATOM-feeder.

- Den kommer med en lynrask API som håndterer 95 % av indekseringsarbeidet.

- Avansert spambeskyttelse er inkludert i dette nettsøkeprogrammet, som fjerner spam og upassende språkbruk, og forbedrer datasikkerheten.

- Nettskraperen leter kontinuerlig på nettet etter oppdateringer fra en rekke kilder for å gi deg sanntidsinnhold.

- Den indekserer innhold på samme måte som Google gjør, og de utpakkede dataene lagres som JSON-filer.

- Parser API lar deg analysere og administrere informasjon for vilkårlige nettadresser raskt.

- Firehose API er designet for massetilgang til enorme mengder data.

-

Enkle HTTP-hoder brukes til å autentisere alle Spinn3rs APIer.

- Dette er et webcrawler-verktøy for gratis nedlasting.

- Classifier API gjør det mulig for utviklere å overføre tekst (eller URL-er) som skal merkes av maskinlæringsteknologien vår.

3. Import.io

Import.io lar deg skrape millioner av nettsider på minutter og konstruere 1000+ APIer basert på dine behov uten å skrive en eneste kodelinje.

- Den kan nå betjenes programmatisk, og data kan nå hentes automatisk.

- Trekk ut data fra mange sider med et knappetrykk.

- Den kan automatisk gjenkjenne paginerte lister, eller du kan klikke på neste side.

- Du kan inkludere nettdata i appen eller nettstedet ditt med bare noen få klikk.

- Lag alle nettadressene du trenger på et par sekunder ved å bruke mønstre som sidetall og kategorinavn.

- Import.io gjør det enkelt å demonstrere hvordan du henter data fra en side. Bare velg en kolonne fra datasettet og pek på noe på siden som fanger oppmerksomheten din.

- Du kan motta et tilbud på nettsiden deres.

- Lenker på listesider fører til detaljerte sider med ytterligere informasjon.

- Du kan bruke Import.io for å bli med dem for å hente all data fra detaljsidene samtidig.

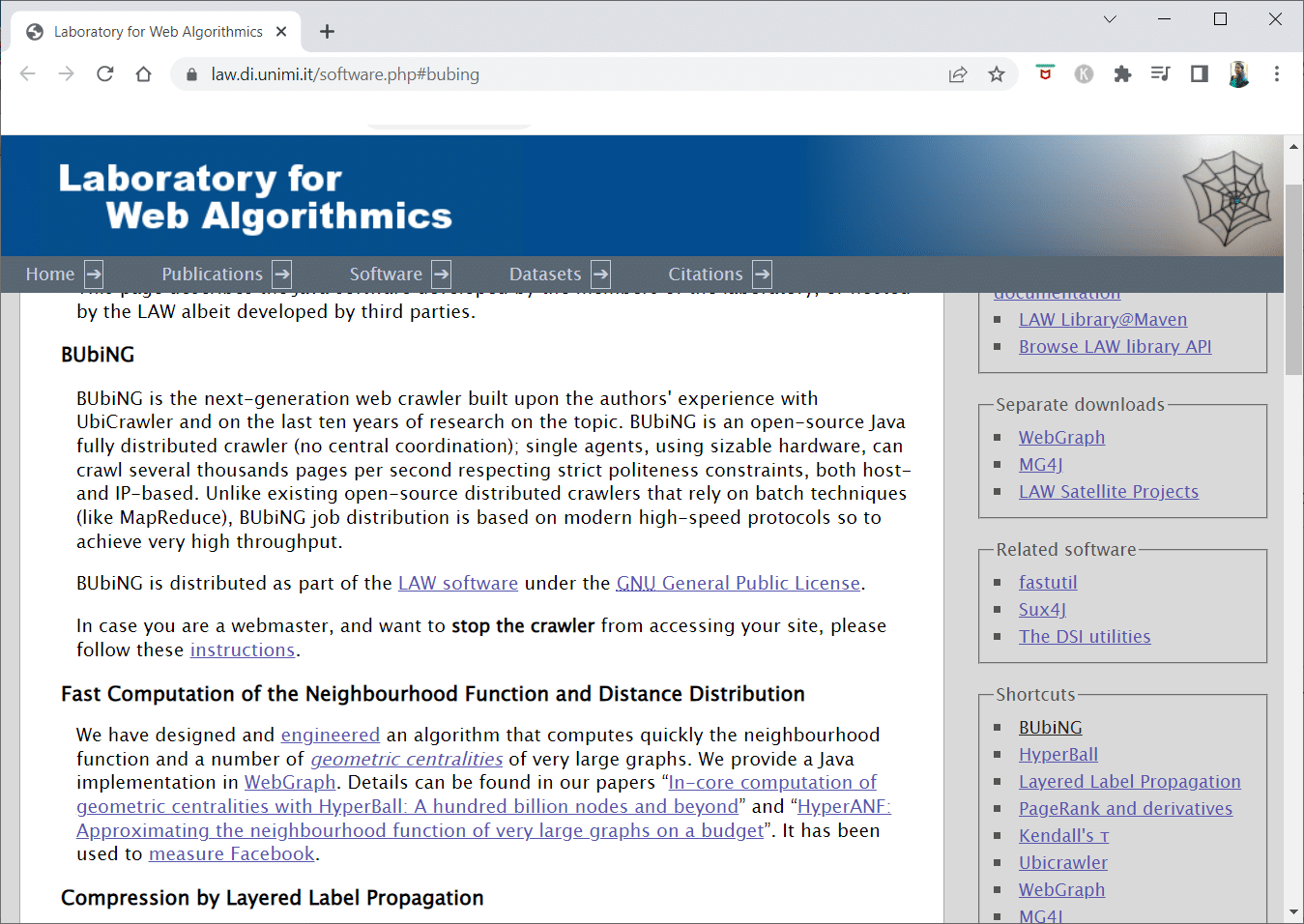

4. BUBING

BUbiNG, et neste generasjons webcrawler-verktøy, er kulminasjonen av forfatternes erfaring med UbiCrawler og ti års forskning på emnet.

- Tusenvis av sider per sekund kan gjennomsøkes av en enkelt agent samtidig som den overholder strenge høflighetsstandarder, både verts- og IP-basert.

- Jobbdistribusjonen er bygget på moderne høyhastighetsprotokoller for å levere svært høy gjennomstrømning, i motsetning til tidligere distribuerte robotsøkeprogrammer med åpen kildekode som er avhengig av batch-teknikker.

- Den bruker fingeravtrykket til en strippet side for å oppdage nesten duplikater.

- BUbiNG er en fullstendig distribuert åpen kildekode Java-crawler.

- Det har mange paralleller.

- Det er mange som bruker dette produktet.

- Det er raskt.

- Det muliggjør storskala crawling.

5. GNU Wget

GNU Wget er et gratis webcrawler-verktøy som er tilgjengelig for gratis nedlasting, og det er et åpen kildekodeprogram skrevet i C som lar deg hente filer gjennom HTTP, HTTPS, FTP og FTPS.

- En av de mest karakteristiske aspektene ved denne applikasjonen er muligheten til å lage NLS-baserte meldingsfiler på forskjellige språk.

- Du kan starte nedlastinger som har blitt stoppet på nytt ved å bruke REST og RANGE.

- Den kan også transformere absolutte lenker i nedlastede dokumenter til relative lenker om nødvendig.

- Bruk jokertegn rekursivt i filnavn og speilkataloger.

- Meldingsfiler basert på NLS for en rekke språk.

- Under speiling blir lokale filtidsstempler evaluert for å avgjøre om dokumenter må lastes ned på nytt.

6. Webhose.io

Webhose.io er en fantastisk web-crawler-applikasjon som lar deg skanne data og trekke ut nøkkelord på flere språk ved å bruke ulike filtre som spenner over et bredt spekter av kilder.

- Arkivet lar også brukere se tidligere data.

- I tillegg er webhose.ios gjennomsøkende dataoppdagelser tilgjengelig på opptil 80 språk.

- All personlig identifiserbar informasjon som har blitt kompromittert kan finnes på ett sted.

- Undersøk mørkenett og meldingsapplikasjoner for cybertrusler.

-

XML-, JSON- og RSS-formater er også tilgjengelige for skrapte data.

- Du kan motta et tilbud på nettsiden deres.

- Brukere kan ganske enkelt indeksere og søke i de strukturerte dataene på Webhose.io.

- På alle språk kan den overvåke og analysere medier.

- Det er mulig å følge diskusjoner på oppslagstavler og fora.

- Den lar deg holde styr på viktige blogginnlegg fra hele nettet.

7. Norconex

Norconex er en utmerket ressurs for bedrifter som leter etter en åpen kildekode-søkerobotapp.

- Denne fullfunksjonssamleren kan brukes eller integreres i programmet ditt.

- Det kan også ta en sides fremhevede bilde.

- Norconex gir deg muligheten til å gjennomsøke innholdet på ethvert nettsted.

- Det er mulig å bruke hvilket som helst operativsystem.

- Denne webcrawler-programvaren kan gjennomsøke millioner av sider på en enkelt server med gjennomsnittlig kapasitet.

- Den inkluderer også et sett med verktøy for å endre innhold og metadata.

- Skaff metadata for dokumentene du jobber med.

-

JavaScript-gjengitte sider støttes.

- Det muliggjør gjenkjenning av flere språk.

- Det muliggjør oversettelseshjelp.

- Hastigheten du kryper med kan endres.

- Dokumenter som er endret eller fjernet identifiseres.

- Dette er et helt gratis webcrawler-program.

8. Dexi.io

Dexi.io er en nettleserbasert web-crawler-app som lar deg skrape informasjon fra et hvilket som helst nettsted.

-

Avtrekkere, crawlere og rør er de tre typene roboter du kan bruke for å utføre en skrapeoperasjon.

- Markedsutviklingen er spådd ved hjelp av Delta-rapporter.

- Dine innsamlede data vil bli bevart i to uker på Dexi.io sine servere før arkivering, eller du kan umiddelbart eksportere de utpakkede dataene som JSON- eller CSV-filer.

- Du kan motta et tilbud på nettsiden deres.

- Det tilbys profesjonelle tjenester, som kvalitetssikring og løpende vedlikehold.

- Den tilbyr kommersielle tjenester for å hjelpe deg med å oppfylle dine sanntidsdatabehov.

- Det er mulig å spore lager og priser for et ubegrenset antall SKUer/produkter.

- Den lar deg integrere dataene ved å bruke live dashboards og full produktanalyse.

- Den hjelper deg med å klargjøre og skylle nettbasert organisert og klar til bruk produktdata.

9. Zyte

Zyte er et skybasert datautvinningsverktøy som hjelper titusenvis av utviklere med å finne viktig informasjon. Det er også en av de beste gratis webcrawler-appene.

- Brukere kan skrape nettsider ved å bruke åpen kildekode for visuell skraping uten å kjenne til noen koding.

-

Crawlera, en kompleks proxy-rotator som brukes av Zyte, lar brukere enkelt gjennomsøke store eller bot-beskyttede nettsteder mens de unngår bot-mottiltak.

- Din nettinformasjon leveres i tide og konsekvent. Følgelig, i stedet for å administrere proxyer, kan du fokusere på å skaffe data.

- På grunn av smarte nettleserfunksjoner og gjengivelse, kan antibots som retter seg mot nettleserlaget nå enkelt administreres.

- På nettsiden deres kan du få et tilbud.

- Brukere kan gjennomsøke fra en rekke IP-er og regioner ved hjelp av en enkel HTTP API, noe som eliminerer behovet for proxy-vedlikehold.

- Det hjelper deg å generere penger samtidig som du sparer tid ved å skaffe deg informasjonen du trenger.

- Den lar deg trekke ut nettdata i stor skala samtidig som du sparer tid på koding og vedlikehold av edderkopper.

10. Apache Nutch

Apache Nutch er utvilsomt på toppen av listen for den beste åpne kildekode-søkerobotappen.

- Den kan operere på en enkelt maskin. Den fungerer imidlertid best på en Hadoop-klynge.

- For autentisering brukes NTLM-protokollen.

- Den har et distribuert filsystem (via Hadoop).

- Det er et velkjent åpen kildekode-programvareprosjekt for datautvinning som kan tilpasses og skaleres for datautvinning.

- Mange dataanalytikere bruker det, forskere, applikasjonsutviklere og netttekstgruvespesialister over hele verden.

- Det er en Java-basert løsning på tvers av plattformer.

- Som standard gjøres henting og analysering uavhengig av hverandre.

- Dataene er kartlagt ved hjelp av XPath og navneområder.

- Den inneholder en lenkegrafdatabase.

11. VisualScraper

VisualScraper er en annen fantastisk ikke-kodende nettskraper for å trekke ut data fra Internett.

- Den tilbyr et enkelt pek-og-klikk brukergrensesnitt.

- Det tilbyr også elektroniske skrapingtjenester som dataspredning og bygging av programvareuttrekkere.

- Den holder et øye med konkurrentene dine også.

- Brukere kan planlegge at prosjektene skal kjøre på et bestemt tidspunkt eller få sekvensen gjentatt hvert minutt, dag, uke, måned og år med Visual Scraper.

- Det er billigere og mer effektivt.

- Det er ikke engang en kode å si.

- Dette er et helt gratis webcrawler-program.

- Sanntidsdata kan trekkes ut fra flere nettsider og lagres som CSV-, XML-, JSON- eller SQL-filer.

- Brukere kan bruke den til regelmessig å trekke ut nyheter, oppdateringer og foruminnlegg.

- Dataene er 100 % nøyaktige og tilpasset.

12. WebSphinx

WebSphinx er en fantastisk personlig gratis webcrawler-app som er enkel å sette opp og bruke.

- Den er designet for sofistikerte nettbrukere og Java-programmerere som ønsker å skanne en begrenset del av Internett automatisk.

- Denne online datautvinningsløsningen inkluderer et Java-klassebibliotek og et interaktivt programmeringsmiljø.

- Sider kan settes sammen for å lage et enkelt dokument som kan bla gjennom eller skrives ut.

-

Trekk ut all tekst som passer til et gitt mønster fra en sekvens av sider.

- Webcrawlere kan nå skrives i Java takket være denne pakken.

- Crawler Workbench og WebSPHINX klassebibliotek er begge inkludert i WebSphinx.

- Crawler Workbench er et grafisk brukergrensesnitt som lar deg tilpasse og betjene en webcrawler.

- En graf kan lages fra en gruppe nettsider.

- Lagre sider på din lokale stasjon for lesing uten nett.

13. OutWit Hub

OutWit Hub-plattformen består av en kjerne med et omfattende bibliotek med datagjenkjennings- og utvinningsfunksjoner, der et uendelig antall forskjellige apper kan lages, som hver bruker kjernens funksjoner.

- Denne webcrawler-applikasjonen kan skanne gjennom nettsteder og bevare dataene den oppdager på en tilgjengelig måte.

- Det er en flerbrukshøster med så mange funksjoner som mulig for å imøtekomme ulike krav.

- The Hub har eksistert lenge.

- Det har utviklet seg til en nyttig og mangfoldig plattform for ikke-tekniske brukere og IT-fagfolk som vet hvordan de skal kode, men erkjenner at PHP ikke alltid er det ideelle alternativet for å trekke ut data.

- OutWit Hub gir et enkelt grensesnitt for å skrape beskjedne eller enorme mengder data avhengig av dine krav.

- Den lar deg skrape hvilken som helst nettside direkte fra nettleseren og konstruere automatiserte agenter som henter data og forbereder dem i henhold til dine behov.

- Du kan motta et tilbud på nettsiden deres.

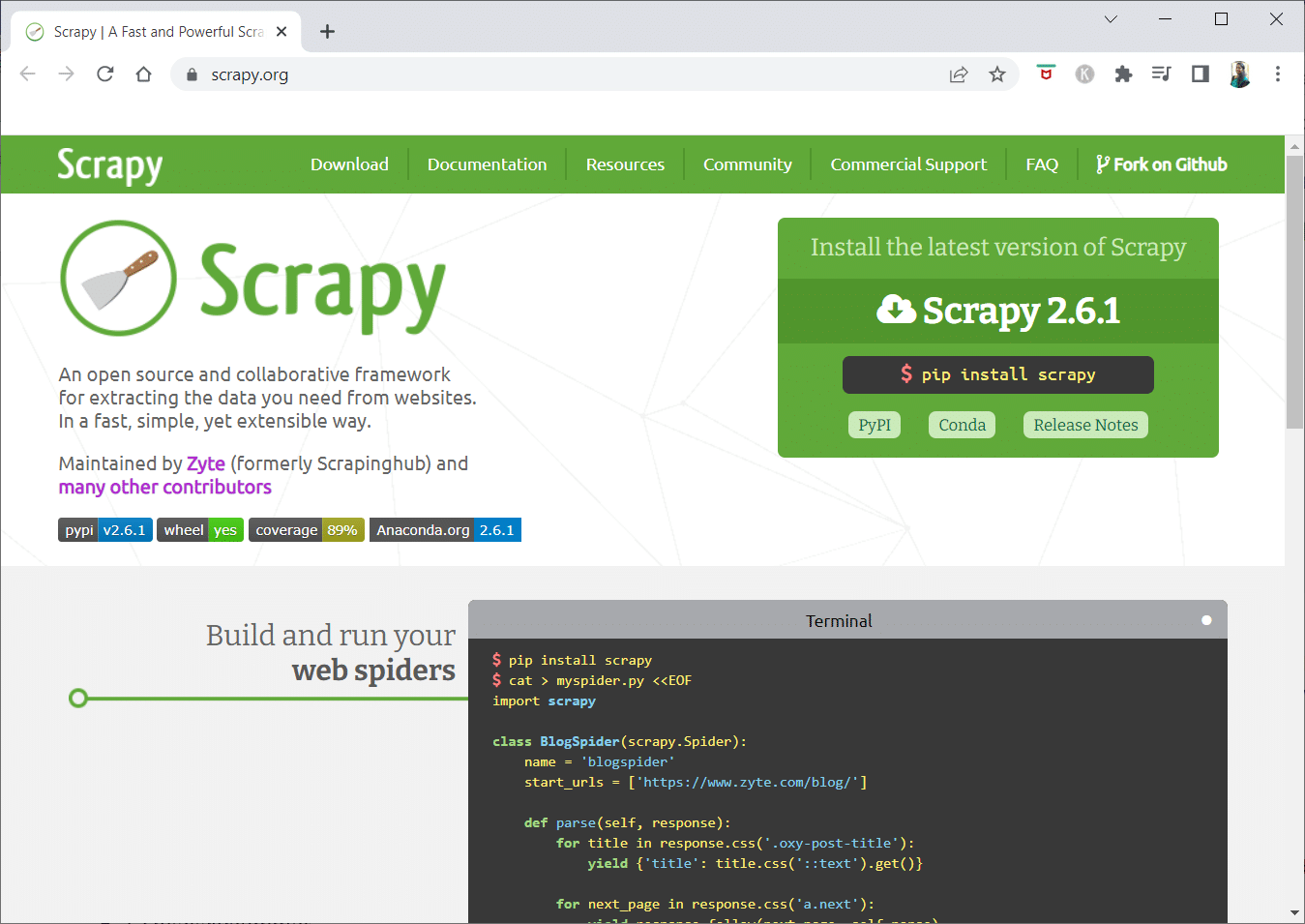

14. Scrapy

Scrapy er et Python-nettverk for skraping for å bygge skalerbare webcrawlere.

- Det er et komplett rammeverk for webcrawling som håndterer alle egenskapene som gjør webcrawlere vanskelige å lage, for eksempel proxy-mellomvare og spørrespørsmål.

- Du kan skrive reglene for å trekke ut dataene og deretter la Scrapy håndtere resten.

- Det er enkelt å legge til nye funksjoner uten å endre kjernen fordi den er utformet på den måten.

- Det er et Python-basert program som fungerer på Linux, Windows, Mac OS X og BSD-systemer.

- Dette er et helt gratis verktøy.

- Biblioteket gir programmerere en klar-til-bruk struktur for å tilpasse en webcrawler og trekke ut data fra nettet i stor skala.

15. Mozenda

Mozenda er også den beste gratis webcrawler-appen. Det er et forretningsorientert skybasert selvbetjent webskrapingsprogram. Mozenda har over 7 milliarder sider skrapet og har bedriftskunder over hele verden.

- Mozendas nettskrapingsteknologi fjerner kravet til skript og ansettelse av ingeniører.

- Det øker hastigheten på datainnsamlingen med fem ganger.

- Du kan skrape tekst, filer, bilder og PDF-informasjon fra nettsteder med Mozendas pek-og-klikk-funksjon.

- Ved å organisere datafiler kan du forberede dem for publisering.

- Du kan eksportere direkte til TSV, CSV, XML, XLSX eller JSON ved å bruke Mozedas API.

- Du kan bruke Mozendas sofistikerte Data Wrangling for å organisere informasjonen din slik at du kan ta viktige avgjørelser.

- Du kan bruke en av Mozendas partneres plattformer for å integrere data eller etablere tilpassede dataintegrasjoner i noen få plattformer.

16. Cyotek Webcopy

Cyotek Webcopy er et gratis webcrawler-verktøy som lar deg laste ned et nettsteds innhold til din lokale enhet automatisk.

- Innholdet på den valgte nettsiden vil bli skannet og lastet ned.

- Du kan velge hvilke deler av et nettsted som skal klones og hvordan du bruker dets komplekse struktur.

- Den nye lokale ruten vil omdirigere lenker til nettstedsressurser som stilark, bilder og andre sider.

- Den vil se på et nettsteds HTML-oppmerking og prøve å finne tilkoblede ressurser, for eksempel andre nettsteder, bilder, videoer, filnedlastinger og så videre.

- Den kan gjennomsøke et nettsted og laste ned det den ser for å lage en akseptabel kopi av originalen.

17. Vanlig kryp

Common Crawl var ment for alle som er interessert i å utforske og analysere data for å få nyttig innsikt.

- Det er en 501(c)(3) non-profit som er avhengig av donasjoner for å drive sin virksomhet på riktig måte.

- Alle som ønsker å bruke Common Crawl kan gjøre det uten å bruke penger eller forårsake problemer.

- Common Crawl er et korpus som kan brukes til undervisning, forskning og analyse.

- Du bør lese artiklene hvis du ikke har noen tekniske ferdigheter for å lære om de bemerkelsesverdige oppdagelsene andre har gjort ved å bruke Common Crawl-data.

- Lærere kan bruke disse verktøyene til å undervise i dataanalyse.

18. Semrush

Semrush er en websøkeapp som undersøker sidene og strukturen på nettstedet ditt for tekniske SEO-problemer. Å fikse disse problemene kan hjelpe deg med å forbedre søkeresultatene.

- Den har verktøy for SEO, markedsundersøkelser, markedsføring på sosiale medier og annonsering.

- Den har et brukervennlig brukergrensesnitt.

-

Metadata, HTTP/HTTPS, direktiver, statuskoder, duplikatinnhold, sideresponshastighet, interne koblinger, bildestørrelser, strukturerte data og andre elementer vil bli undersøkt.

- Den lar deg revidere nettstedet ditt raskt og enkelt.

- Det hjelper til med analyse av loggfiler.

- Dette programmet gir et dashbord som lar deg enkelt se nettstedproblemer.

19. Sitechecker.pro

Sitechecker.pro er en annen beste gratis webcrawler-app. Det er en SEO-sjekker for nettsteder som hjelper deg med å forbedre SEO-rangeringene dine.

- Du kan enkelt visualisere strukturen til en nettside.

- Det oppretter en SEO-revisjonsrapport på siden som kunder kan få via e-post.

- Dette webcrawler-verktøyet kan se på nettstedets interne og eksterne lenker.

- Det hjelper deg med å bestemme hastigheten til nettstedet ditt.

- Du kan også bruke Sitechecker.pro for å se etter indekseringsproblemer på landingssider.

- Det hjelper deg å forsvare deg mot hackerangrep.

20. Webharvy

Webharvy er et nettskrapeverktøy med et enkelt pek-og-klikk-grensesnitt. Den er designet for de som ikke vet hvordan de skal kode.

- Kostnaden for en lisens starter på $139.

- Du vil bruke WebHarvys innebygde nettleser til å laste nettsider og velge dataene som skal skrapes ved hjelp av museklikk.

- Den kan automatisk skrape tekst, bilder, URL-er og e-poster fra nettsteder og lagre dem i forskjellige formater.

-

Proxy-servere eller en VPN kan brukes for å få tilgang til målnettsteder.

- Å skrape data krever ikke opprettelse av noen programmering eller apper.

- Du kan skrape anonymt og forhindre at nettskrapingsprogramvare blir forbudt av webservere ved å bruke proxy-servere eller VPN-er for å få tilgang til målnettsteder.

- WebHarvy identifiserer automatisk datamønstre på nettsteder.

- Hvis du trenger å skrape en liste over objekter fra en nettside, trenger du ikke gjøre noe annet.

21. NetSpeak Spider

NetSpeak Spider er en stasjonær web-crawler-app for daglige SEO-revisjoner, raskt identifisere problemer, utføre systematiske analyser og skraping av nettsider.

- Denne webcrawling-applikasjonen utmerker seg ved å evaluere store nettsider samtidig som den minimerer RAM-bruk.

- CSV-filer kan lett importeres og eksporteres fra nettgjennomsøkingsdata.

- Med bare noen få klikk kan du identifisere disse og hundrevis av alvorlige andre SEO-problemer for nettsteder.

- Verktøyet vil hjelpe deg med å vurdere et nettsteds optimalisering på siden, inkludert statuskoden, instruksjoner for gjennomsøking og indeksering, nettstedstruktur og omdirigeringer, blant annet.

- Data fra Google Analytics og Yandex kan eksporteres.

- Ta hensyn til dataområde, enhetstype og segmentering for nettsidene dine, trafikk, konverteringer, mål og til og med e-handelsinnstillinger.

- Dets månedlige abonnementer begynner på $21.

-

Ødelagte lenker og bilder vil bli oppdaget av SEO-søkeroboten, i likhet med duplisert materiale som sider, tekster, dupliserte tittel- og metabeskrivelse-tagger og H1-er.

22. UiPath

UiPath er et nettsøkeverktøy som lar deg automatisere robotprosedyrer. Den automatiserer datagjennomgang på nett og skrivebord for de fleste tredjepartsprogrammer.

- Du kan installere robotprosessautomatiseringsapplikasjonen på Windows.

- Den kan trekke ut data i tabell- og mønsterbaserte former fra mange nettsider.

- UiPath kan utføre flere gjennomganger rett ut av esken.

- Rapportering holder styr på robotene dine, slik at du når som helst kan referere til dokumentasjonen.

- Resultatene dine vil bli mer effektive og vellykkede hvis du standardiserer praksisen din.

-

Månedlige abonnementer starter på $420.

- Markedsplassens mer enn 200 ferdige komponenter gir teamet ditt mer tid på kortere tid.

- UiPath-roboter øker samsvar ved å følge den nøyaktige metoden som dekker dine behov.

- Bedrifter kan oppnå rask digital transformasjon til lavere kostnader ved å optimalisere prosesser, gjenkjenne økonomier og tilby innsikt.

23. Heliumskrape

Helium Scraper er et visuelt nettbasert datagjennomgangsprogram som fungerer best når det er liten assosiasjon mellom elementer. På et grunnleggende nivå kan det tilfredsstille brukernes krav til gjennomsøking.

- Det krever ingen koding eller konfigurasjon.

- Et klart og enkelt brukergrensesnitt lar deg velge og legge til aktiviteter fra en spesifisert liste.

- Online maler er også tilgjengelige for spesialiserte krav til gjennomsøking.

- Utenfor skjermen brukes flere Chromium-nettlesere.

- Øk antallet samtidige nettlesere for å få så mye data som mulig.

- Definer dine egne handlinger eller bruk tilpasset JavaScript for mer komplekse tilfeller.

- Den kan installeres på en personlig datamaskin eller en dedikert Windows-server.

- Lisensene starter på $99 og går opp derfra.

24. 80Bein

I 2009 ble 80Legs grunnlagt for å gjøre nettdata mer tilgjengelig. Det er et annet av de beste gratis søkerobotverktøyene. Opprinnelig fokuserte firmaet på å tilby webcrawling-tjenester til ulike kunder.

- Vår omfattende webcrawler-app vil gi deg personlig informasjon.

- Gjennomgangshastigheten justeres automatisk basert på trafikken på nettstedet.

- Du kan laste ned funn til ditt lokale miljø eller datamaskin via 80legs.

- Ved å bare oppgi en URL, kan du gjennomsøke nettstedet.

- De månedlige abonnementene starter på $29 per måned.

- Gjennom SaaS er det mulig å konstruere og gjennomføre webcrawler.

- Den har mange servere som lar deg se nettstedet fra forskjellige IP-adresser.

- Få umiddelbar tilgang til nettstedsdata i stedet for å lete på nettet.

- Det forenkler konstruksjon og utførelse av tilpassede nettgjennomganger.

- Du kan bruke denne applikasjonen til å holde oversikt over trender på nettet.

- Du kan lage malene dine hvis du vil.

25. ParseHub

ParseHub er en utmerket webcrawler-app som kan samle informasjon fra nettsteder som bruker AJAX, JavaScript, informasjonskapsler og andre relaterte teknologier.

- Maskinlæringsmotoren kan lese, evaluere og konvertere nettinnhold til meningsfulle data.

- Du kan også bruke den innebygde nettappen i nettleseren din.

- Det er mulig å få informasjon fra millioner av nettsteder.

- ParseHub vil søke gjennom tusenvis av lenker og ord automatisk.

- Data samles inn og lagres automatisk på våre servere.

-

Månedlige pakker starter på $149.

- Som shareware kan du bare bygge fem offentlige prosjekter på ParseHub.

- Du kan bruke den til å få tilgang til rullegardinmenyer, logge på nettsteder, klikke på kart og administrere nettsider ved å bruke uendelig rulling, faner og popup-vinduer.

- ParseHubs skrivebordsklient er tilgjengelig for Windows, Mac OS X og Linux.

- Du kan skaffe de skrapte dataene dine i alle formater for analyse.

- Du kan etablere minst 20 private skrapeprosjekter med premium medlemsnivåer.

***

Vi håper at denne artikkelen var nyttig og at du har valgt ditt favorittgratis søkerobotverktøy. Del dine tanker, spørsmål og forslag i kommentarfeltet nedenfor. Du kan også foreslå de manglende verktøyene for oss. Fortell oss hva du vil lære videre.