Innholdsfortegnelse

Viktige takeaways

- Googles AI-modell Gemini har tre varianter, Ultra, Pro og Nano, fokusert på ulike oppgaver og kompleksitetsnivåer.

- Gemini Ultra viser lovende resultater på viktige AI-benchmarks, men fra og med desember 2023, ikke tilgjengelig for offentlig bruk. Google sier at den skal være tilgjengelig i januar 2024.

- Gemini Pro er tilgjengelig, og selv om den yter ganske bra, klarer den for tiden ikke å detronisere GPT-4.

Google har konsekvent lovet at Gemini AI-modellen ville være bedre enn OpenAIs GPT-4, modellen som driver ChatGPT Plus. Nå som Google Gemini har lansert, kan vi endelig sette den på prøve og se hvordan Gemini er sammenlignet med GPT-4.

Da Google lanserte Bard i mars 2023, var det mange grunner til å være begeistret. Til slutt ville OpenAIs ChatGPT-monopol bli brutt, og vi ville få verdig konkurranse.

Men Bard var aldri AI-titanen folk håpet på, og GPT-4 er fortsatt den dominerende generative AI-chatbot-plattformen. Nå er Googles Gemini her – men er den etterlengtede AI-modellen bedre enn ChatGPT?

Hva er Googles Gemini AI-modell?

Gemini er Googles mest kapable generative AI-modell, i stand til å forstå og operere på tvers av forskjellige dataformater, inkludert tekst, lyd, bilde og video. Det er Googles forsøk på å lage en enhetlig AI-modell som tegner evner fra de mest kapable AI-teknologiene. Gemini vil være tilgjengelig i tre varianter:

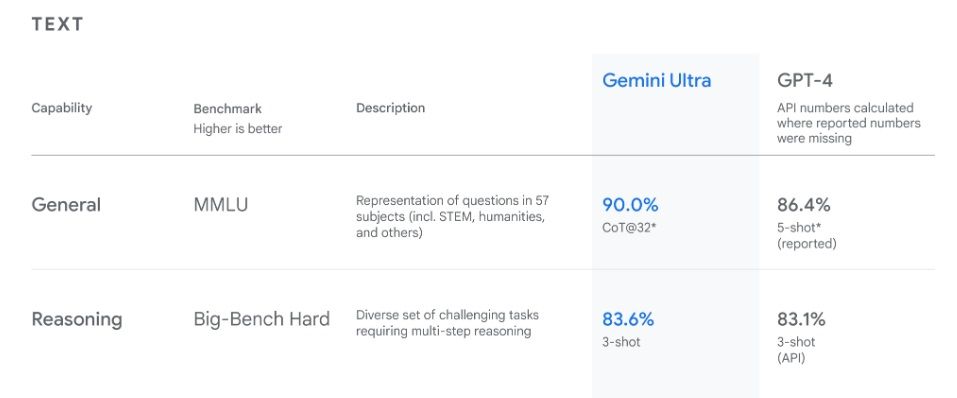

På sin offisielle blogg, Nøkkelordet, sier Google at Gemini Ultra utkonkurrerer toppmoderne i flere benchmarks. Google hevder Gemini Ultra slår bransjeledende GPT-4 i flere viktige benchmarks.

Med en enestående 90,0 % poengsum på den strenge MMLU-referansen, sier Google at Gemini Ultra er den første modellen som overgår ytelsen på menneskelig nivå i denne mangefasetterte testen som omfatter 57 fag.

Gemini Ultra kan også forstå, forklare og generere høykvalitetskode på noen av verdens mest populære programmeringsspråk, inkludert Go, JavaScript, Python, Java og C++. På papiret er dette alle flotte resultater. Men disse er alle målestokker, og målestokker forteller ikke alltid hele historien. Så hvor godt presterer Gemini i virkelige oppgaver?

Slik bruker du Google Gemini AI

Av de tre variantene av Gemini AI-modellen kan du begynne å bruke Gemini Pro akkurat nå. Gemini Pro er for øyeblikket tilgjengelig på Googles Bard chatbot. For å bruke Gemini Pro med Bard, gå til bard.google.com og logg på med Google-kontoen din.

Google sier at Gemini Ultra vil rulle ut i januar 2024, så vi har måttet nøye oss med å teste Gemini Pro mot ChatGPT foreløpig.

Hvordan Gemini sammenligner med GPT-3.5 og GPT-4

Når en ny AI-modell lanseres, testes den mot OpenAIs GPT AI-modeller, som generelt er akseptert som den toppmoderne modellen andre modeller bør holdes oppe mot. Så ved å bruke Bard og ChatGPT testet vi Geminis evne til matematikk, kreativ skriving, kodegenerering og nøyaktig behandling av bildeinndata.

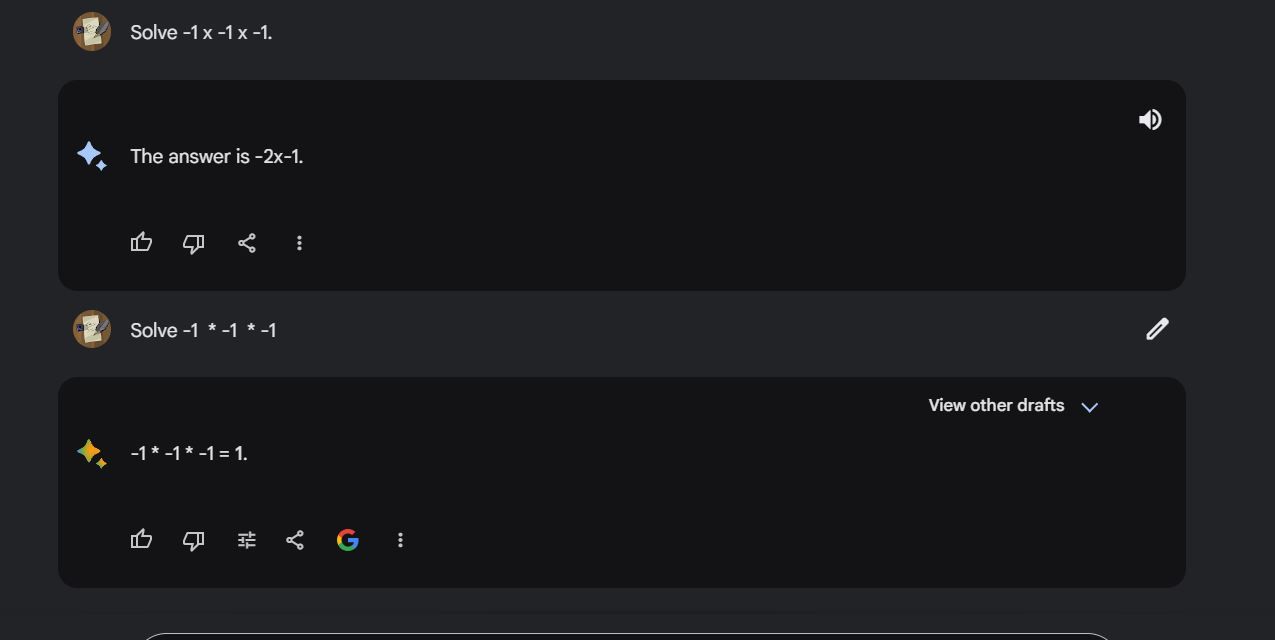

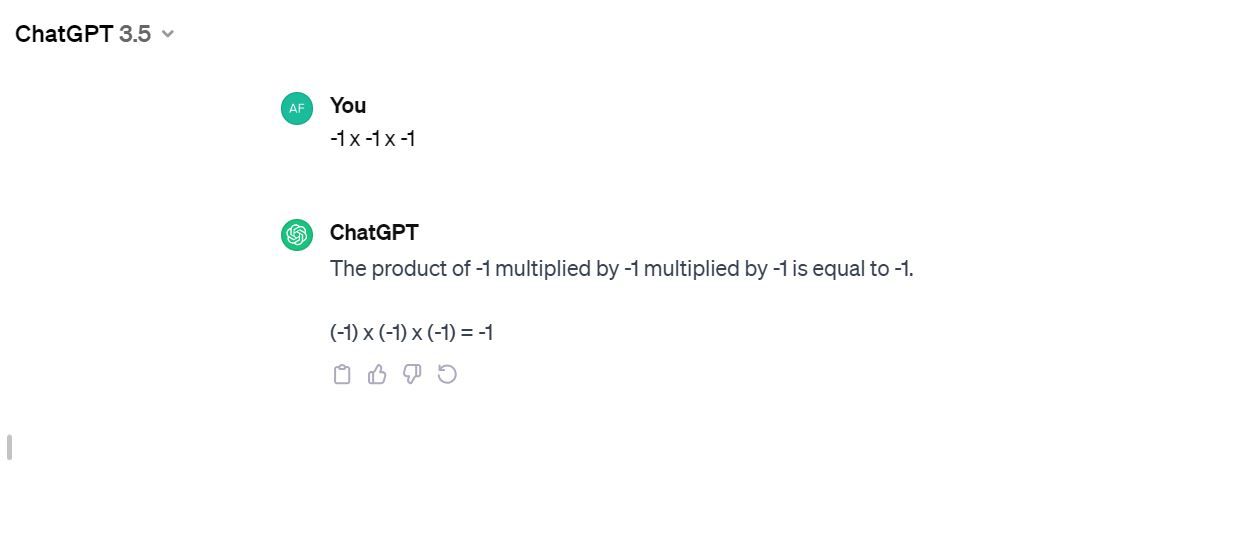

Med utgangspunkt i det enkleste matematikkspørsmålet vi kunne tenke oss, ba vi begge chatbotene om å løse: -1 x -1 x -1.

Bard gikk først. Vi gjentok spørsmålet to ganger, og alle kom tilbake med feil svar. Vi fikk svaret på tredje forsøk, men det teller ikke.

Vi prøvde ChatGPT som kjører på GPT-3.5. Den første rettssaken gjorde det riktig.

For å teste Geminis bildetolkningsevner, ga vi den i oppgave å tolke noen populære memer. Den avslo, og sa at den ikke kan tolke bilder med folk i den. ChatGPT, som kjører GPT-4V, var villig og i stand til å gjøre det feilfritt.

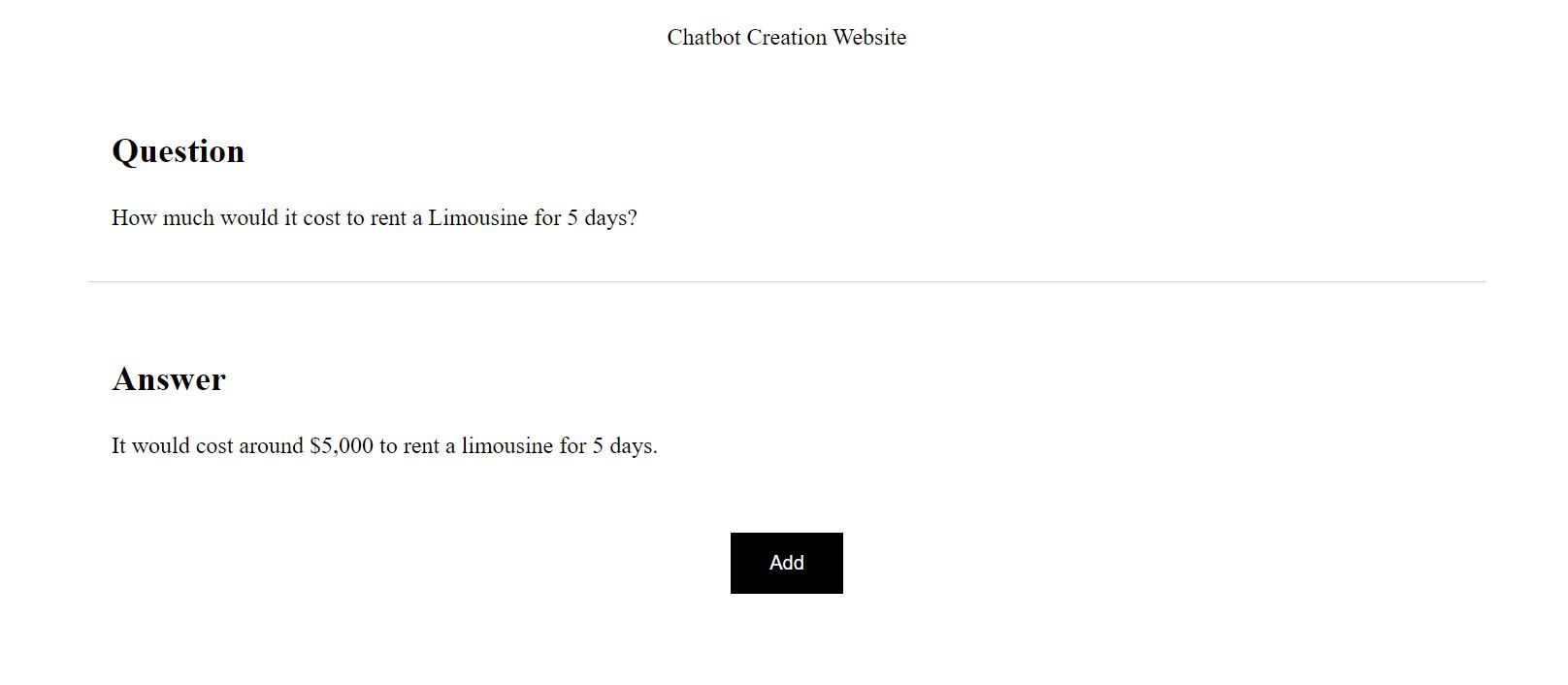

Vi prøvde et nytt forsøk på å få det til å tolke et bilde mens vi testet dets problemløsnings- og kodingsevne. Vi ga Bard, som kjører Gemini Pro, et skjermbilde og ba den tolke og skrive HTML- og CSS-kode for å gjenskape skjermbildet.

Her er kildeskjermbildet.

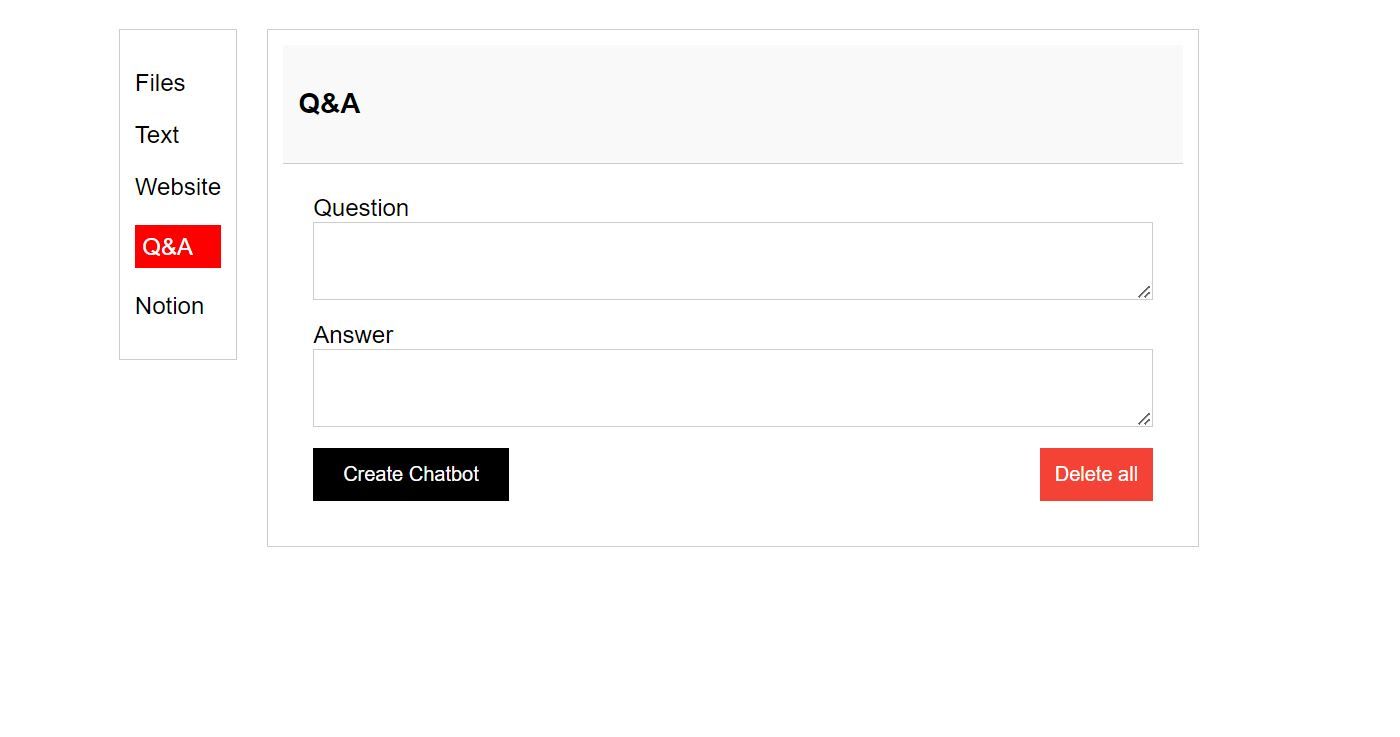

Nedenfor er Gemini Pros forsøk på å tolke og replikere skjermbildet ved hjelp av HTML og CSS.

Og her er GPT-4s forsøk på å kopiere skjermbildet. Resultatet er ikke overraskende, med tanke på at GPT-4 historisk sett har vært sterk på koding. Vi har tidligere demonstrert bruk av GPT-4 for å bygge en nettapp fra bunnen av.

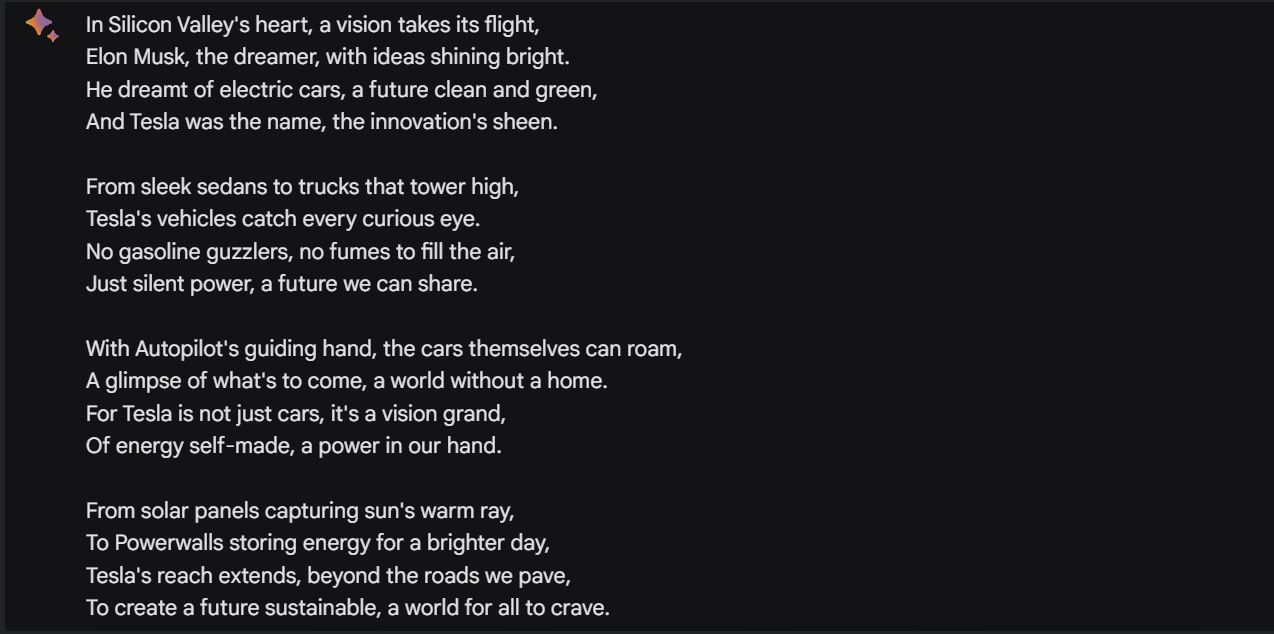

Vi ba Gemini Pro lage et dikt om Tesla (bilmerket for elbiler). Den viste marginale forbedringer fra tidligere tester vi har gjort tidligere. Her er resultatet:

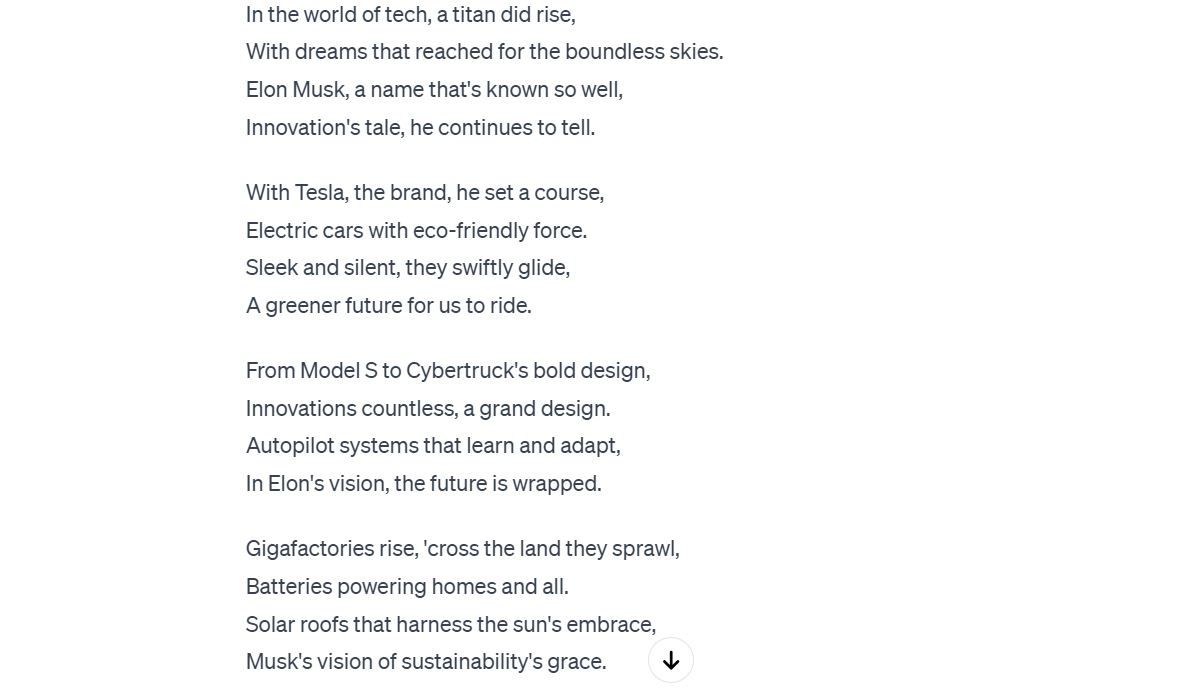

På dette tidspunktet trodde vi å sammenligne resultatene med GPT-3.5 i stedet for den superladede GPT-4 ville være mer passende. Så vi spurte ChatGPT som kjører GPT-3.5 om å lage et lignende dikt.

Det kan være et personlig valg, men Gemini Pros syn på dette virker bedre. Men vi lar deg være dommeren.

Er Gemini bedre enn ChatGPT?

Før Google lanserte Bard, trodde vi at det ville være ChatGPT-konkurransen vi hadde ventet på – det var det ikke. Nå er Gemini her, og så langt virker ikke Gemini Pro som modellen for å gi ChatGPT knockout-punch.

Google sier Gemini Ultra kommer til å bli mye bedre. Vi håper virkelig det er det, og at det oppfyller eller overgår påstandene i Gemini Ultra-kunngjøringen. Men før vi ser og tester den beste versjonen av Googles generative AI-verktøy, vet vi ikke om det kan løsne andre AI-modellkonkurrenter. Som det står, forblir GPT-4 den ubestridte AI-modellmesteren.