Som barn elsket jeg å se tegneseriefilmer med biler som så ut til å kjøre seg selv. Det fikk meg til å lure på om slike biler kunne være ekte og om det var bittesmå roboter inne som kjørte dem på magisk vis.

Etter hvert som vi blir eldre, blir selvkjørende biler ekte! Jeg er oppriktig fascinert av dem. Forstår de når de skal stoppe for eksempel ved stoppskilt og rødt lys? Kan de til og med se dyr og mennesker gå rundt på veien? Og hva med å kjøre når det er mørkt ute eller når det er regn eller snø?

La oss snakke om selvkjørende biler! Dette er biler som kan kjøre selv uten en menneskelig sjåfør. Selskaper som Tesla og Waymo bruker smarte datateknikker, som dyp læring, for å gjøre disse bilene supersmarte. Dyplæring hjelper bilene til å gjøre kule ting, som å forstå veiskilt og kjøre trygt selv når været er forferdelig. Det handler om å bruke avansert teknologi for å forme hvordan vi skal komme oss rundt i fremtiden!

Innholdsfortegnelse

Historie

Historien til selvkjørende biler ligner på et langt, spennende eventyr. Se for deg 1920-tallet, da autonome kjøretøy fortsatt bare var en drøm for mennesker. Et oppfinnsomt sinn, Francis Houdina, skilte seg ut ved å lage en bil som fulgte linjene på veien. Den trengte imidlertid spesielle skjulte ledninger under veien for å lede den.

Kilde: theatlantic.com

Kilde: theatlantic.com

På vei frem til 1980- og 1990-tallet var de strålende hodene ved Carnegie Mellon University inne på noe stort. De utviklet biler som kunne «se» ved hjelp av kameraer, og hjalp dem med å navigere i travle bygater. Disse bilene var som å lære oppdagere, oppdage hvordan man kjører ved å se seg rundt.

Så kom et betydelig øyeblikk i 2004, satt på bakgrunn av en ørkenutfordring. Selvkjørende biler entret scenen, forsøkte et tøft løp – et løp de ikke vant, men det var en start. Tenk på det som deres treningsplass for å bli bedre sjåfører.

Imidlertid skjedde det faktiske gjennombruddet på 2000- og 2010-tallet da store selskaper som Tesla, Uber og Google (nå Waymo) gikk inn i bilsektoren. Google begynte å teste selvkjørende biler i 2009. Spol frem til 2015 introduserte Teslas biler en funksjon der de delvis kunne kjøre selv på bestemte veier. De kunne håndtere styring og holde seg på veien uten konstant menneskelig kontroll.

Etter hvert som flere selskaper ble med i løpet, ble konkurransen om å lage helt selvkjørende biler hard. Se for deg team av oppfinnere som raser for å lage biler som kan kjøre uten at mennesker trenger å styre.

Men historien fortsetter. Vi jobber fortsatt med å lage biler som kan kjøre alene, noe som vil endre måten vi reiser på. Dette eventyret skjer fortsatt, og det betyr at vi kan ha tryggere og enklere turer fordi disse fancy selvkjørende bilene blir bedre.

Hvordan fungerer selvkjørende biler?

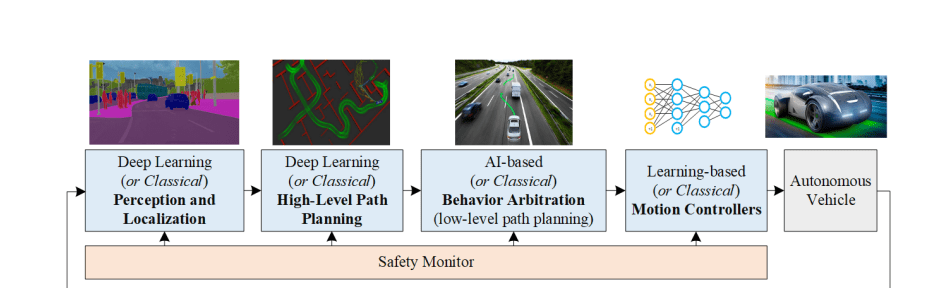

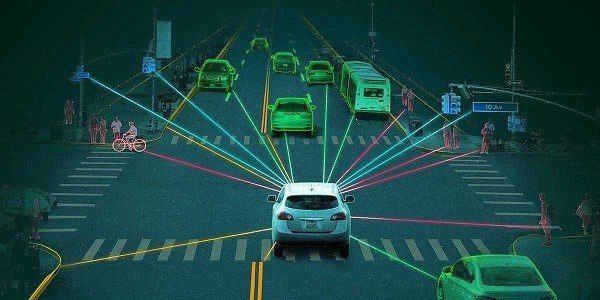

Selvkjørende biler er som supersmarte beslutningstakere! De bruker kameraer, LiDAR, RADAR, GPS og treghetssensorer for å samle inn data om omgivelsene. Deretter behandler spesielle algoritmer kalt dyplæringsalgoritmer disse dataene for å forstå hva som skjer rundt dem. Basert på denne forståelsen tar de viktige beslutninger for å kjøre trygt og jevnt.

Kilde: arxiv.org

Kilde: arxiv.org

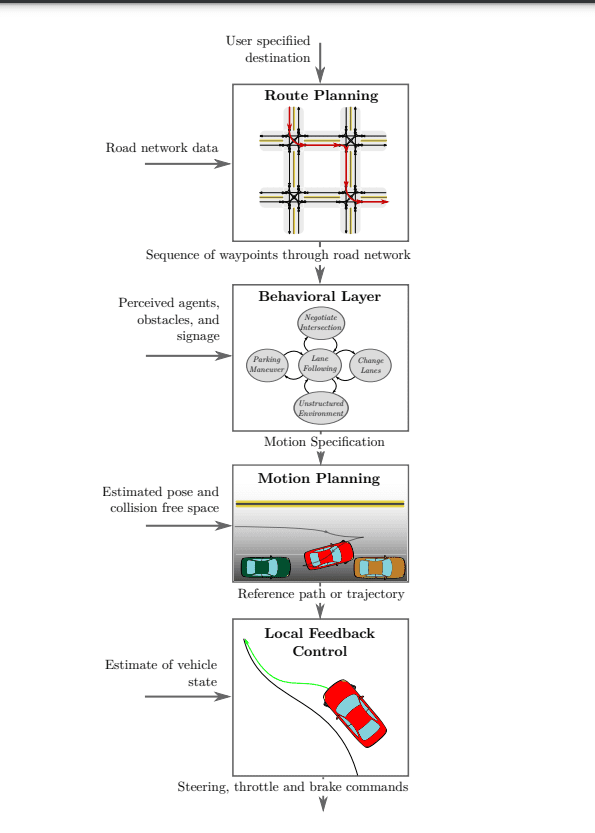

Hvis vi ønsker å finne ut hvordan selvkjørende biler egentlig fungerer, la oss se nærmere på disse fire delene vist i diagrammet ovenfor. Det er som å løse et puslespill – å forstå hver brikke vil hjelpe oss å se det større bildet av hvordan disse fantastiske bilene fungerer:

- Oppfatning

- Lokalisering

- Forutsigelse

- Beslutningstaking

- Veiplanlegging på høyt nivå

- Adferdsvoldgift

- Bevegelseskontroller

Oppfatning

#1. Kamera

Kameraer er som øynene til en selvkjørende bil – de er superviktige! De hjelper bilen å vite hva som skjer rundt den. Disse kameraene gjør forskjellige jobber, som å finne ut hva ting er, skille forskjellige deler og finne hvor bilen er.

For å sikre at bilen ikke går glipp av noe, har den kameraer plassert over hele – foran, bak, venstre og høyre. Disse kameraene jobber sammen for å lage et stort bilde av alt rundt bilen. Det er som bilens egen spesielle 360-graders utsikt!

Disse kameraene er ikke bare for utstilling. De er smarte. Noen ser langt unna, opptil 200 meter, så bilen vet hva som kommer foran. Andre fokuserer på ting i nærheten, slik at bilen kan følge nøye med på detaljer. Dette kamerateamet hjelper bilen med å se og forstå alt, som en venn som veileder den, slik at den kan kjøre trygt og ta gode valg.

Noen ganger er kameraer veldig nyttige, som når du parkerer, fordi de viser vid utsikt og hjelper deg med å ta gode valg for å kjøre forsiktig.

Men bare bruk av kameraer for å se ting har problemer, spesielt i tøft vær som tåke, kraftig regn og om natten. I disse tider kan bildene fra kameraene se rare og rotete ut, noe som kan være veldig utrygt.

For å håndtere disse utfordrende situasjonene trenger vi spesielle sensorer som kan fungere når det er virkelig mørkt eller til og med helt natt. De skal også kunne måle hvor langt ting er uten å trenge lys som vi kan se. Når vi setter disse sensorene i bilens øyne (persepsjonssystem), blir bilen bedre til å kjøre i dårlig vær eller når det er vanskelig å se. Så bilen kan kjøre sikrere, noe som er flott for alle som kjører på veien.

#2. LiDAR

LiDAR, som betyr Light Detection And Ranging, er en fancy teknologi som bruker lasere for å finne ut hvor langt ting er. LiDAR sender ut laserstråler og måler hvor lang tid det tar å komme tilbake fra ting.

Når LiDAR og kameraer fungerer sammen, hjelper de bilen med å forstå ting klarere. Den lager et 3D-kart over hva som er rundt bilen. Denne spesielle informasjonen kan deretter ses på av smarte dataprogrammer, som hjelper bilen med å gjette hva andre biler kan gjøre. Dette er nyttig når veien er vanskelig, som ved travle kryssinger, fordi bilen kan se på andre biler og kjøre trygt.

LiDAR har imidlertid begrensninger som kan være problematiske. Selv om den fungerer bra om natten og i mørke omgivelser, kan den slite under forhold med forstyrrelser fra regn eller tåke, noe som potensielt kan føre til unøyaktigheter i oppfatningen. For å løse disse problemene bruker vi både LiDAR- og RADAR-sensorer samtidig. Disse sensorene gir ekstra informasjon som hjelper bilen å forstå ting klarere. Bilen kan kjøre på egenhånd på en tryggere og bedre måte.

#3. RADAR

RADAR, som står for Radio Detection and Ranging, har vært brukt i lang tid i hverdagslige ting og også av militæret. Opprinnelig brukt av militæret for å oppdage objekter, beregner RADAR avstander ved hjelp av radiobølgesignaler. I dag er RADAR viktig i mange biler, spesielt selvkjørende.

RADAR er kjempebra fordi den kan fungere i all slags vær og lys. I stedet for lasere bruker den radiobølger, noe som gjør den fleksibel og super nyttig. RADAR regnes imidlertid som en støyende sensor, noe som betyr at den kan oppdage hindringer selv når kameraet ikke ser noen.

Den selvkjørende bilens hjerne kan bli forvirret av alle de ekstra signalene fra RADAR, som vi kaller «støy». For å fikse dette, må bilen rydde opp i RADAR-informasjonen slik at den kan ta gode valg.

Å rense dataene betyr å bruke spesielle triks for å skille de sterke signalene fra de svake, som å skille de viktige tingene fra de ikke så viktige tingene. Bilen bruker et smart triks kalt Fast Fourier Transforms (FFT) for å forstå informasjonen enda bedre.

RADAR og LiDAR gir informasjon om enkeltpunkter, som prikker på papir. For å forstå disse punktene bedre, bruker bilen noe sånt som gruppering. Det er som når du setter sammen lignende ting. Bilen bruker smarte statistiske metoder, som Euklidisk Clustering eller K-betyr Clustering, for å kombinere lignende prikker og forstå dem. Dette gjør at bilen kan kjøre smartere og tryggere.

Lokalisering

I selvkjørende biler spiller lokaliseringsalgoritmer en avgjørende rolle for å bestemme kjøretøyets posisjon og orientering mens det navigerer, kjent som Visual Odometry (VO). VO fungerer ved å identifisere og matche nøkkelpunkter i påfølgende videobilder.

Bilen ser på spesielle prikker i informasjonen, som merker på et kart. Etter det bruker bilen statistikk kalt SLAM for å finne ut hvor ting er og hvordan de beveger seg. Dette hjelper bilen å vite hva som er rundt, som veier og mennesker.

Og for å gjøre dette enda bedre bruker bilen noe som kalles dyp læring. Det er som en supersmart datamaskin.

Disse triksene gjør bilen god til å forstå ting veldig godt. Nevrale nettverk som PoseNet og VLocNet++, utnytter punktdata for å estimere 3D-posisjonen og -orienteringen til objekter. Disse estimerte 3D-posisjonene og -orienteringene kan deretter brukes til å utlede scenesemantikk, som vist i bildet nedenfor. Når bilen bruker matematikk og smarte datatriks, vet den hvor den er og hva som er rundt den. Dette hjelper bilen til å kjøre trygt og jevnt på egenhånd.

Forutsigelse

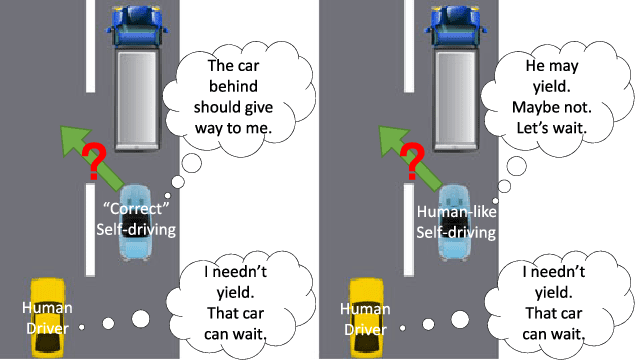

Å forstå menneskelige drivere er virkelig en kompleks oppgave, siden det involverer følelser og reaksjoner i stedet for enkel logikk. Fordi vi ikke vet hva andre sjåfører vil gjøre, er det avgjørende for selvkjørende biler å gjøre gode gjetninger om handlingene deres. Dette bidrar til å sikre sikkerheten på veien.

Se for deg selvkjørende biler med øyne rundt, som en 360-graders utsikt. Dette lar dem se alt som skjer. De bruker denne informasjonen med dyp læring. Bilen bruker smarte teknikker for å forutsi hva andre sjåfører kan gjøre. Det ligner på å spille et spill der du planlegger å gjøre det bra.

Prediksjon ved hjelp av Deep Learning

Prediksjon ved hjelp av Deep Learning

De spesielle sensorene i selvkjørende biler er som øynene deres. De hjelper bilene å vite hva som er på bilder, finne ting rundt dem, vite hvor de er og se hvor ting ender. Dette hjelper bilen med å finne ut hva som er i nærheten og ta smarte valg.

Under trening modellerer dyplæringsalgoritmer kompleks informasjon fra bilder og skydatapunkter hentet fra LiDAR og RADAR. Under faktisk kjøring (inferens) hjelper den samme modellen bilen med å forberede seg på mulige bevegelser, inkludert bremsing, stansing, bremse, skifte fil og mer.

Dyplæring er som en smart hjelper for bilen. Dette får bilen til å forstå ting den er usikker på, finne ut hvor den ligger og kjøre bedre. Dette holder kjøringen trygg og gjør at det går mer jevnt.

Men den vanskelige delen er å bestemme den beste handlingen fra noen få valg. Å velge de riktige trekkene krever nøye tenkning slik at bilen kan kjøre godt og holde seg trygg.

Beslutningstaking

Selvkjørende biler må ta viktige valg i vanskelige situasjoner, men det er ikke lett. Dette er fordi sensorer kanskje ikke alltid er riktige, og folk på veien kan gjøre uventede ting. Bilen må gjette hva andre vil gjøre og bevege seg for å unngå krasj.

For å ta valg trenger bilen mye info. Bilen samler denne informasjonen ved hjelp av sensorer og bruker deretter dyplæringsalgoritmer for å forstå hvor ting er og forutsi hva som kan skje. Lokalisering hjelper bilen til å kjenne sin utgangsposisjon, mens prediksjon genererer flere mulige handlinger basert på miljøet.

Spørsmålet gjenstår imidlertid: hvordan velger bilen den beste handlingen blant de mange spådde?

Kilde: semanticscholar.org

Kilde: semanticscholar.org

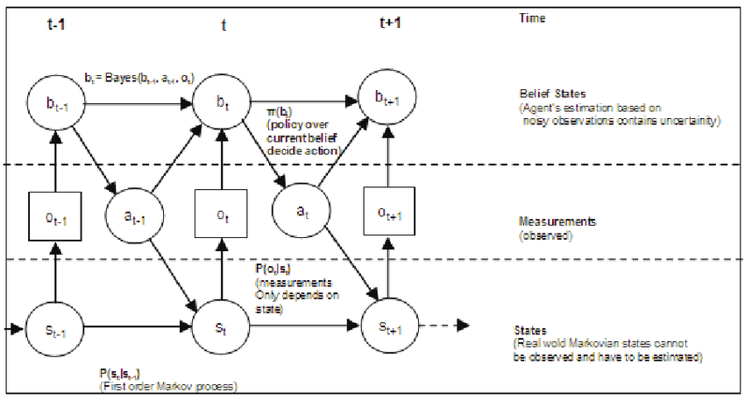

Deep Reinforcement Learning (DRL) er en teknikk for å ta beslutninger, og den bruker en algoritme kalt Markov Decision Process (MDP). MDP er behjelpelig med å gjette hvordan folk på veien kan opptre i fremtiden. Når det er flere ting som beveger seg, blir ting mer komplisert. Dette betyr at den selvkjørende bilen må tenke på enda flere mulige handlinger.

For å møte utfordringen med å finne det beste trekket for bilen, er dyplæringsmodellen optimalisert ved hjelp av Bayesiansk optimalisering. I noen tilfeller brukes et rammeverk som kombinerer en skjult Markov-modell og Bayesian Optimization for beslutningstaking, som gjør at den selvkjørende bilen kan navigere effektivt og trygt i ulike komplekse scenarier.

Kilde: arxiv.org

Kilde: arxiv.org

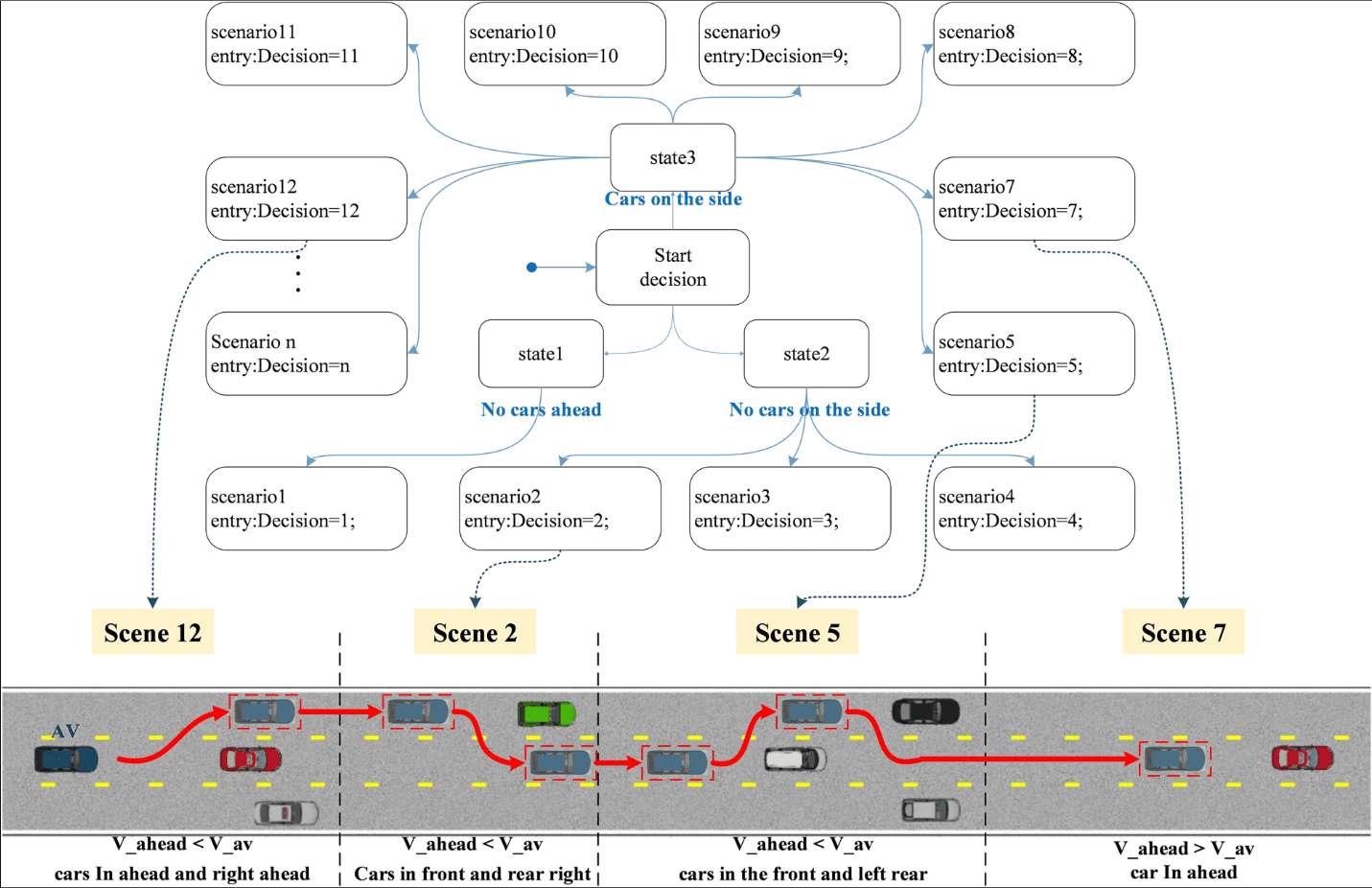

Beslutningstaking i selvkjørende biler følger en hierarkisk prosess med fire nøkkelkomponenter:

Bane- eller ruteplanlegging: Ved begynnelsen av reisen bestemmer bilen den beste ruten fra sin nåværende posisjon til ønsket destinasjon. Målet er å finne en optimal løsning blant ulike mulige ruter.

Adferdsvoldgift: Bilen må styre gjennom ruten etter planlegging. Bilen er klar over statiske objekter som veier og veikryss, men den er ikke i stand til å forutse de nøyaktige handlingene til andre sjåfører. For å håndtere denne usikkerheten bruker vi smarte metoder som Markov Decision Processes (MDPs) for planlegging.

Scenarioavgjørelse av toppstatsmaskin

Scenarioavgjørelse av toppstatsmaskin

Bevegelsesplanlegging: Med ruten planlagt og atferdslaget bestemmer hvordan den skal navigeres, koordinerer bevegelsesplanleggingssystemet bilens bevegelser. Dette betyr å sørge for at bilen beveger seg på en måte som er både trygg og komfortabel for menneskene inne. Den tenker på ting som hvor fort den går, skifter kjørefelt og hva som er rundt den.

Kjøretøykontroll: Det siste trinnet er kjøretøykontroll, som utfører referansebanen generert av bevegelsesplanleggingssystemet, og sikrer at bilen følger den tiltenkte banen jevnt og sikkert.

Ved å bryte ned beslutningstaking i disse ulike delene, kan selvkjørende biler kjøre godt og trygt på kompliserte steder. Dette sørger for at passasjerene får en jevn og komfortabel tur.

Konvolusjonelle nevrale nettverk

Konvolusjonelle nevrale nettverk (CNN) er mye brukt i selvkjørende biler på grunn av deres evne til å modellere romlig informasjon, spesielt bilder. CNN-er utmerker seg med å trekke ut funksjoner fra bilder, noe som gjør dem nyttige for å finne ut mange forskjellige ting.

I et CNN, ettersom nettverkets dybde øker, fanger forskjellige lag opp forskjellige mønstre. Tidlige lag oppdager enkle funksjoner som kanter, mens dypere lag gjenkjenner mer komplekse, for eksempel objektformer (som blader på trær eller dekk på kjøretøy). Denne tilpasningsevnen er grunnen til at CNN-er er en sentral algoritme i selvkjørende biler.

Kjernekomponenten i en CNN er konvolusjonslaget, som bruker en konvolusjonskjerne (filtermatrise) for å behandle lokale regioner av inndatabildet.

Filtermatrisen oppdateres under trening for å oppnå meningsfulle vekter. En grunnleggende egenskap til CNN er vektdeling, der de samme vektparametrene brukes til å representere forskjellige transformasjoner, sparer prosesseringsplass og muliggjør forskjellige funksjonsrepresentasjoner.

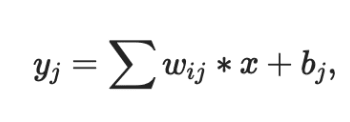

Utgangen fra konvolusjonslaget sendes vanligvis gjennom en ikke-lineær aktiveringsfunksjon, som Sigmoid, Tanh eller ReLU. ReLU foretrekkes da den konvergerer raskere enn de andre. Dessuten går resultatet ofte gjennom et maks-pooling-lag. Dette holder viktige detaljer fra bildet, som bakgrunn og teksturer.

Tre essensielle egenskaper til CNN-er gjør dem allsidige og grunnleggende i selvkjørende biler:

- Lokale mottaksfelt

- Delte vekter

- Romlig prøvetaking

Disse egenskapene reduserer overtilpasning og lagrer kritiske representasjoner og funksjoner som er avgjørende for bildeklassifisering, segmentering, lokalisering og mer.

Her er to CNN-nettverk som brukes av selskaper som er banebrytende selvkjørende biler:

- HydraNet fra Tesla

- ChauffeurNet fra Google Waymo

Lær mer om konvolusjonelle nevrale nettverk.

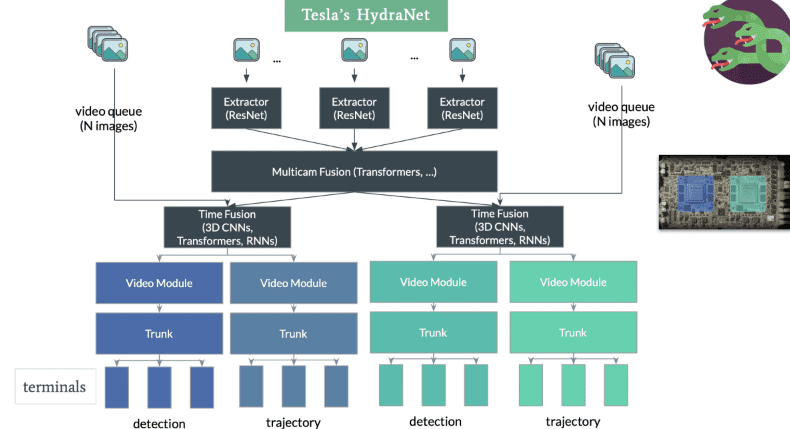

#1. HydraNet fra Tesla

HydraNet er en dynamisk arkitektur introdusert av Ravi et al. i 2018, primært utviklet for semantisk segmentering i selvkjørende biler. Hovedmålet er å forbedre beregningseffektiviteten under inferens.

Konseptet med HydraNet innebærer å ha forskjellige CNN-nettverk, kalt filialer, tildelt spesifikke oppgaver. Hver gren mottar forskjellige innganger, og nettverket kan selektivt velge hvilke grener som skal kjøres under inferens, og til slutt aggregere utdataene fra forskjellige grener for å ta en endelig beslutning.

I sammenheng med selvkjørende biler kan input representere ulike aspekter av miljøet, som statiske objekter (trær og veirekkverk), veier og kjørefelt, trafikklys osv. Disse inputs trenes i separate grener. Under inferens bestemmer portmekanismen hvilke grener som skal aktiveres, og kombinatoren samler utgangene deres for å ta den endelige avgjørelsen.

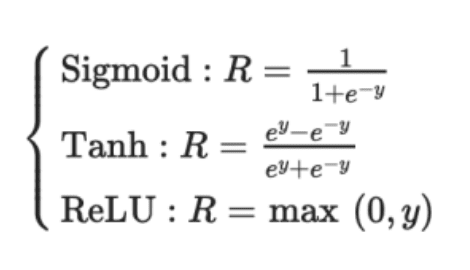

Deteksjon av hastighet, kjørefelt og bevegelse

Deteksjon av hastighet, kjørefelt og bevegelse

Tesla har tilpasset HydraNet-arkitekturen, inkludert en delt ryggrad for å møte utfordringer med å skille data for individuelle oppgaver under konklusjon. Den delte ryggraden, vanligvis modifiserte ResNet-50-blokker, gjør at nettverket kan trenes på alle objekters data. Oppgavespesifikke hoder basert på semantisk segmenteringsarkitektur, som U-Net, gjør det mulig for modellen å forutsi utdata spesifikke for hver oppgave.

Teslas HydraNet skiller seg ut ved sin evne til å projisere et fugleperspektiv, og skaper en 3D-representasjon av miljøet fra alle vinkler. Denne forbedrede dimensjonaliteten hjelper bilen med bedre navigasjon. Bemerkelsesverdig nok oppnår Tesla dette uten å bruke LiDAR-sensorer. I stedet er den avhengig av bare to sensorer: et kamera og en radar. Effektiviteten til Teslas HydraNet lar den behandle informasjon fra åtte kameraer og generere dybdeoppfatning, og demonstrerer imponerende muligheter uten behov for ekstra LiDAR-teknologi

#2. ChauffeurNet fra Google Waymo

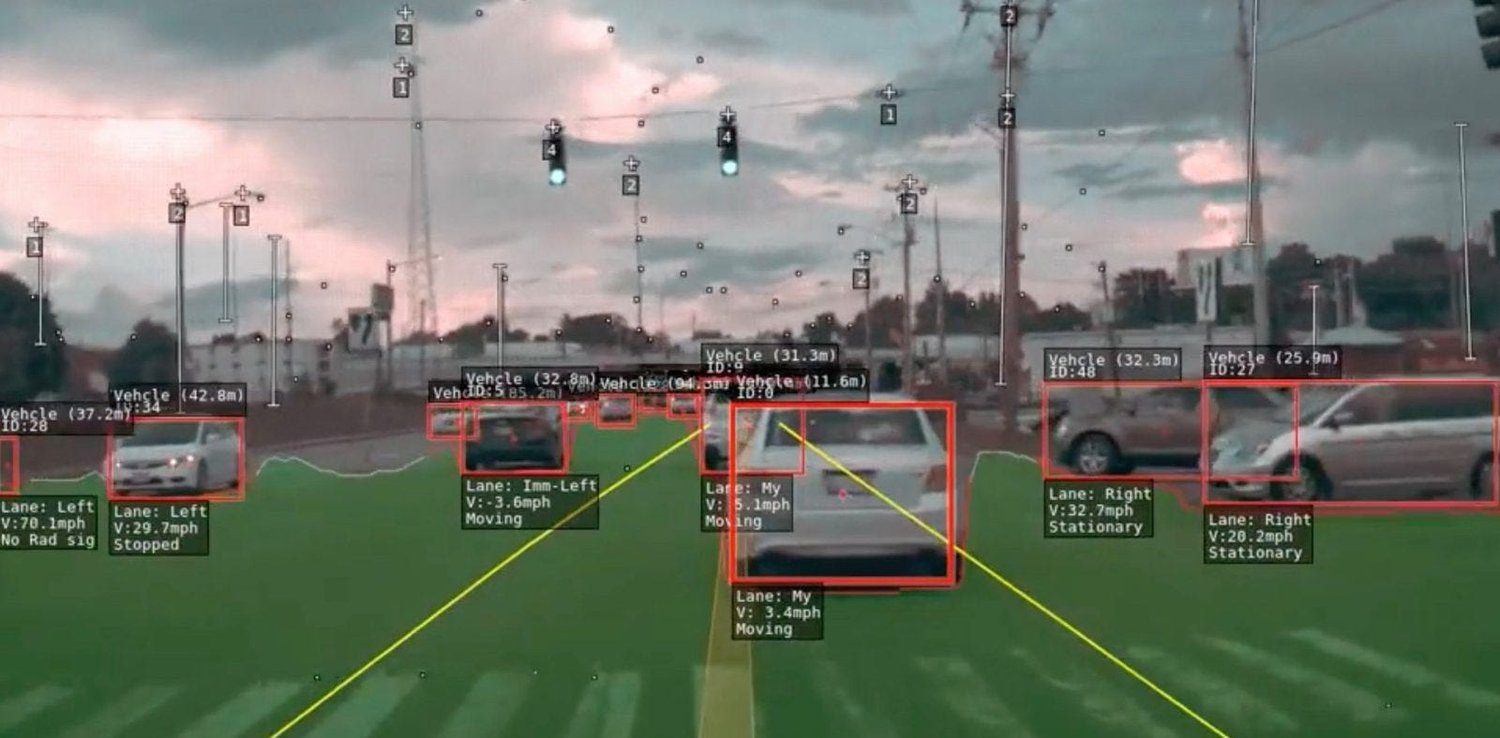

ChauffeurNet er et RNN-basert nevralt nettverk som brukes av Google Waymo for å trene selvkjørende biler ved å bruke imitasjonslæring. Mens den først og fremst er avhengig av en RNN for å generere kjørebaner, inneholder den også en CNN-komponent kjent som FeatureNet.

Dette konvolusjonelle funksjonsnettverket trekker ut kontekstuelle funksjonsrepresentasjoner som deles av andre nettverk og brukes til å trekke ut funksjoner fra persepsjonssystemet.

Kilde: Researchgate

Kilde: Researchgate

Konseptet bak ChauffeurNet er å trene den selvkjørende bilen ved å imitere ekspertsjåfører ved å bruke imitasjonslæring. For å overvinne begrensningen av utilstrekkelige treningsdata fra den virkelige verden, introduserte forfatterne av artikkelen «ChauffeurNet: Learning to Drive by Imitating the Best and Synthesizing the Worst» syntetiske data.

Disse syntetiske dataene introduserer ulike avvik, som å forstyrre banen, legge til hindringer og lage unaturlige scener. Å trene bilen med syntetiske data ble funnet å være mer effektivt enn å kun bruke ekte data.

I ChauffeurNet er ikke persepsjonssystemet en del av ende-til-ende-prosessen, men fungerer som et mellomnivåsystem. Dette gjør at nettverket kan ha ulike inngangsvariasjoner fra persepsjonssystemet. Nettverket observerer en representasjon på mellomnivå av scenen fra sensorene, og ved å bruke denne inngangen sammen med syntetiske data, imiterer det ekspertkjøreatferd.

Ved å ta hensyn til persepsjonsoppgaven og skape et fugleperspektiv på høyt nivå av miljøet, letter ChauffeurNet enklere overføringslæring, slik at nettverket kan ta bedre beslutninger basert på både reelle og simulerte data. Nettverket genererer kjørebaner ved iterativt å forutsi suksessive punkter i kjørebanen basert på representasjoner på mellomnivå. Denne tilnærmingen har vist lovende å trene selvkjørende biler mer effektivt, og gir en vei mot sikrere og mer pålitelige autonome kjøresystemer.

#3. Delvis observerbar Markov-beslutningsprosess brukt for selvkjørende biler

Partially Observable Markov Decision Process (POMDP) er et matematisk rammeverk som brukes i sammenheng med selvkjørende biler for å ta beslutninger under usikkerhet. I virkelige scenarier har selvkjørende biler ofte begrenset informasjon om miljøet på grunn av sensorstøy, okklusjoner eller ufullkomne persepsjonssystemer. POMDP er designet for å håndtere slik delvis observerbarhet og ta optimale beslutninger ved å vurdere både usikkerhet og tilgjengelige observasjoner.

I en POMDP opererer beslutningstakeren i et miljø med delvis observerbare tilstander. Agenten tar affære, og miljøet går over til nye tilstander sannsynlig. Agenten mottar imidlertid bare delvise observasjoner eller støyende informasjon om miljøets sanne tilstand. Målet er å finne en policy som maksimerer den forventede kumulative belønningen over tid samtidig som usikkerheten i miljøet og agentens observasjoner vurderes.

Kilde: Researchgate

Kilde: Researchgate

I sammenheng med selvkjørende biler er POMDP spesielt nyttig for oppgaver som bevegelsesplanlegging, baneprediksjon og interaksjon med andre trafikanter. Den selvkjørende bilen kan bruke POMDP til å ta beslutninger om filskifte, hastighetsjusteringer og interaksjoner med fotgjengere og andre kjøretøy, med tanke på usikkerheten i omgivelsene.

POMDP har seks komponenter, og det kan betegnes som POMDP

M:= (I, S, A, R, P, γ)

hvor,

I: Observasjoner

S: Begrenset sett med tilstander

A: Begrenset sett med handlinger

R: Belønningsfunksjon

P: Overgangssannsynlighetsfunksjon

γ: diskonteringsfaktor for fremtidige belønninger.

POMDP-er kan være beregningsmessig utfordrende på grunn av behovet for å vurdere flere mulige tilstander og observasjoner. Imidlertid brukes avanserte algoritmer, som trosromsplanlegging og Monte Carlo-metoder, ofte for å effektivt tilnærme den optimale politikken og muliggjøre sanntids beslutningstaking i selvkjørende biler.

Ved å inkorporere POMDP i sine beslutningsalgoritmer, kan selvkjørende biler navigere i komplekse og usikre miljøer mer effektivt og trygt, med tanke på usikkerheten i sensoravlesninger og ta informerte beslutninger for å nå de tiltenkte målene.

Den selvkjørende bilen, som fungerer som en agent, lærer ved å samhandle med miljøet med forsterkningslæring (RL), en slags maskinlæring. Tilstand, handling og belønning er de tre viktige variablene i kjernen av Deep Reinforcement Learning (DRL).

Tilstand: Beskriver den nåværende situasjonen til den selvkjørende bilen på et gitt tidspunkt, for eksempel dens posisjon på veien.

Handling: Representerer alle mulige bevegelser som bilen kan gjøre, inkludert beslutninger som filskifte eller hastighetsjusteringer.

Belønning: Gir tilbakemelding til bilen hver gang den tar en bestemt handling. Belønningen kan være positiv eller negativ, og målet med DRL er å maksimere de kumulative belønningene.

I motsetning til overvåket læring, hvor algoritmen eksplisitt gis de riktige handlingene, lærer DRL ved å utforske miljøet og motta belønninger basert på handlingene. Den selvkjørende bilens nevrale nettverk er trent på persepsjonsdata, som inkluderer funksjoner hentet ut av konvolusjonelle nevrale nettverk (CNN).

DRL-algoritmer trenes deretter på disse representasjonene, som er lavere dimensjonale transformasjoner av inngangen, noe som resulterer i mer effektiv beslutningstaking under inferens.

Å trene selvkjørende biler i virkelige scenarier er farlig og upraktisk. I stedet er de opplært i simulatorer, hvor det ikke er noen risiko for menneskelig sikkerhet.

Simulator

Simulator

Noen åpen kildekode-simulatorer er:

Ved å kombinere persepsjonsdata med forsterkende læring, kan selvkjørende biler lære å navigere i komplekse miljøer, ta trygge og optimale beslutninger og bli flinkere til å håndtere kjørescenarier i den virkelige verden.

Vanlige spørsmål

Hva er autonome kjøretøy?

Autonome kjøretøy, ofte referert til som selvkjørende biler, er biler med banebrytende sensorer og kunstig intelligens som kan navigere og kjøre på egenhånd. Disse kjøretøyene vurderer miljøet og foretar kjørevurderinger ved hjelp av kameraer, LiDAR, RADAR og sofistikerte algoritmer.

Er autonome kjøretøy trygge?

I utviklingen av selvkjørende biler kommer sikkerhet først. For å sikre at de overholder høye sikkerhetsforskrifter, gjennomgår disse kjøretøyene grundig testing og simulering. Selv om det har vært hendelser under testing, er det endelige målet å gjøre selvkjørende biler sikrere enn menneskedrevne biler.

Kan autonome kjøretøy brukes uansett vær?

Ekstremt vær, inkludert kraftig regn eller snø, kan by på problemer for selvkjørende biler. Ugunstig vær kan redusere nøyaktigheten til sensorer og svekke kjøreevnen. Ingeniører prøver hele tiden å få teknologien til å fungere bedre under ugunstige værforhold.

Autonome kjøretøy – er de tillatt?

Lovligheten til autonome kjøretøy varierer etter nasjon og sted. For å imøtekomme autonome kjøretøy, reviderer mange jurisdiksjoner sine lover og forskrifter. Selvkjørende biltesting og begrenset utplassering er allerede tillatt i enkelte områder.

Trenger autonome kjøretøy menneskelig inngripen?

De fleste tilgjengelige selvkjørende biler er på nivå 2 eller nivå 3 automatisering, hvor de kan trenge menneskelig hjelp noen ganger. Industrien streber imidlertid etter å nå høyere nivåer av automatisering, som nivå 4 eller nivå 5, hvor menneskelig intervensjon blir minimal eller unødvendig.

Konklusjon

Avslutningsvis har selvkjørende biler evnen til å transformere bilindustrien ved å forbedre veieffektiviteten og sikkerheten. Vi har sett på alle de essensielle komponentene som støtter disse autonome bilene, inkludert LiDAR, RADAR, kameraer og avanserte algoritmer.

Selv om fremgangen har vært lovende, er det fortsatt viktige utfordringer å takle. For tiden er selvkjørende biler på nivå 2 av nivå 5 av fremgang, og krever menneskelig inngripen i visse scenarier. Gjennom fortsatt engasjement og innovasjon nærmer vi oss imidlertid å oppnå full autonomi.

Viktige takeaways

Fremskrittsalgoritmer: Ytterligere optimalisering av algoritmer er avgjørende for å forbedre veioppfatningen, spesielt under utfordrende forhold der veimerking og skilt kan mangle.

Forbedring av sansemodalitet: Å forbedre nøyaktigheten og effektiviteten til sansemodaliteter for kartlegging og lokalisering vil være medvirkende til å oppnå høyere nivåer av autonomi.

Kjøretøy-til-kjøretøy-kommunikasjon: Å skape et koblet og intelligent veiøkosystem vil bli gjort mulig ved å forfølge kjøretøy-til-kjøretøy-kommunikasjon.

Menneske-maskin-interaksjon: Å oppmuntre offentlig aksept av selvkjørende teknologier vil kreve å undersøke og ta opp problemer knyttet til menneske-maskin-interaksjon.

Fremtidsutsikter: Til tross for vanskelighetene, er prestasjonene så langt bemerkelsesverdige, og med pågående samarbeid og forskning tilbyr selvkjørende biler potensialet til å gi et sikrere og mer effektivt transportmiljø for alle.

Vi er alle på samme reise mot helt autonome selvkjørende biler. Etter hvert som vi løser utfordringer og stimulerer til innovasjon, kommer vi nærmere en tid da kjøretøy styrer veiene våre jevnt, noe som forbedrer sikkerheten, miljøet og brukervennligheten for alle.

Du kan nå lære om romlig databehandling og dens anvendelse ved utvikling av selvkjørende biler.